- Автоэнкодеры: Гении или Мифы? Раскрываем Полный Потенциал и Скрытые Ловушки

- Основы Автоэнкодеров: Как Они Работают?

- Архитектура: Кодировщик и Декодировщик

- Цель и Функция Потерь

- Процесс Обучения

- Безграничные Возможности Автоэнкодеров: Где Они Сияют?

- Снижение Размерности и Визуализация Данных

- Обнаружение Аномалий

- Генерация Данных и Улучшение Изображений

- Передача Признаков (Feature Learning)

- Теневая Сторона: Ограничения и Подводные Камни

- Проблема Переобучения (Overfitting)

- Выбор Гиперпараметров

- Ограничения Классических Автоэнкодеров в Генерации Новых Данных

- Интерпретируемость Латентного Пространства

- Вычислительные Ресурсы

- Развитие Автоэнкодеров: Преодолевая Барьеры

- Вариационные Автоэнкодеры (VAEs)

- Разреженные Автоэнкодеры (Sparse Autoencoders)

- Денуазинговые Автоэнкодеры (Denoising Autoencoders)

- Сверточные Автоэнкодеры (Convolutional Autoencoders)

- Практические Советы для Разработчиков и Исследователей

- Когда Стоит Использовать Автоэнкодеры

- Как Избежать Распространенных Ошибок

Автоэнкодеры: Гении или Мифы? Раскрываем Полный Потенциал и Скрытые Ловушки

В мире машинного обучения и искусственного интеллекта есть концепции, которые кажутся одновременно простыми и удивительно мощными. Одной из таких концепций, безусловно, являются автоэнкодеры. Мы, как исследователи и практики, часто сталкиваемся с ними в самых разных областях — от обработки изображений до анализа текстовых данных. Они обещают волшебное сжатие информации, извлечение скрытых признаков и даже генерацию новых данных. Но так ли все просто на самом деле? В этой статье мы погрузимся в глубины автоэнкодеров, исследуем их бесспорные возможности и откровенно поговорим об ограничениях, с которыми мы сталкиваемся на практике.

Мы не будем ограничиваться сухой теорией. Наш опыт показывает, что истинное понимание приходит через призму реальных задач и вызовов. Автоэнкодеры – это не панацея, но в умелых руках они становятся невероятно эффективным инструментом. Мы хотим поделиться с вами нашим видением, основанным на многочисленных экспериментах и проектах, чтобы вы могли максимально использовать потенциал этих увлекательных моделей и при этом избежать типичных ошибок.

Основы Автоэнкодеров: Как Они Работают?

Прежде чем говорить о возможностях и ограничениях, давайте кратко вспомним, что же такое автоэнкодер и как он функционирует. По своей сути, автоэнкодер, это нейронная сеть, предназначенная для обучения эффективному сжатию и реконструкции своих собственных входных данных. То есть, на входе и на выходе у него одни и те же данные. Это может показаться контринтуитивным, ведь зачем сети просто копировать то, что ей дали? Однако вся магия кроется в "бутылочном горлышке" архитектуры.

Цель автоэнкодера, научиться представлять данные в более компактной, низкоразмерной форме, называемой латентным пространством или скрытым представлением. Мы заставляем сеть извлекать наиболее важные и информативные признаки, отбрасывая шум и избыточность. Именно это свойство делает их такими ценными для множества задач, о которых мы поговорим далее.

Архитектура: Кодировщик и Декодировщик

Классический автоэнкодер состоит из двух основных частей: кодировщика (encoder) и декодировщика (decoder).

- Кодировщик: Это часть сети, которая принимает входные данные (например, изображение, вектор признаков) и преобразует их в скрытое представление в латентном пространстве. Обычно кодировщик представляет собой последовательность слоев, которые постепенно уменьшают размерность данных, сжимая их до компактного вектора. Представьте, что это "фильтр", который выделяет самую суть информации.

- Декодировщик: Эта часть сети, наоборот, берет сжатое представление из латентного пространства и пытается восстановить исходные входные данные. Декодировщик обычно является зеркальным отражением кодировщика по архитектуре, постепенно увеличивая размерность данных до оригинального размера. Его задача — "развернуть" сжатую информацию обратно в читаемую форму.

Между кодировщиком и декодировщиком находится тот самый "бутылочное горлышко" – слой латентного пространства, который имеет существенно меньшее количество нейронов, чем входной и выходной слои. Это принуждает сеть учиться наиболее эффективным способам кодирования информации.

Цель и Функция Потерь

Основная цель автоэнкодера, минимизировать ошибку реконструкции. Мы хотим, чтобы выходные данные сети были как можно более похожи на входные. Для этого мы используем функцию потерь (loss function), которая измеряет разницу между входными данными и их реконструированной версией.

Наиболее часто используемые функции потерь включают:

- Среднеквадратичная ошибка (Mean Squared Error, MSE): Обычно применяется для непрерывных данных, таких как значения пикселей изображений или числовые векторы. Она измеряет сумму квадратов разностей между соответствующими элементами входного и выходного векторов.

- Бинарная кросс-энтропия (Binary Cross-Entropy): Часто используется для бинарных или категориальных данных, а также для изображений, где пиксели нормализованы в диапазон [0, 1] и могут рассматриваться как вероятности.

В процессе обучения автоэнкодер настраивает свои внутренние веса таким образом, чтобы значение функции потерь было минимальным. Это означает, что он научился эффективно кодировать и декодировать информацию.

Процесс Обучения

Обучение автоэнкодера, по сути, ничем не отличается от обучения любой другой нейронной сети с помощью метода обратного распространения ошибки (backpropagation) и градиентного спуска.

- Мы подаем пакет данных на вход кодировщика.

- Кодировщик преобразует эти данные в латентное представление.

- Декодировщик принимает это представление и пытается восстановить исходные данные.

- Мы вычисляем ошибку реконструкции, сравнивая исходные данные с восстановленными, используя выбранную функцию потерь.

- Градиенты этой ошибки распространяются обратно через всю сеть (через декодировщик, а затем через кодировщик), и веса сети корректируются, чтобы уменьшить ошибку.

Этот процесс повторяется на множестве эпох, пока ошибка реконструкции не стабилизируется на приемлемом уровне. Важно отметить, что автоэнкодеры являются моделями без учителя (unsupervised learning), поскольку им не требуются размеченные данные; они учатся на самих входных данных. Это одно из их ключевых преимуществ.

Безграничные Возможности Автоэнкодеров: Где Они Сияют?

Теперь, когда мы освежили в памяти основы, давайте поговорим о том, почему автоэнкодеры так ценятся в нашем арсенале инструментов машинного обучения. Их способности простираются далеко за пределы простого копирования данных. Мы обнаружили, что они проявляют себя как настоящие "швейцарские ножи" в самых разных сценариях.

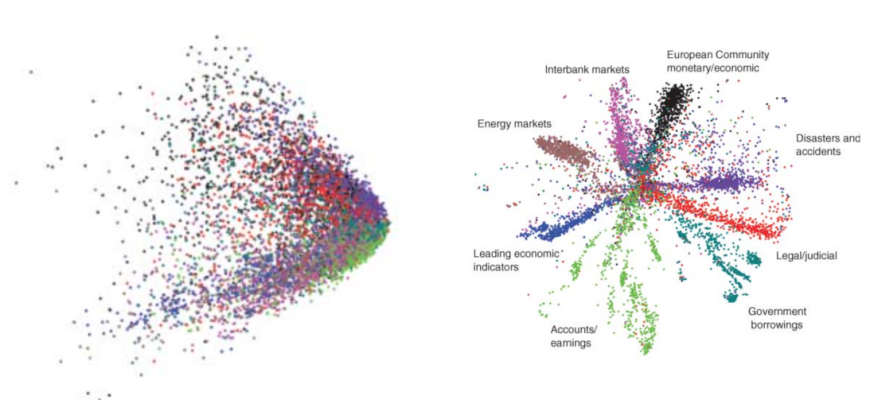

Снижение Размерности и Визуализация Данных

Одной из наиболее очевидных и широко используемых возможностей автоэнкодеров является снижение размерности. В реальном мире мы часто сталкиваемся с данными, имеющими тысячи или даже десятки тысяч признаков. Работа с такими высокоразмерными данными может быть вычислительно дорогой и склонной к "проклятию размерности". Автоэнкодеры предлагают элегантное решение.

Поскольку латентное пространство по определению имеет меньшую размерность, чем входные данные, кодировщик эффективно проецирует высокоразмерные данные в это компактное представление, сохраняя при этом наиболее важную информацию. Это делает их мощной альтернативой таким методам, как PCA (анализ главных компонент), особенно когда речь идет о нелинейных зависимостях в данных.

Преимущества снижения размерности с помощью автоэнкодеров:

- Улучшение производительности других моделей: Снижение размерности может помочь классификаторам и регрессорам работать быстрее и с лучшей обобщающей способностью, уменьшая шум.

- Визуализация данных: Если мы сжимаем данные до 2-х или 3-х измерений, мы можем напрямую визуализировать их на графике, что позволяет обнаружить кластеры, выбросы и другие скрытые структуры, которые были бы невидимы в исходном пространстве. Мы часто используем это для первоначального исследования больших и сложных наборов данных.

- Экономия памяти: Хранение данных в сжатом латентном представлении требует значительно меньше памяти.

Обнаружение Аномалий

Это одна из областей, где автоэнкодеры проявляют себя особенно ярко. Идея проста: мы обучаем автоэнкодер на "нормальных" или типичных данных. Сеть учится идеально реконструировать эти нормальные образцы, поскольку она видела их много раз; Когда же на вход подается аномальный образец — то, чего сеть никогда не видела или видела очень редко, она испытывает трудности с его реконструкцией.

Как это работает на практике?

- Обучение на нормальных данных: Мы собираем большой набор данных, который, как мы знаем, представляет "нормальное" поведение системы (например, типичные транзакции, обычные показания датчиков, здоровые медицинские снимки).

- Вычисление ошибки реконструкции: После обучения мы пропускаем новые данные через автоэнкодер и измеряем ошибку реконструкции для каждого образца.

- Порог аномалии: Образцы с высокой ошибкой реконструкции (то есть те, которые автоэнкодер плохо восстановил) считаются потенциальными аномалиями. Мы устанавливаем порог, выше которого образец маркируется как аномальный.

Этот подход оказывается очень эффективным в задачах обнаружения мошенничества, мониторинга оборудования, выявления сетевых вторжений и диагностики заболеваний, где аномалии редки и плохо определены.

Генерация Данных и Улучшение Изображений

Хотя классические автоэнкодеры не предназначены для генерации новых, разнообразных данных, их модификации, такие как вариационные автоэнкодеры (VAEs), открыли двери для потрясающих генеративных возможностей. VAEs не просто сжимают данные, они учатся параметризованному распределению латентного пространства, что позволяет нам "сэмплировать" из этого распределения и генерировать совершенно новые, но реалистичные образцы. Мы успешно применяли VAEs для создания новых лиц, интерполяции между изображениями и даже для синтеза коротких музыкальных фрагментов.

Другое важное применение — улучшение изображений:

- Удаление шума (Denoising): Мы можем обучить автоэнкодер восстанавливать чистое изображение из его зашумленной версии. Для этого мы искусственно добавляем шум к входным изображениям во время обучения, а в качестве целевого выхода используем оригинальные, чистые изображения. Это невероятно полезно в фотографии, медицине и спутниковых снимках.

- Увеличение разрешения (Super-resolution): Хотя это более сложная задача, автоэнкодеры могут быть частью систем, которые восстанавливают высокоразрешенные изображения из низкоразрешенных, "додумывая" недостающие детали.

- Заполнение пропусков (Inpainting): Автоэнкодеры могут "дорисовывать" отсутствующие части изображения, предсказывая их содержимое на основе окружающего контекста.

Передача Признаков (Feature Learning)

Одним из самых мощных, но часто недооцениваемых аспектов автоэнкодеров является их способность к автоматическому обучению признаков. Вместо того, чтобы вручную разрабатывать признаки для задачи (что может быть трудоемким и неэффективным), автоэнкодеры могут самостоятельно извлекать значимые и высокоуровневые представления из сырых данных.

Латентное представление, которое создает кодировщик, само по себе является мощным набором признаков. Эти признаки часто более абстрактны и информативны, чем исходные, и могут быть использованы в качестве входа для других моделей машинного обучения (например, классификаторов или кластеризаторов). Мы часто используем предобученный кодировщик как средство извлечения признаков, что значительно ускоряет разработку и повышает точность в последующих задачах.

Примеры использования:

- Обработка естественного языка: Автоэнкодеры могут учиться плотным представлениям слов или предложений (word embeddings), которые захватывают семантические отношения.

- Компьютерное зрение: Извлечение высокоуровневых признаков из изображений, таких как края, текстуры или формы объектов, которые затем используются для распознавания объектов или классификации.

Сводная таблица основных применений автоэнкодеров:

| Применение | Суть | Типичные задачи |

|---|---|---|

| Снижение размерности | Преобразование высокоразмерных данных в компактное представление. | Визуализация, предобработка данных для классификации. |

| Обнаружение аномалий | Идентификация образцов, которые плохо реконструируются моделью, обученной на "нормальных" данных. | Мониторинг, кибербезопасность, медицинская диагностика. |

| Обучение признаков | Автоматическое извлечение информативных представлений из сырых данных. | Предобучение для других моделей, создание эмбеддингов. |

| Генерация данных | Создание новых, реалистичных образцов (через VAE). | Синтез изображений, текста, музыки. |

| Улучшение качества данных | Восстановление или очистка данных. | Удаление шума, заполнение пропусков, увеличение разрешения. |

Теневая Сторона: Ограничения и Подводные Камни

При всей своей универсальности и мощи, автоэнкодеры не являются волшебной пилюлей. Мы на своем опыте убедились, что они имеют ряд существенных ограничений и "подводных камней", о которых важно знать, прежде чем бросаться в их использование. Игнорирование этих аспектов может привести к разочарованию и потере времени.

Проблема Переобучения (Overfitting)

Это, пожалуй, одно из самых распространенных ограничений. Если архитектура автоэнкодера слишком "широкая" или "глубокая", особенно если размер латентного пространства слишком велик по отношению к сложности данных, модель может просто научится идентичной функции. То есть, кодировщик просто запомнит входные данные, а декодировщик научится их воспроизводить без какого-либо реального сжатия или извлечения признаков. Ошибка реконструкции будет близка к нулю, но модель не будет обладать никакой обобщающей способностью и будет бесполезна для новых, не виденных ранее данных.

Мы боремся с переобучением, используя несколько стратегий:

- Уменьшение размера латентного пространства: Это самый прямой способ заставить сеть учиться сжатию.

- Регуляризация: Применение L1/L2 регуляризации к весам сети.

- Dropout: Отключение случайной части нейронов во время обучения.

- Добавление шума: Обучение денуазинговых автоэнкодеров, которые более устойчивы к шуму и лучше извлекают значимые признаки.

Выбор Гиперпараметров

Как и в случае с любой нейронной сетью, производительность автоэнкодера сильно зависит от выбора гиперпараметров. И это может быть настоящим испытанием.

Ключевые гиперпараметры включают:

- Размер латентного пространства: Слишком большой — риск переобучения, слишком маленький — недостаточная способность к реконструкции.

- Количество слоев и нейронов в каждом слое: Определяет сложность модели.

- Функция активации: ReLU, Leaky ReLU, Sigmoid, Tanh и т.д.

- Оптимизатор: Adam, SGD, RMSprop.

- Скорость обучения: Слишком высокая — пропуск оптимума, слишком низкая — медленное обучение.

- Количество эпох: Достаточное для сходимости, но не чрезмерное.

Мы часто тратим значительное время на эксперименты с различными комбинациями гиперпараметров, используя методы, такие как Grid Search или Random Search, чтобы найти оптимальную конфигурацию. Отсутствие четких эмпирических правил для всех типов данных делает этот процесс итеративным и порой утомительным.

Ограничения Классических Автоэнкодеров в Генерации Новых Данных

Как мы упоминали, классические автоэнкодеры прекрасно справляются с реконструкцией данных, но они не предназначены для генерации принципиально новых, разнообразных образцов. Причина в том, что латентное пространство обычного автоэнкодера не является "непрерывным" или "структурированным" в том смысле, что случайные точки из него не обязательно дадут осмысленные выходы.

Если мы возьмем случайный вектор из латентного пространства классического автоэнкодера и подадим его на декодировщик, мы, скорее всего, получим бессмысленный шум или что-то, что очень отдаленно напоминает исходные данные. Это связано с тем, что обычный автоэнкодер не накладывает никаких ограничений на распределение латентного пространства. Это фундаментальное ограничение привело к разработке более сложных генеративных моделей, таких как VAEs и GANs.

Интерпретируемость Латентного Пространства

Хотя автоэнкодеры учатся извлекать важные признаки, понимание того, что именно представляют собой эти признаки в латентном пространстве, может быть невероятно сложным. В отличие от PCA, где каждая компонента является линейной комбинацией исходных признаков и часто имеет некоторую интерпретируемость (например, "размер" или "ориентация"), скрытые признаки автоэнкодера часто являются нелинейными, абстрактными и сильно переплетенными.

Мы можем визуализировать латентное пространство (если оно 2D или 3D), но даже тогда бывает трудно однозначно сказать, что означает та или иная ось или кластер. Это делает автоэнкодеры в некотором смысле "черным ящиком", что может быть проблемой в областях, требующих высокой степени объяснимости (например, в медицине или юриспруденции).

"The greatest challenge for neural networks is not to perform tasks, but to explain their decisions."

— Jürgen Schmidhuber, один из пионеров в области глубокого обучения.

Эта цитата Юргена Шмидхубера прекрасно отражает нашу дилемму с интерпретируемостью. Мы хотим, чтобы модели работали, но еще больше мы хотим понимать, как они это делают.

Вычислительные Ресурсы

Обучение глубоких автоэнкодеров, особенно сверточных или вариационных, может быть весьма ресурсоемким. Для больших наборов данных и сложных архитектур требуются значительные вычислительные мощности, часто с использованием графических процессоров (GPU). Это может стать барьером для отдельных исследователей или небольших команд с ограниченным бюджетом.

Мы сталкиваемся с необходимостью оптимизации архитектуры, использования эффективных библиотек и фреймворков (таких как TensorFlow или PyTorch), а также облачных вычислительных ресурсов для масштабных проектов. Время обучения может варьироваться от нескольких минут до нескольких дней или даже недель, в зависимости от размера данных и сложности модели.

Развитие Автоэнкодеров: Преодолевая Барьеры

К счастью, научное сообщество не стояло на месте, осознавая эти ограничения. За последние годы появилось множество модификаций и улучшений классических автоэнкодеров, которые позволили преодолеть многие из вышеупомянутых проблем и расширить их применимость. Мы активно используем эти продвинутые архитектуры в нашей работе.

Вариационные Автоэнкодеры (VAEs)

Как мы уже упоминали, вариационные автоэнкодеры (VAEs) стали настоящим прорывом в области генерации данных. Их ключевое отличие от классических автоэнкодеров заключается в том, что кодировщик не просто выводит вектор латентного пространства, а параметризует распределение (обычно гауссово) в латентном пространстве. То есть, для каждого входного образца кодировщик выводит не одну точку, а среднее значение и дисперсию распределения.

Это принуждает латентное пространство быть непрерывным и гладким, что позволяет нам:

- Генерировать новые данные: Мы можем сэмплировать случайные точки из этого распределения и передавать их декодировщику для создания совершенно новых, но реалистичных образцов.

- Интерполировать между образцами: Плавно перемещаясь по латентному пространству, мы можем генерировать промежуточные образцы, демонстрируя "понимание" моделью скрытых факторов вариации.

VAEs оказались чрезвычайно эффективными для синтеза изображений, аудио и текста, хоть и имеют свои сложности в обучении, связанные с необходимостью оптимизировать не только ошибку реконструкции, но и дивергенцию Кульбака-Лейблера между выученным распределением и заданным априорным (часто стандартным нормальным).

Разреженные Автоэнкодеры (Sparse Autoencoders)

Для задач, где мы хотим получить более интерпретируемые и "чистые" признаки, мы обращаемся к разреженным автоэнкодерам. В этих моделях мы добавляем штраф (регуляризацию) к функции потерь, который поощряет активацию только небольшого подмножества нейронов в скрытом слое для каждого входного образца. Это означает, что большинство нейронов в латентном слое будут иметь нулевые или близкие к нулю значения для данного входа.

Преимущества разреженных автоэнкодеров:

- Улучшенное извлечение признаков: Каждый нейрон в скрытом слое вынужден специализироваться на обнаружении конкретной характеристики данных.

- Меньшая склонность к переобучению: Разреженность действует как форма регуляризации.

- Более интерпретируемые признаки: Мы можем легче понять, какие характеристики активируют конкретный нейрон.

Мы применяем их, когда хотим получить набор "базовых" признаков, которые могут быть полезны для последующих задач классификации или кластеризации.

Денуазинговые Автоэнкодеры (Denoising Autoencoders)

Как уже упоминалось, денуазинговые автоэнкодеры — это мощный инструмент для обучения устойчивым представлениям данных. Вместо того, чтобы восстанавливать входные данные из их чистого вида, они обучаются восстанавливать оригинальные, неиспорченные данные из их зашумленной версии.

Процесс обучения:

- Мы берем чистый входной образец.

- Искусственно добавляем к нему шум (например, гауссовский шум, маскирование пикселей).

- Подаем зашумленный образец на вход кодировщика.

- Декодировщик пытается восстановить оригинальный, чистый образец.

Таким образом, сеть учится отличать истинные характеристики данных от шума, что делает ее представления более надежными и робастными. Это особенно полезно в реальных условиях, где данные почти всегда содержат некоторый уровень шума.

Сверточные Автоэнкодеры (Convolutional Autoencoders)

Для работы с изображениями и другими данными, имеющими пространственную структуру, сверточные автоэнкодеры (CAEs) являются предпочтительным выбором. Они используют сверточные слои в кодировщике и транспонированные сверточные (или деконволюционные) слои в декодировщике, что позволяет им эффективно работать с двумерными данными, сохраняя пространственные отношения.

Преимущества CAEs:

- Эффективность для изображений: Сверточные слои естественным образом извлекают иерархические признаки, такие как края, текстуры и паттерны.

- Меньшее количество параметров: По сравнению с полносвязными автоэнкодерами для изображений, сверточные сети имеют значительно меньше параметров, что снижает риск переобучения и ускоряет обучение.

- Понимание локальных паттернов: Они хорошо улавливают локальные пространственные зависимости, которые важны для визуальных данных.

Мы активно используем CAEs для задач уменьшения размерности изображений, обнаружения аномалий на медицинских снимках и предобработки данных для систем компьютерного зрения.

Сравнительная таблица различных типов автоэнкодеров:

| Тип Автоэнкодера | Ключевая особенность | Основные преимущества | Типичные применения |

|---|---|---|---|

| Классический (Undercomplete) | Латентное пространство меньше входа/выхода. | Снижение размерности, обучение признаков. | Визуализация данных, предобработка. |

| Вариационный (VAE) | Кодировщик выводит параметры распределения в латентном пространстве. | Генерация новых данных, плавное латентное пространство. | Синтез изображений, музыки, текста. |

| Разреженный (Sparse) | Регуляризация для малой активации нейронов в скрытом слое. | Интерпретируемые признаки, устойчивость к переобучению. | Извлечение специализированных признаков. |

| Денуазинговый (Denoising) | Восстанавливает чистые данные из зашумленного входа. | Робастные признаки, удаление шума. | Очистка данных, предобработка, обучение признаков. |

| Сверточный (Convolutional) | Использует сверточные слои для обработки пространственных данных. | Эффективен для изображений, меньше параметров. | Обработка изображений, компьютерное зрение. |

Практические Советы для Разработчиков и Исследователей

Наш многолетний опыт работы с автоэнкодерами позволил нам выработать ряд практических советов, которые мы хотим передать вам. Они помогут вам более эффективно использовать этот инструмент и избегать распространенных ошибок.

Когда Стоит Использовать Автоэнкодеры

- У вас много неразмеченных данных: Автоэнкодеры — это модели без учителя, которым не нужны метки. Если у вас огромный объем сырых данных, но мало размеченных, автоэнкодеры могут помочь извлечь из них пользу.

- Вам нужно уменьшить размерность данных: Если ваши данные высокоразмерны, а традиционные методы (например, PCA) не справляются с нелинейными зависимостями, автоэнкодеры могут найти более эффективные низкоразмерные представления.

- Вы хотите обнаружить аномалии: Если аномалии редки и плохо определены, обучение автоэнкодера на нормальных данных и использование ошибки реконструкции — это мощный подход.

- Вам нужны качественные признаки для других моделей: Вместо ручного инжиниринга признаков, используйте кодировщик автоэнкодера для автоматического извлечения богатых представлений;

- Вы работаете с зашумленными данными: Денуазинговые автоэнкодеры, отличный способ очистить данные и сделать представления более робастными.

- Вам нужна генерация новых данных (с VAEs): Если ваша задача, синтез изображений, текста или других данных, VAEs могут быть мощным выбором.

Как Избежать Распространенных Ошибок

- Не делайте латентное пространство слишком большим: Это самая частая причина переобучения. Начните с очень маленького латентного пространства и постепенно увеличивайте его, если реконструкция страдает.

- Используйте регуляризацию: Dropout, L1/L2 регуляризация, а также применение разреженности для разреженных автоэнкодеров — ваши лучшие друзья в борьбе с переобучением.

- Нормализуйте входные данные: Как и для большинства нейронных сетей, нормализация данных (например, масштабирование к диапазону [0, 1] или стандартизация) критически важна для стабильного и быстрого обучения.

- Тщательно выбирайте функцию потерь: MSE для непрерывных данных, бинарная кросс-энтропия для бинарных или изображений с пикселями [0,1]. Неправильный выбор может замедлить сходимость или привести к плохим результатам.

- Экспериментируйте с архитектурой: Начните с простой архитектуры (например, 2-3 слоя в кодировщике/декодировщике) и постепенно усложняйте ее. Симметричные архитектуры (зеркальное отражение кодировщика в декодировщике) часто работают хорошо.

- Визуализируйте латентное пространство: Используйте t-SNE или UMAP для визуализации латентного пространства, чтобы понять, насколько хорошо автоэнкодер группирует похожие данные. Это поможет выявить проблемы с обучением.

- Следите за ошибкой реконструкции: Если ошибка реконструкции на валидационном наборе начинает расти, это явный признак переобучения.

- Рассмотрите специализированные автоэнкодеры: Если вы работаете с изображениями, используйте сверточные автоэнкодеры. Если нужна генерация, обратите внимание на VAEs. Не бойтесь выходить за рамки классической архитектуры.

Итак, мы провели вас по увлекательному миру автоэнкодеров — от их фундаментальных принципов до продвинутых архитектур и практических советов. Мы увидели, что эти модели обладают огромным потенциалом в задачах снижения размерности, обнаружения аномалий, обучения признаков и даже генерации данных. Они являются незаменимым инструментом в нашем арсенале, особенно когда речь идет о неразмеченных данных.

В то же время, мы честно поговорили об их ограничениях: риске переобучения, сложности выбора гиперпараметров, вычислительных затратах и проблемах с интерпретируемостью. Мы подчеркнули, что автоэнкодеры, как и любой другой мощный инструмент, требуют вдумчивого подхода и понимания их сильных и слабых сторон. Неверное применение может привести к разочарованию, тогда как осознанное использование раскрывает их истинную мощь.

Наш опыт показывает, что ключ к успеху лежит в экспериментировании, глубоком понимании ваших данных и готовности адаптировать архитектуры под конкретные задачи. Мир автоэнкодеров постоянно развивается, и появление новых модификаций и техник лишь подтверждает их актуальность и важность. Мы надеемся, что эта статья вдохновила вас на собственные исследования и помогла вам лучше ориентироваться в этой захватывающей области машинного обучения;

Подробнее

| Обучение автоэнкодеров | Применение автоэнкодеров | Снижение размерности нейронные сети | Обнаружение аномалий машинное обучение | Вариационные автоэнкодеры VAE |

| Генерация данных ИИ | Сверточные автоэнкодеры CAE | Ограничения нейронных сетей | Без учителя обучение | Латентное пространство |