- Генеративные Состязательные Сети: Почему Дискриминатор – Наш Главный Критик и Тайный Учитель

- Основы GANs: Встречаемся с Генератором и Дискриминатором

- Аналогия, чтобы Все Стало Понятно

- Дискриминатор: Не Просто Детектор, а Наставник Генератора

- Как Работает Дискриминатор: Архитектура и Обучение

- Таблица: Основные Компоненты Дискриминатора

- Вызовы и Проблемы в Роли Дискриминатора

- Перетренировка Дискриминатора (Discriminator Overtraining)

- Нестабильность Обучения

- Коллапс Мод (Mode Collapse)

- Эволюция Дискриминатора: От DCGAN до WGAN

- DCGAN: Сверточные Сети в Действии

- WGAN: Новый Взгляд на Функцию Потерь

- Дальнейшие Улучшения: WGAN-GP, LSGAN и Другие

- Дискриминатор за Пределами Генерации Изображений

- Обнаружение Аномалий (Anomaly Detection)

- Улучшение Качества Изображений (Image Enhancement)

- Синтез Текста и Аудио

- Дополнение Данных (Data Augmentation)

- Будущее Дискриминатора: Еще Более Умный Учитель

Генеративные Состязательные Сети: Почему Дискриминатор – Наш Главный Критик и Тайный Учитель

Привет, дорогие читатели и пытливые умы нашего блога! Сегодня мы погрузимся в один из самых увлекательных и порой загадочных уголков современного машинного обучения – мир Генеративных Состязательных Сетей, или GANs. Мы знаем, что для многих это звучит как нечто из научно-фантастического фильма, но поверьте, это гораздо ближе к реальности, чем кажется. И в сердце этой реальности лежит невидимая, но невероятно мощная фигура – дискриминатор. Именно ему мы и посвятим наше сегодняшнее глубокое исследование, пытаясь понять его истинную роль: не просто как детектора подделок, но как истинного учителя, который направляет творческий процесс искусственного интеллекта.

Мы все восхищаемся удивительными изображениями, которые способны создавать нейронные сети: лица, которых никогда не существовало, невероятные пейзажи, стилизация фотографий под произведения искусства. За всем этим стоит сложный, но элегантный танец двух нейронных сетей, каждая из которых играет свою уникальную партию. Но если генератор – это художник, то кто же тогда его критик, его наставник, его вечный оппонент, который заставляет его совершенствоваться? Да, вы угадали – это дискриминатор. Мы покажем вам, почему без его бдительного ока и бескомпромиссной оценки мир GANs был бы невозможен. Приготовьтесь, нас ждет увлекательное путешествие!

Основы GANs: Встречаемся с Генератором и Дискриминатором

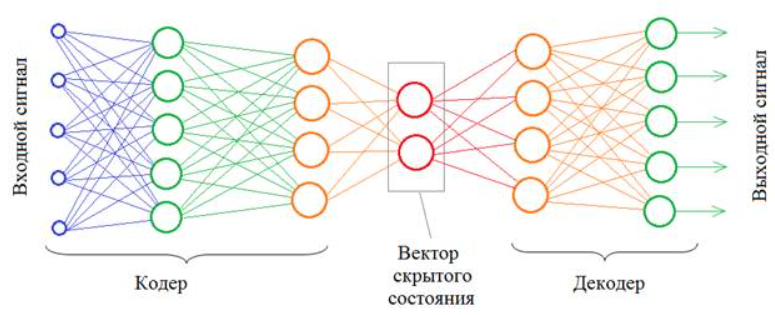

Прежде чем мы углубимся в тонкости работы дискриминатора, давайте кратко вспомним, что такое GAN в целом. Представьте себе дуэт: один пытается создать что-то настолько убедительное, чтобы обмануть другого, а второй изо всех сил старается распознать подделку. Это и есть суть Генеративных Состязательных Сетей. Мы имеем две нейронные сети:

- Генератор (Generator, G): Это наш художник, творец. Его задача – создавать новые данные, которые максимально похожи на реальные данные из обучающего набора. На вход он получает случайный шум (вектор латентного пространства) и преобразует его в нечто, что, как он надеется, будет выглядеть правдоподобно.

- Дискриминатор (Discriminator, D): А это наш критик, эксперт, детектив. Его задача – отличить "настоящие" данные (из обучающего набора) от "поддельных" (сгенерированных генератором). Он принимает на вход как реальные, так и сгенерированные данные и выдает вероятность того, что эти данные являются реальными.

Мы можем представить это как игру в кошки-мышки или, более академично, как игру с нулевой суммой. Генератор хочет минимизировать вероятность того, что дискриминатор правильно угадает источник данных (то есть, чтобы дискриминатор ошибался, принимая фейк за реальность). Дискриминатор, в свою очередь, хочет максимизировать эту вероятность (то есть, чтобы он всегда правильно определял, что является реальным, а что – сгенерированным). Это постоянное соревнование и есть двигатель прогресса в GANs.

Аналогия, чтобы Все Стало Понятно

Чтобы лучше понять эту динамику, мы часто используем простую, но очень наглядную аналогию. Представьте себе фальшивомонетчика (генератор) и детектива по подделкам (дискриминатор). Фальшивомонетчик изучает настоящие банкноты и пытается создать их идеальные копии. Детектив, в свою очередь, тщательно изучает настоящие банкноты и учится выявлять малейшие отличия в подделках. Сначала фальшивомонетчик делает очень грубые копии, и детектив легко их распознает. Но каждый раз, когда детектив успешно выявляет подделку, фальшивомонетчик учится на своих ошибках, делает свои копии все лучше и лучше. И наоборот, каждый раз, когда фальшивомонетчику удается кого-то обмануть, детектив понимает, что ему нужно стать еще более внимательным и улучшить свои методы распознавания. Этот бесконечный цикл улучшения и есть суть тренировки GAN.

Мы видим, что без строгого и постоянно улучшающегося детектива, фальшивомонетчик никогда бы не достиг такого мастерства. Именно в этом и заключается ключевая роль дискриминатора – он не просто оценивает, он обучает генератора, указывая ему на его недостатки и тем самым подталкивая к совершенству.

Дискриминатор: Не Просто Детектор, а Наставник Генератора

Итак, мы выяснили, что дискриминатор – это не просто пассивный наблюдатель, который говорит "да" или "нет". Его роль гораздо глубже и активнее. Мы можем смело назвать его учителем или наставником генератора. Почему?

Во время обучения дискриминатор получает как настоящие изображения, так и те, что сгенерировал наш художник. Он учится присваивать высоким вероятностям реальным изображениям и низким – сгенерированным. Именно эта "оценка" дискриминатора затем используется для обновления весов генератора. Если дискриминатор легко распознает подделки генератора, генератор получает четкий сигнал: "Твои работы недостаточно хороши, тебе нужно измениться". И генератор корректирует свои внутренние параметры, чтобы в следующий раз создать что-то более убедительное.

По сути, дискриминатор – это функция потерь для генератора. Он предоставляет генератору обратную связь о качестве его вывода. Без этой обратной связи генератор был бы слепцом, блуждающим в потемках случайности, никогда не зная, становится ли он лучше или хуже. Мы видим, что его существование критически важно для всего процесса обучения.

Как Работает Дискриминатор: Архитектура и Обучение

Давайте заглянем под капот дискриминатора. Как правило, дискриминатор – это обычная нейронная сеть, часто сверточная (если мы работаем с изображениями), которая на выходе имеет один нейрон с сигмоидной функцией активации. Эта функция выдает значение от 0 до 1, которое мы интерпретируем как вероятность того, что входные данные являються "реальными".

Процесс обучения дискриминатора выглядит следующим образом:

- Мы подаем ему реальные данные из нашего обучающего набора и обучаем его выдавать значение, близкое к 1 (т.е., "это реально").

- Затем мы подаем ему сгенерированные данные от генератора и обучаем его выдавать значение, близкое к 0 (т.е., "это подделка").

Эти два шага повторяются, позволяя дискриминатору стать все более искусным в различении двух типов данных. Функция потерь, которую мы обычно используем для дискриминатора, – это бинарная кросс-энтропия, которая эффективно измеряет, насколько хорошо дискриминатор справляется со своей задачей классификации.

Таблица: Основные Компоненты Дискриминатора

| Компонент | Описание | Пример |

|---|---|---|

| Входные данные | Как реальные образцы из датасета, так и сгенерированные генератором. | Изображения, текстовые фрагменты, аудиозаписи. |

| Архитектура сети | Обычно сверточная нейронная сеть (CNN) для изображений, или многослойный перцептрон (MLP). | Набор сверточных слоев, слоев пулинга, полносвязных слоев. |

| Выходной слой | Один нейрон с сигмоидной функцией активации. | Значение от 0 до 1, где 1 означает "реальный", 0 – "сгенерированный". |

| Функция потерь | Бинарная кросс-энтропия. | log(D(real)) + log(1 ― D(fake)) |

| Оптимизатор | Адаптивные алгоритмы, такие как Adam, RMSprop. | Adam Optimizer. |

Вызовы и Проблемы в Роли Дискриминатора

Хотя роль дискриминатора кажется простой – классифицировать данные – на практике его обучение и поддержание баланса с генератором сопряжены с целым рядом трудностей. Мы, как исследователи и разработчики, постоянно сталкиваемся с этими вызовами, пытаясь найти оптимальные решения.

Перетренировка Дискриминатора (Discriminator Overtraining)

Если дискриминатор становится слишком "умным" слишком быстро, он может легко и безошибочно отличать сгенерированные данные от реальных. В такой ситуации он всегда будет выдавать для сгенерированных данных очень низкие вероятности (близкие к 0). Это, казалось бы, хорошо, но для генератора это означает, что градиенты (сигналы об ошибке) будут очень слабыми или вовсе исчезнут (проблема исчезающих градиентов). Генератор перестанет получать адекватную обратную связь и не сможет улучшаться. Представьте себе учителя, который настолько суров и непогрешим, что ученик просто опускает руки, не понимая, как ему вообще можно хоть немного приблизиться к идеалу. Мы должны обеспечить, чтобы дискриминатор всегда был немного "отстающим", давая генератору шанс догнать его.

Нестабильность Обучения

Обучение GANs в целом известно своей нестабильностью. Это связано с тем, что мы одновременно оптимизируем две сети с противоположными целями. Это похоже на управление двумя кораблями в шторм, каждый из которых пытается плыть в противоположном направлении, но при этом они должны оставаться на одной линии. Небольшие изменения в одном могут вызвать большие колебания в другом. Дискриминатор может стать слишком сильным, или, наоборот, слишком слабым, что приводит к дисбалансу и коллапсу обучения. Мы часто видим, как в процессе обучения метрики начинают дико прыгать, а качество генерируемых изображений резко ухудшается.

Коллапс Мод (Mode Collapse)

Это одна из самых неприятных проблем. Если генератор обнаруживает, что может обмануть дискриминатор, создавая лишь очень узкий диапазон образцов (например, только один тип лица из множества возможных), он может начать производить только эти образцы. Дискриминатор не может его за это "наказать", потому что эти образцы действительно выглядят убедительно для него. В итоге, генератор теряет способность создавать разнообразие, и мы получаем множество одинаковых или очень похожих результатов. Роль дискриминатора здесь заключается в том, чтобы не позволить генератору "застрять" в одной точке, но это сложная задача, так как дискриминатор обычно не имеет явного механизма для оценки разнообразия.

"The only way to do great work is to love what you do. If you haven’t found it yet, keep looking. Don’t settle. As with all matters of the heart, you’ll know when you find it."

— Steve Jobs

(Хотя эта цитата не напрямую о GANs, она отражает нашу страсть к поиску и совершенствованию, что очень актуально для мира ИИ, где мы постоянно ищем лучшие подходы и не останавливаемся на достигнутом, особенно когда сталкиваемся с такими проблемами, как нестабильность GANs.)

Эволюция Дискриминатора: От DCGAN до WGAN

С момента появления GANs в 2014 году, роль и архитектура дискриминатора постоянно развивались, чтобы преодолеть вышеупомянутые проблемы. Мы были свидетелями нескольких ключевых прорывов, которые значительно улучшили стабильность и качество генерируемых моделей.

DCGAN: Сверточные Сети в Действии

Одним из первых значимых шагов стало применение глубоких сверточных сетей (Deep Convolutional GANs, DCGAN) как для генератора, так и для дискриминатора; Мы заменили полносвязные слои на сверточные, что позволило сетям лучше работать с пространственными и иерархическими признаками изображений. Дискриминатор в DCGAN, по сути, стал глубоким сверточным классификатором, который мог более тонко улавливать визуальные особенности, отличающие реальные изображения от поддельных. Это значительно улучшило качество генерируемых изображений и стало стандартом для многих последующих архитектур.

WGAN: Новый Взгляд на Функцию Потерь

Возможно, самым революционным изменением стало появление Wasserstein GAN (WGAN). Мы столкнулись с проблемой исчезающих градиентов и нестабильности из-за специфической функции потерь в классических GAN. WGAN предложил использовать другую метрику – земляной дистанции (Earth Mover’s Distance или Wasserstein distance) – для измерения различий между распределениями реальных и сгенерированных данных. Это потребовало существенного изменения роли дискриминатора: он перестал быть классификатором, выдающим вероятность, и стал критиком (critic), который оценивает "стоимость" или "расстояние" между реальными и сгенерированными данными. Этот критик не использует сигмоидный выходной слой и не обучен классификации 0/1; вместо этого он обучен максимизировать разницу между "критикой" реальных и поддельных данных. Мы обнаружили, что это значительно улучшило стабильность обучения и позволило бороться с коллапсом мод, так как градиенты стали более информативными даже при низком качестве генерации.

Дальнейшие Улучшения: WGAN-GP, LSGAN и Другие

После WGAN последовало множество других улучшений, каждое из которых тем или иным образом влияло на дискриминатор:

- WGAN-GP (Gradient Penalty): Мы добавили штраф за градиент к функции потерь дискриминатора, чтобы обеспечить выполнение условия Липшица, необходимого для корректной работы WGAN. Это еще больше повысило стабильность.

- LSGAN (Least Squares GAN): Вместо кросс-энтропии мы использовали среднеквадратичную ошибку (MSE) в качестве функции потерь для дискриминатора. Это помогло сгладить градиенты и уменьшить проблему исчезающих градиентов.

- Conditional GANs (CGAN): Здесь дискриминатор получает не только изображение, но и дополнительную информацию (например, метку класса). Его задача – определить, соответствует ли изображение заданной метке и является ли оно реальным. Мы научили его не просто отличать реальность от вымысла, но и проверять, насколько хорошо генератор следует инструкциям.

Каждое из этих новшеств подчеркивает, насколько центральной является роль дискриминатора. Мы постоянно ищем способы сделать его более эффективным, стабильным и информативным, потому что от его "критической" способности напрямую зависит качество "творчества" генератора.

Дискриминатор за Пределами Генерации Изображений

Хотя GANs в первую очередь ассоциируются с генерацией изображений, мы хотим подчеркнуть, что роль дискриминатора далеко не ограничивается этой областью. Его способность отличать "нормальное" от "аномального", "реальное" от "сгенерированного" делает его бесценным инструментом во многих других задачах.

Обнаружение Аномалий (Anomaly Detection)

Представьте, что мы обучаем GAN на наборе "нормальных" данных (например, показаний датчиков в промышленном оборудовании или записей сетевого трафика). Генератор учится создавать образцы, похожие на нормальные. Дискриминатор, в свою очередь, становится экспертом в распознавании всего, что отклоняется от этой "нормальности". Когда на вход дискриминатора поступают новые данные, которые он классифицирует как "сгенерированные" (то есть, не похожие на реальные, на которых он обучался), это может быть сильным индикатором аномалии. Мы используем этот подход для выявления мошенничества, неисправностей оборудования или вторжений в сеть.

Улучшение Качества Изображений (Image Enhancement)

В задачах суперразрешения (увеличения разрешения изображения) или удаления шума, дискриминатор может быть обучен отличать высококачественные, четкие изображения от размытых или зашумленных. Генератор затем учится преобразовывать низкокачественные изображения в высококачественные, пытаясь обмануть дискриминатора. Таким образом, дискриминатор выступает в роли судьи, который оценивает, насколько успешно генератор улучшил изображение, делая его похожим на "настоящие" высококачественные образцы.

Синтез Текста и Аудио

Не только изображения! Мы применяем GANs для генерации реалистичного текста, музыки и речи. В этих случаях дискриминатор учится отличать естественный, связный текст или мелодичную, гармоничную музыку от сгенерированных, часто бессмысленных или фальшиво звучащих образцов. Его способность улавливать тонкие паттерны в последовательных данных критически важна для создания по-настоящему убедительных синтетических медиа.

Дополнение Данных (Data Augmentation)

Когда у нас мало обучающих данных, мы можем использовать GAN для создания дополнительных, синтетических образцов. Дискриминатор здесь гарантирует, что эти синтетические данные достаточно похожи на реальные, чтобы быть полезными для обучения других моделей. Мы не хотим, чтобы генератор просто копировал существующие данные; мы хотим, чтобы он создавал новые, но реалистичные вариации, и именно дискриминатор следит за этим балансом.

Будущее Дискриминатора: Еще Более Умный Учитель

Мы видим, что дискриминатор уже проделал огромный путь от простого бинарного классификатора до сложного критика и оценщика. Но что ждет его в будущем? Мы уверены, что его роль будет только усложняться и расширяться.

Возможно, мы увидим дискриминаторы, которые смогут не просто говорить "реально/нереально", но и давать более детализированную обратную связь. Например, "это изображение почти реальное, но у глаз неестественный блеск" или "текст хорош, но нарушена грамматика в третьем предложении". Это потребует более сложных архитектур и функций потерь, которые смогут анализировать данные на более высоком семантическом уровне.

Мы также ожидаем, что дискриминаторы станут более "справедливыми" учителями, способными лучше бороться с коллапсом мод и обеспечивать большее разнообразие генерируемых данных. Это может включать новые метрики разнообразия, интегрированные прямо в их функцию потерь, или более сложные механизмы взаимодействия с генератором.

Кроме того, в условиях растущей обеспокоенности по поводу дипфейков и синтетических медиа, дискриминаторы будут играть ключевую роль в создании надежных детекторов подделок. По сути, мы обучаем одни ИИ создавать, а другие – распознавать то, что создано ИИ, формируя цикл постоянного улучшения и противостояния в цифровом мире.

Подытоживая наше сегодняшнее путешествие, мы можем с уверенностью сказать: дискриминатор – это не просто вспомогательный элемент в архитектуре GANs. Это его сердце, его компас, его главный критик и, что самое важное, его учитель. Без его неустанного труда, без его способности отличать правду от вымысла, генераторы никогда бы не достигли того удивительного уровня мастерства, который мы наблюдаем сегодня.

Мы, как блогеры и энтузиасты ИИ, восхищаемся этой элегантной концепцией постоянного соперничества, которое ведет к совершенству. Она не только дарит нам впечатляющие результаты в виде реалистичных изображений и текстов, но и открывает новые горизонты в понимании обучения без явных меток. Мы продолжим следить за развитием дискриминатора и всего мира GANs, ведь в этой динамичной области каждый день приносит новые открытия. Спасибо, что были с нами в этом увлекательном погружении. До новых встреч!

Подробнее: LSI Запросы

| Архитектура дискриминатора | Обучение GAN | Проблемы тренировки GAN | Wasserstein GAN | Mode collapse GAN |

| Функция потерь дискриминатора | Генеративные модели ИИ | Приложения GAN | Сверточные сети в GAN | Обучение дискриминатора |