- Эпоха Иллюзий: Как Нейросети Переписывают Реальность и Где Наша Этика?

- От Простых Мистификаций к Гиперреалистичным Подделкам: Эволюция Фейковых Новостей

- Анатомия Цифровой Лжи: Как Нейросети Творят Иллюзии

- Технологии на службе обмана: Сравнительная таблица возможностей

- Этический Лабиринт: Кто Несет Ответственность и Каковы Последствия?

- Подрыв Доверия и Распад Общественной Ткани

- Манипуляция и Пропаганда в Цифровую Эру

- Кто несет ответственность? Сложности атрибуции

- Пути Защиты: Как Мы Можем Противостоять Цифровому Обману?

- Технологические Инновации в Борьбе с Фейками

- Образование и Критическое Мышление

- Законодательство и Регулирование

- Взгляд в Будущее: Наша Общая Ответственность

Эпоха Иллюзий: Как Нейросети Переписывают Реальность и Где Наша Этика?

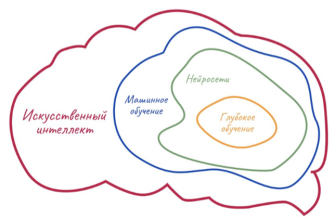

Мы живем в эпоху беспрецедентных технологических прорывов, где искусственный интеллект проникает во все сферы нашей жизни, от персонализированных рекомендаций до автономного транспорта. Но с каждой новой возможностью приходит и новая ответственность, а иногда и новая угроза. Сегодня мы хотим поговорить об одной из самых тревожных граней применения нейросетей – их использовании для создания фейковых новостей. Это не просто вопрос о ложной информации; это глубокое этическое испытание для всего человечества, проверка на прочность наших представлений о правде, доверии и самой сути реальности.

Наше общество всегда сталкивалось с дезинформацией. Сплетни, пропаганда, "утки" в газетах – все это существовало задолго до появления компьютеров. Однако нейросети поднимают эту проблему на совершенно новый, качественно иной уровень. Они не просто распространяют ложь; они ее генерируют с такой убедительностью, с такой скоростью и в таких масштабах, что отличить вымысел от факта становится все труднее. Как же нам ориентироваться в этом мире, где границы между реальным и синтетическим стираются? Как сохранить критическое мышление и не поддаться на уловки, созданные алгоритмами, которые становятся умнее с каждым днем?

От Простых Мистификаций к Гиперреалистичным Подделкам: Эволюция Фейковых Новостей

Чтобы понять всю глубину проблемы, нам необходимо оглянуться назад. Исторически фейковые новости опирались на человеческие слабости: предвзятость, эмоциональность, склонность верить авторитетам или тому, что подтверждает наши убеждения. Распространение было медленным, часто требовало усилий многих людей, а технологии, такие как печать или радио, хоть и ускоряли процесс, все же оставляли место для проверки и разоблачения.

Но с появлением интернета и социальных сетей ситуация кардинально изменилась. Информация стала распространяться мгновенно, а алгоритмы платформ, стремящиеся удержать наше внимание, часто непреднамеренно способствовали виральному распространению сенсационных, но ложных историй. Это был первый звоночек. Однако настоящая революция в создании фейков произошла с развитием генеративных нейронных сетей.

Мы говорим о технологиях, которые способны не просто изменять существующие изображения или тексты, но создавать совершенно новые, оригинальные материалы, которые выглядят абсолютно правдоподобно. Это уже не просто фотошоп, где можно увидеть следы вмешательства. Это синтетическая реальность, созданная с нуля, которая становится практически неотличимой от настоящей. И это ставит перед нами ряд вопросов, на которые пока нет однозначных ответов.

Анатомия Цифровой Лжи: Как Нейросети Творят Иллюзии

Давайте подробно рассмотрим, какие именно инструменты нейросетей используются для создания фейковых новостей и почему они так эффективны. Мы не просто теоретизируем, а видим, как эти технологии уже применяются на практике, и это вызывает серьезные опасения.

Генерация текста: От простых заметок до убедительных статей.

Современные языковые модели, такие как GPT-3 или его более новые версии, достигли поразительного уровня в создании связного, грамматически верного и стилистически адаптированного текста. Они могут имитировать стиль письма конкретного человека или издания, генерировать новостные статьи, комментарии в социальных сетях, эссе или даже целые книги. Для создания фейковых новостей это идеальный инструмент: можно автоматически генерировать тысячи уникальных, но ложных историй, создавать комментарии, имитирующие дискуссии, или писать "экспертные мнения", вводящие в заблуждение.

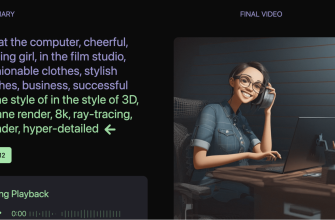

Дипфейки (Deepfakes): Видео и аудио, которые никогда не происходили.

Возможно, самая известная и пугающая форма использования нейросетей для фейков. Дипфейки позволяют накладывать лицо одного человека на тело другого в видео, изменять их мимику, или синтезировать речь таким образом, что создается впечатление, будто человек сказал то, чего на самом деле никогда не говорил. Мы видели, как дипфейки использовались для создания порнографических материалов без согласия, для подделки выступлений политиков, для имитации голосов руководителей компаний с целью мошенничества. Это не просто "видеомонтаж"; это создание абсолютно нового, реалистичного события, которого никогда не было.

Генерация изображений: Идеальные "доказательства" несуществующего.

Нейросети, такие как DALL-E, Midjourney или Stable Diffusion, способны создавать фотореалистичные изображения по текстовому описанию. Это означает, что можно сгенерировать "фотографию" любого события, человека или объекта, даже если они никогда не существовали или событие никогда не происходило. Например, мы можем создать изображение катастрофы, которой не было, или "снимки" известной личности в компрометирующей ситуации. Такие изображения, будучи вброшенными в социальные сети, быстро подхватываются и распространяются, становясь "доказательством" фейковой новости.

Автоматизированное распространение: Армии ботов.

После того как фейковый контент создан, нейросети могут быть использованы для его массового распространения. Боты, управляемые ИИ, могут имитировать поведение реальных пользователей в социальных сетях, оставлять комментарии, репостить, лайкать, создавая иллюзию широкой поддержки или общественного мнения. Они могут работать круглосуточно, охватывая огромные аудитории и усиливая эффект от фейковых новостей, делая их более заметными и убедительными.

Технологии на службе обмана: Сравнительная таблица возможностей

Чтобы нагляднее представить масштабы возможностей, мы подготовили таблицу, демонстрирующую, как различные типы нейросетей способствуют созданию и распространению фейковых новостей.

| Тип Нейросети | Основные Возможности | Примеры Использования в Фейковых Новостях | Сложность Обнаружения |

|---|---|---|---|

| Генеративные языковые модели (LLM) | Создание связного, контекстуально уместного текста; имитация стиля. | Создание фальшивых новостных статей, комментариев, отзывов; написание "экспертных" заключений; массовая генерация контента для ботов. | Высокая (требует продвинутых детекторов ИИ или ручной проверки фактов). |

| Генеративно-состязательные сети (GAN) для изображений | Создание фотореалистичных изображений несуществующих объектов, людей, событий. | Фальшивые "доказательства" событий, которых не было; компрометирующие изображения известных личностей; визуализация вымышленных угроз. | Высокая (визуально неотличимы от реальных фото, требуется анализ метаданных или специфические детекторы). |

| Дипфейк-алгоритмы (видео/аудио) | Изменение лиц и голосов в видео, синтез речи, создание полностью синтетических видео. | Поддельные выступления политиков, знаменитостей; имитация телефонных звонков от руководителей для мошенничества; создание порнографии без согласия. | Очень высокая (требует специализированного программного обеспечения и экспертного анализа). |

| Рекомендательные системы и алгоритмы соцсетей | Персонализация контента, усиление охвата на основе вовлеченности. | Непреднамеренное, но эффективное распространение фейков за счет приоритета "хайпового" контента; создание "эхо-камер". | Средняя (влияние алгоритмов сложно отследить, но их механизм известен). |

| ИИ-боты для социальных сетей | Автоматизированное взаимодействие, имитация человеческого поведения, массовое распространение. | Усиление ложных нарративов; создание иллюзии массовой поддержки или оппозиции; манипуляция трендами. | Средняя (современные боты могут быть сложными, но часто имеют паттерны поведения, выдающие их). |

Как мы видим, арсенал инструментов для создания и распространения фейковых новостей с использованием нейросетей постоянно расширяется и совершенствуется. Это не просто шутки и розыгрыши, это серьезный вызов нашей информационной безопасности и способности различать правду.

Этический Лабиринт: Кто Несет Ответственность и Каковы Последствия?

Теперь, когда мы понимаем техническую сторону вопроса, настало время погрузиться в самый сложный аспект – этику. Использование нейросетей для создания фейковых новостей поднимает фундаментальные вопросы о морали, ответственности и ценностях, которые мы, как общество, обязаны защищать. Это не просто техническая проблема, это экзистенциальный вызов.

Мы сталкиваемся с многомерным этическим лабиринтом, где нет простых ответов. Кто несет ответственность, когда ИИ генерирует убедительную ложь? Разработчик алгоритма? Пользователь, который его применил? Платформа, которая не смогла ее остановить? Или, возможно, каждый из нас, кто потребляет и распространяет информацию без должной проверки?

Подрыв Доверия и Распад Общественной Ткани

Самое разрушительное последствие распространения фейковых новостей, сгенерированных ИИ, – это эрозия доверия. Мы всегда полагались на определенные источники информации: новостные агентства, экспертов, даже личные свидетельства. Но когда ИИ может имитировать любой из этих источников, создавая неотличимую подделку, на что нам остается полагаться?

- Кризис журналистики: Если даже самые авторитетные СМИ могут быть подделаны, а их репортажи – дискредитированы фальшивками, то роль профессиональной журналистики ставится под угрозу.

- Политическая поляризация: Фейковые новости усиливают уже существующие разногласия, создавая ложные нарративы, которые поддерживают одну сторону и очерняют другую, углубляя раскол в обществе.

- Недоверие к институтам: Когда мы не можем верить правительствам, научным учреждениям или даже друг другу, основа для функционирования демократического общества начинает рассыпатся.

- Личное воздействие: Жертвы дипфейков, особенно в случаях порнографии без согласия или ложных обвинений, сталкиваются с разрушением репутации, психологическими травмами и глубоким чувством предательства.

Мы видим, как это воздействует на способность людей принимать обоснованные решения – будь то выбор на выборах, принятие медицинских решений или инвестирование средств. Без достоверной информации мы становимся уязвимыми для манипуляций.

Манипуляция и Пропаганда в Цифровую Эру

Нейросети, способные генерировать контент и управлять его распространением, становятся мощным оружием в руках тех, кто стремится к манипуляции. Это выходит за рамки простой политической рекламы; это создание полностью контролируемой информационной среды, где реальность формируется по заказу.

- Влияние на выборы: Мы уже наблюдали попытки вмешательства в выборы с использованием менее совершенных методов. Представьте, что можно будет генерировать тысячи фальшивых новостей, изображений и видео, нацеленных на конкретные группы избирателей, подрывая доверие к кандидатам или целым процессам.

- Экономическое мошенничество: Дипфейки голосов могут быть использованы для имитации звонков от руководителей компаний, чтобы обмануть сотрудников или инвесторов, совершить финансовые махинации.

- Геополитическая дестабилизация: Фальшивые новости о военных конфликтах, стихийных бедствиях или социальных волнениях могут быть использованы для разжигания напряженности между странами, провоцирования паники или дестабилизации регионов.

- Формирование общественного мнения: Целенаправленное создание и распространение фейковых нарративов может изменить восприятие людьми важных социальных вопросов, от изменения климата до миграции, влияя на государственную политику и социальные движения.

"Технология сама по себе не является ни добром, ни злом; она лишь инструмент. Но в руках человека, который ее использует, она может стать как самым мощным средством для прогресса, так и самым разрушительным оружием. Искусственный интеллект, как и атомная энергия, требует от нас не только технического мастерства, но и глубокой этической мудрости."

— Юваль Ной Харари, историк и философ

Эта цитата Харари прекрасно отражает суть нашей дилеммы. Нейросети – это мощнейший инструмент, и их потенциал для блага огромен. Но их способность к обману заставляет нас задуматься о той "этической мудрости", о которой он говорит, и о том, как мы должны ее развивать, чтобы не стать жертвами собственных творений.

Кто несет ответственность? Сложности атрибуции

Вопрос об ответственности в эпоху ИИ-сгенерированных фейков становится особенно острым. Мы не можем просто указать пальцем на одного человека или организацию. Это сложная цепочка:

- Разработчики ИИ: Должны ли они нести ответственность за потенциально вредоносное использование своих технологий? Какую "красную черту" они должны устанавливать при разработке, чтобы минимизировать риски злоупотреблений?

- Платформы распространения (социальные сети, мессенджеры): Какова их роль в модерации контента? Должны ли они активно бороться с фейками, сгенерированными ИИ, даже если это замедляет распространение информации или вызывает споры о цензуре?

- Пользователи: Какова наша личная ответственность за проверку информации, прежде чем мы ее распространим? Должны ли мы развивать "цифровую гигиену" и критическое мышление?

- Законодатели: Как создавать законы, которые регулируют использование ИИ, не подавляя инновации, но при этом защищая общество от вреда?

Это не просто вопрос "кто виноват", а вопрос о том, как нам коллективно выработать нормы и механизмы, чтобы предотвратить катастрофические последствия. Мы видим, что отсутствие четких правил и быстрое развитие технологий создают правовой вакуум, который активно эксплуатируется злоумышленниками.

Пути Защиты: Как Мы Можем Противостоять Цифровому Обману?

Столкнувшись с такой мощной угрозой, легко поддаться пессимизму. Однако мы убеждены, что есть пути для противодействия и защиты. Это не будет легкая битва, но она необходима для сохранения целостности нашего информационного пространства и, в конечном итоге, нашего общества. Решение должно быть многогранным, охватывающим технологии, образование, законодательство и личную ответственность.

Технологические Инновации в Борьбе с Фейками

Парадоксально, но те же нейросети, которые используются для создания фейков, могут быть применены и для их обнаружения. Это своего рода гонка вооружений, где обе стороны постоянно совершенствуют свои методы.

- AI-детекторы: Разрабатываются алгоритмы, способные анализировать изображения, видео и тексты на предмет признаков генерации ИИ. Они ищут невидимые глазу артефакты, статистические аномалии или специфические паттерны, характерные для синтетического контента.

- Водяные знаки и цифровая подпись: Внедрение невидимых цифровых водяных знаков или криптографических подписей в оригинальный медиаконтент, которые подтверждают его подлинность. Если контент изменен или сгенерирован ИИ, подпись будет нарушена или отсутствовать.

- Блокчейн для верификации: Использование технологии блокчейн для создания неизменяемого реестра оригинального контента. Это позволило бы отслеживать происхождение информации и удостоверяться в ее подлинности.

- Разработка "этичных" ИИ: Создание нейросетей с встроенными ограничениями, которые не позволят им генерировать вредоносный или вводящий в заблуждение контент. Это требует глубокой проработки этических принципов на этапе проектирования.

Однако мы должны понимать, что технологические решения никогда не будут идеальными. Это постоянная игра в кошки-мышки, где каждая новая защита стимулирует создание новых методов обхода.

Образование и Критическое Мышление

Самая мощная защита против дезинформации лежит в нас самих. Развитие медиаграмотности и критического мышления становится не просто желательным навыком, а жизненно важной необходимостью в цифровую эпоху.

- Обучение медиаграмотности: С раннего возраста мы должны учить людей, как распознавать фейковые новости, проверять источники, понимать предвзятость и анализировать информацию. Это должно стать частью образовательных программ.

- Развитие критического мышления: Учить людей не принимать информацию на веру, задавать вопросы, искать подтверждения из разных источников, сомневаться в сенсационных заголовках.

- Понимание механизмов ИИ: Объяснять широкой публике, как работают нейросети, как они могут генерировать контент и какие риски это несет. Это поможет снизить уязвимость перед манипуляциями.

Мы должны стать более "цифровыми сыщиками", способными самостоятельно оценивать достоверность информации, прежде чем мы ее примем или распространим. Это требует усилий от каждого из нас.

Законодательство и Регулирование

Правительства и международные организации также играют ключевую роль в формировании ответственной среды для использования ИИ. Необходимы четкие правила игры, которые защитят общество без подавления инноваций.

- Законы против дипфейков: Принятие законов, криминализирующих создание и распространение дипфейков, особенно тех, которые используются для мошенничества, клеветы или создания порнографии без согласия.

- Ответственность платформ: Возложение на социальные сети и другие платформы обязанности по активной модерации контента, маркировке сгенерированного ИИ контента и удалению вредоносных фейков.

- Этические кодексы для разработчиков ИИ: Разработка международных стандартов и этических кодексов для компаний, создающих ИИ, обязывающих их учитывать социальные последствия своих технологий.

Это сложный путь, требующий баланса между свободой слова, инновациями и защитой общества. Но без законодательного регулирования мы рискуем погрузиться в хаос дезинформации.

Взгляд в Будущее: Наша Общая Ответственность

Мы стоим на пороге новой эры, где технологии ИИ будут играть все более центральную роль. Вопрос не в том, исчезнут ли фейковые новости, сгенерированные нейросетями – они, к сожалению, останутся с нами. Вопрос в том, насколько эффективно мы сможем им противостоять и насколько устойчивым окажется наше общество перед лицом этого вызова.

Мы, как блогеры, журналисты, разработчики, политики и просто граждане, несем коллективную ответственность. Разработчики должны встраивать этику в свои алгоритмы. Платформы должны модерировать контент и обеспечивать прозрачность. Правительства должны создавать справедливые и эффективные законы. И каждый из нас должен развивать свои навыки критического мышления и цифровую грамотность.

Это не борьба, которую можно выиграть один раз и навсегда. Это постоянный процесс адаптации, обучения и развития. Мы должны быть бдительными, любознательными и готовыми к тому, что реальность может быть более сложной, чем кажется на первый взгляд. Только так мы сможем сохранить доверие, правду и саму основу нашего информационного общества в эпоху, когда нейросети могут переписывать реальность.

На этом статья заканчивается.

Подробнее

| Этика ИИ | Борьба с фейками | Нейросети и дезинформация | Дипфейки и общество | Медиаграмотность |

| Регулирование ИИ | Последствия ИИ-фейков | Цифровая гигиена | Будущее информации | Искусственный интеллект |