- Когда амбиции упираются в терафлопсы: Наши испытания с вычислительной мощностью в мире ИИ

- Почему вычислительная мощность — это не просто "приятно иметь", а абсолютная необходимость

- Масштабы данных и сложность моделей: Две стороны одной медали

- Эскалация спроса: Куда нас ведет эта гонка вооружений?

- Аппаратные ограничения: Битва за каждый гигафлопс

- Энергопотребление и экологический след: Цена прогресса

- Финансовое бремя: Сколько стоит мечта?

- Доступность и демократизация: Кто получит доступ к будущему?

- Стратегии преодоления: Как мы боремся с цифровым голодом

- Оптимизация алгоритмов и данных: Умный подход

- Распределенные вычисления и облачные решения: Сила в единстве

- Инновации в аппаратном обеспечении и будущее: Надежда на завтра

- Роль открытого сообщества и совместных проектов

- Наше видение будущего: ИИ для всех

Когда амбиции упираются в терафлопсы: Наши испытания с вычислительной мощностью в мире ИИ

Привет, друзья! За время нашего погружения в удивительный мир искусственного интеллекта и машинного обучения, мы неоднократно сталкивались с монументальными вызовами. Один из самых насущных, и, пожалуй, наиболее болезненных, – это вечный голод по вычислительной мощности. Это не просто техническая проблема; это фундамент, на котором строятся наши самые смелые идеи, самые прорывные исследования и самые амбициозные проекты. Мы хотим поделиться с вами нашим опытом, нашими наблюдениями и теми уроками, которые мы извлекли, пытаясь обуздать эту цифровую бездну.

Представьте себе художника, у которого есть видение шедевра, но нет достаточно больших холстов или качественных красок. Или инженера, который спроектировал невероятно сложный механизм, но не может найти материалы, способные выдержать необходимые нагрузки. Примерно так мы часто ощущаем себя в мире ИИ. Наши модели становятся все сложнее, наши наборы данных – все объемнее, а стремление к точности и производительности – все ненасытнее. И каждый раз, когда мы достигаем очередного потолка, мы понимаем, что это не потолок наших идей, а потолок наших машин.

Эта статья – наше искреннее размышление о том, как мы справлялись, справляемся и будем справляться с этой фундаментальной проблемой. Мы рассмотрим, почему вычислительная мощность стала таким критическим фактором, какие препятствия она воздвигает на пути инноваций, и какие стратегии мы используем (или мечтаем использовать) для их преодоления. Приготовьтесь к глубокому погружению в мир битов, байтов и непреодолимого стремления к новым знаниям.

Почему вычислительная мощность — это не просто "приятно иметь", а абсолютная необходимость

В начале пути, когда мы только начинали экспериментировать с первыми нейронными сетями, казалось, что обычного процессора вполне достаточно. Мы могли обучать небольшие модели на скромных датасетах, получая вполне удовлетворительные результаты для наших учебных проектов. Однако, по мере того как мы углублялись в сферу машинного обучения, особенно в область глубокого обучения, мы быстро осознали, что требования к "железу" растут экспоненциально. Это стало очевидным, когда мы начали работать с реальными задачами – распознаванием изображений, обработкой естественного языка, генеративными моделями.

Причина проста: современные модели глубокого обучения, такие как сверточные нейронные сети (CNN) для зрения или трансформеры для языка, состоят из миллионов, а иногда и миллиардов параметров. Каждый из этих параметров должен быть скорректирован в процессе обучения на огромных объемах данных. Это означает выполнение колоссального количества матричных умножений и других математических операций. Представьте себе миллиарды вычислений, повторяющихся сотни или тысячи раз в течение каждой эпохи обучения, а таких эпох может быть сотни. Без специализированного оборудования это становится просто невозможным.

Мы часто видим, как новые архитектуры моделей публикуются в статьях, обещая невероятные прорывы. Но когда мы пытаемся воспроизвести эти результаты или адаптировать эти модели под свои задачи, мы сталкиваемся с реальностью: для этого требуется вычислительный кластер, который значительно превосходит возможности наших локальных машин. Это создает некий барьер для входа, отделяющий крупные исследовательские лаборатории и корпорации от независимых исследователей и малых команд. Мы ощущаем это на собственном опыте, когда приходится выбирать между амбициозным, но вычислительно дорогим проектом и более скромным, но реализуемым на доступных ресурсах.

Масштабы данных и сложность моделей: Две стороны одной медали

Мы часто говорим о двух основных факторах, которые определяют наши потребности в вычислительной мощности: это объем и разнообразие данных, а также сложность самих моделей. Они тесно взаимосвязаны и постоянно подталкивают друг друга к новым рекордам.

Рассмотрим данные. В эпоху "больших данных" мы имеем доступ к петабайтам информации. Качественное обучение модели требует не только большого количества данных, но и их постоянного пополнения, предварительной обработки и аугментации. Каждая операция с данными – загрузка, преобразование, подача в модель – требует времени и ресурсов. Если мы говорим о задачах компьютерного зрения, то это могут быть миллионы изображений высокого разрешения. Для обработки естественного языка – миллиарды слов и предложений. Мы видели, как проекты, начинавшиеся с нескольких гигабайт, быстро разрастались до терабайтов, и каждый такой рост приводил к переоценке наших вычислительных возможностей.

В свою очередь, сложность моделей растет, потому что мы стремимся к более глубокому пониманию данных, к более точным предсказаниям и более изощренным генеративным способностям. Модели, которые были "передовыми" всего несколько лет назад, теперь считаются базовыми. Трансформеры, например, показали феноменальные результаты в НЛП, но их размер и вычислительные требования ошеломляют. Обучение GPT-3, по оценкам, стоило миллионы долларов и требовало сотен тысяч GPU-часов. Это уровень, к которому мы, как команда, пока можем только стремиться, и это заставляет нас искать креативные пути для достижения похожих результатов с меньшими ресурсами.

Вот примерная иллюстрация того, как эти факторы влияют на время обучения:

| Фактор | Пример | Влияние на вычисления | Типичное увеличение времени обучения |

|---|---|---|---|

| Размер датасета | От 100 ГБ до 1 ТБ | Прямо пропорциональное увеличение операций чтения/записи и обработки | 2-5x |

| Количество параметров модели | От 10 млн до 100 млн | Экспоненциальное увеличение матричных умножений | 5-20x |

| Глубина сети (слои) | От 10 до 50 слоев | Увеличение последовательных вычислений и объема памяти | 3-10x |

| Размер батча | От 32 до 256 | Влияет на параллелизацию и стабильность градиентов | 0.5-2x (оптимизация) |

Эскалация спроса: Куда нас ведет эта гонка вооружений?

Мы наблюдаем беспрецедентный рост спроса на вычислительные ресурсы в ИИ. Если в 2012 году для обучения AlexNet требовалось несколько дней на нескольких GPU, то сегодня для SOTA (State-of-the-Art) моделей требуются недели или месяцы на сотнях, а то и тысячах самых мощных ускорителей. Это не просто линейный рост, это скорее гиперболический взлет, который заставляет нас постоянно пересматривать наши стратегии и бюджеты.

Этот спрос подпитывается несколькими факторами. Во-первых, это стремление к большей точности и обобщающей способности; Чем больше данных и сложнее модель, тем выше потенциал для достижения результатов, которые ранее казались невозможными. Во-вторых, это появление новых парадигм и задач. Генеративные состязательные сети (GANs), диффузионные модели, большие языковые модели (LLM) – каждая новая прорывная архитектура требует колоссальных объемов вычислений; В-третьих, это коммерциализация ИИ. Компании стремятся внедрять ИИ во все аспекты своей деятельности, от персонализированных рекомендаций до автономного вождения, и для этого им нужны не просто работающие модели, а максимально эффективные и надежные, что снова упирается в вычислительную мощность.

Мы часто задумываемся, куда это все приведет. Неужели только гиганты с неограниченными бюджетами смогут позволить себе исследования и разработки на передовом уровне? Это вызывает у нас некоторую тревогу, поскольку мы верим в демократизацию науки и технологий. Если доступ к необходимым ресурсам станет слишком дорогим, это может замедлить инновации в целом, монополизируя их в руках немногих. Поэтому мы активно ищем пути, как оставаться на острие прогресса, не имея в распоряжении дата-центров размером с футбольное поле.

Аппаратные ограничения: Битва за каждый гигафлопс

Наш опыт показывает, что основной бутылочной горлышкой в большинстве случаев являются не алгоритмы, а аппаратное обеспечение. Мы живем в эпоху, когда закон Мура замедляется, и мы не можем просто ждать следующего поколения CPU, чтобы решить все наши проблемы. Вместо этого мы видим специализацию: процессоры общего назначения (CPU) все еще важны, но для ИИ-вычислений мы в значительной степени полагаемся на графические процессоры (GPU), а также на специализированные ускорители, такие как TPU (Tensor Processing Units) от Google и другие ASIC (Application-Specific Integrated Circuits).

Когда мы выбираем оборудование, мы учитываем несколько ключевых параметров:

- Производительность в операциях с плавающей точкой (FLOPS): Это прямой показатель того, сколько вычислений может выполнить ускоритель в секунду. Для глубокого обучения важны как FP32, так и FP16/BF16 (половинная точность), поскольку многие модели могут быть эффективно обучены с меньшей точностью, что значительно ускоряет процесс.

- Объем и пропускная способность памяти: Современные модели требуют огромного объема видеопамяти (VRAM). Если модель не помещается в память одного GPU, нам приходится использовать техники распределенного обучения или уменьшать размер модели, что не всегда желательно. Пропускная способность памяти определяет, как быстро данные могут быть переданы к вычислительным ядрам, что является критически важным для задач, где обработка данных преобладает над самими вычислениями.

- Скорость межсоединений (Interconnects): Если мы используем несколько GPU, скорость их взаимодействия становится решающей. Технологии вроде NVLink от NVIDIA позволяют GPU обмениваться данными намного быстрее, чем через стандартные PCIe шины, что существенно ускоряет распределенное обучение.

Мы видели, как даже самые мощные GPU могут быть ограничены, если у них недостаточно памяти или медленное соединение. Это как иметь мощный двигатель, но узкую топливную магистраль. Мы постоянно ищем баланс между этими параметрами, пытаясь выжать максимум из каждого вложенного доллара.

Энергопотребление и экологический след: Цена прогресса

По мере того как наши модели становятся все больше, а вычислительные кластеры – все мощнее, мы не можем игнорировать растущую проблему энергопотребления. Обучение крупной модели ИИ может потреблять столько же электроэнергии, сколько потребляет средний дом за несколько месяцев или даже лет. Это не только огромные финансовые затраты, но и серьезный экологический след. Мы, как ответственные исследователи и разработчики, не можем оставаться в стороне от этой проблемы.

Интенсивное использование GPU приводит к значительному выделению тепла, что требует мощных систем охлаждения, которые, в свою очередь, также потребляют энергию. Мы часто шутим, что наш серверный шкаф напоминает мини-печку, но за этой шуткой стоит реальная проблема перегрева и стабильности оборудования. Увеличение энергоэффективности становится такой же важной задачей, как и увеличение чистой вычислительной мощности. Мы ищем способы оптимизации не только алгоритмов, но и самого процесса обучения, чтобы минимизировать потребление ресурсов.

Для нас это не просто техническая головоломка, это вопрос этики и устойчивого развития. Мы верим, что ИИ должен служить улучшению мира, а не усугублять его экологические проблемы. Поэтому в наших проектах мы всегда стараемся учитывать этот аспект, выбирая более энергоэффективные подходы, когда это возможно, и осознавая полную стоимость каждого терафлопса.

Финансовое бремя: Сколько стоит мечта?

Проблема вычислительной мощности неотделима от финансовой стороны вопроса. Мы, как и многие другие команды, сталкиваемся с дилеммой: инвестировать в собственное оборудование или полагаться на облачные сервисы. Каждый подход имеет свои плюсы и минусы, и выбор часто определяется масштабом проекта, доступным бюджетом и долгосрочными стратегическими целями.

Покупка собственных GPU – это значительные капитальные затраты. Высокопроизводительные ускорители, такие как NVIDIA A100 или H100, стоят десятки тысяч долларов каждый. А для серьезных задач нужны не один и не два таких ускорителя, а целый кластер. К этим расходам добавляется стоимость серверов, систем охлаждения, электроэнергии, сетевого оборудования и обслуживания. Мы видели, как эти суммы быстро достигают сотен тысяч, а то и миллионов долларов. Это становится неподъемным для небольших стартапов или академических групп с ограниченным финансированием.

С другой стороны, облачные сервисы, такие как AWS, Google Cloud Platform или Azure, предлагают гибкость и масштабируемость. Мы можем арендовать необходимое количество GPU на короткий срок, платя только за фактически использованные ресурсы. Это удобно для экспериментов, пиковых нагрузок или проектов с неопределенным сроком. Однако, при долгосрочном и интенсивном использовании, облачные затраты могут быстро превысить стоимость владения собственным оборудованием. Мы неоднократно проводили расчеты, сравнивая TCO (Total Cost of Ownership) для разных сценариев, и каждый раз приходили к выводу, что однозначного ответа нет – все зависит от конкретных потребностей.

Вот краткое сравнение:

- Собственное оборудование (On-premise):

- Плюсы: Полный контроль, отсутствие зависимости от провайдера, потенциально ниже стоимость в долгосрочной перспективе при высокой загрузке, лучшая конфиденциальность данных.

- Минусы: Высокие начальные инвестиции, необходимость обслуживания и обновления, ограниченная масштабируемость, риски устаревания.

Мы постоянно ищем оптимальный баланс, иногда сочетая оба подхода: используем облако для прототипирования и пиковых нагрузок, а собственное (более скромное) оборудование – для повседневной разработки и экспериментов.

Доступность и демократизация: Кто получит доступ к будущему?

Проблема доступности вычислительной мощности напрямую влияет на демократизацию исследований и разработок в области ИИ. Если только крупные корпорации могут позволить себе обучение передовых моделей, это создает серьезный барьер для инноваций. Молодые стартапы, независимые исследователи, студенты и команды из развивающихся стран оказываются в неравном положении. Мы считаем, что это серьезная угроза для разнообразия идей и темпов прогресса.

Мы часто видим, как талантливые люди с блестящими идеями вынуждены ограничивать свои амбиции из-за отсутствия доступа к необходимым ресурсам. Это не только личная трагедия для этих исследователей, но и потеря для всего сообщества. Сколько потенциальных прорывов не состоялось, потому что у кого-то не было средств на аренду GPU? Мы активно ищем и поддерживаем инициативы, направленные на предоставление доступа к вычислительным ресурсам тем, кто в этом нуждается, будь то гранты, программы поддержки или открытые платформы.

Мы убеждены, что будущее ИИ должно быть инклюзивным. Доступ к вычислительной мощности – это не просто технический вопрос, это социальный вопрос. От того, кто имеет возможность формировать и развивать ИИ, зависит, каким будет это будущее – централизованным и контролируемым немногими, или распределенным и развивающимся благодаря усилиям всего человечества.

"Настоящий прогресс происходит, когда инструменты, которые раньше были доступны лишь немногим, становятся доступными для всех. Это особенно верно для вычислительной мощности в эпоху искусственного интеллекта."

– Эндрю Ын (Andrew Ng), известный исследователь и предприниматель в области ИИ.

Стратегии преодоления: Как мы боремся с цифровым голодом

Несмотря на все сложности, мы не опускаем руки. Наш опыт научил нас быть изобретательными и искать обходные пути. Мы разработали целый арсенал стратегий, которые помогают нам максимально эффективно использовать доступные ресурсы и даже бросать вызов гигантам, обладающим несравненно большими возможностями. Это не просто попытки сэкономить, это философия работы, которая ценит эффективность, креативность и оптимизацию.

Эти стратегии включают в себя как технические подходы, так и организационные решения. Мы постоянно учимся, адаптируемся и делимся своими находками с сообществом, потому что верим, что вместе мы сильнее.

Оптимизация алгоритмов и данных: Умный подход

Первое, что мы всегда делаем, когда сталкиваемся с ограничениями вычислительной мощности, это смотрим на саму проблему и используемые методы. Часто можно добиться значительного улучшения, не увеличивая "железо", а улучшая "софт".

Вот некоторые из наших любимых подходов:

- Выбор эффективных архитектур моделей: Мы не всегда гонимся за самой сложной и большой моделью. Иногда более простая, но хорошо спроектированная архитектура может дать сопоставимые результаты с гораздо меньшими затратами. Например, для некоторых задач Vision Transformer могут быть слишком дороги, и мы используем более легкие CNN-модели.

- Квантование и дистилляция моделей: Мы можем обучать большие модели, а затем "сжимать" их. Квантование уменьшает точность весов и активаций (например, с FP32 до INT8), что значительно сокращает объем памяти и ускоряет вычисления. Дистилляция (knowledge distillation) позволяет "студенческой" (меньшей) модели учиться у "учительской" (большой) модели, перенимая её знания и при этом оставаясь компактной и быстрой.

- Эффективная обработка данных: Мы инвестируем время в оптимизацию пайплайнов данных. Это включает в себя предварительную обработку, аугментацию "на лету" (on-the-fly augmentation) с использованием CPU, кэширование данных и использование эффективных форматов хранения. Иногда даже смена формата данных с PNG на TFRecord или WebP может существенно сократить время загрузки и обработки.

- Оптимизация гиперпараметров: Часто можно найти "сладкое место" в пространстве гиперпараметров, которое позволяет модели обучаться быстрее и эффективнее, не требуя больше ресурсов. Это включает в себя настройку скорости обучения, размера батча, использования планировщиков скорости обучения и методов регуляризации.

- Ранняя остановка (Early Stopping): Нет смысла обучать модель дольше, чем это необходимо. Мы тщательно отслеживаем метрики валидации и останавливаем обучение, как только производительность перестает улучшаться, экономя часы, а то и дни вычислений.

Эти методы не всегда дают такой же прирост производительности, как покупка нового GPU, но они позволяют нам выжимать максимум из того, что у нас есть, и иногда даже превосходить ожидания.

Распределенные вычисления и облачные решения: Сила в единстве

Когда оптимизация "софта" уже не справляется, мы обращаемся к распределенным вычислениям и облачным платформам. Эти подходы позволяют нам масштабировать наши операции горизонтально, используя множество машин одновременно.

Наш опыт работы с распределенными системами показал, что это палка о двух концах. С одной стороны, это позволяет нам обучать модели, которые иначе были бы недоступны. С другой стороны, это добавляет сложности в управление, синхронизацию и отладку. Мы используем фреймворки, такие как PyTorch DistributedDataParallel или TensorFlow Distributed Strategy, которые значительно упрощают этот процесс.

Что касается облачных решений, то мы тщательно выбираем провайдера, исходя из наших потребностей. Мы смотрим на:

- Доступность конкретных GPU: Не все провайдеры предлагают одни и те же модели GPU или в одинаковом количестве.

- Стоимость: Сравниваем цены за час работы GPU, а также стоимость хранения данных и сетевого трафика.

- Удобство использования и инструментарий: Наличие готовых образов с предустановленным ПО, интеграция с инструментами MLOps, удобство мониторинга.

- Географическое расположение дата-центров: Для снижения задержек и соблюдения регуляторных требований.

Некоторые из наших проектов требовали использования Spot-инстансов в облаке – это значительно дешевле, но сопряжено с риском прерывания. Мы разрабатываем стратегии для сохранения состояния обучения (checkpointing), чтобы можно было возобновить работу после прерывания, минимизируя потери.

Инновации в аппаратном обеспечении и будущее: Надежда на завтра

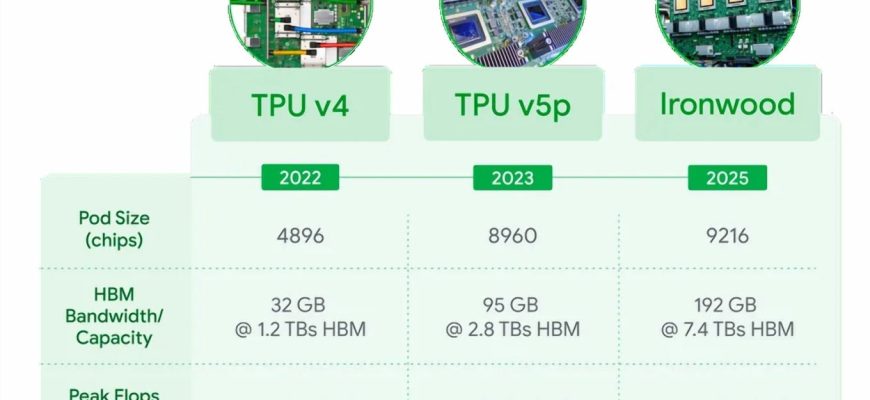

Мы с большим интересом следим за инновациями в области аппаратного обеспечения. Несмотря на замедление закона Мура, производители не сидят сложа руки. Мы видим появление:

- Специализированных ускорителей: Помимо GPU и TPU, появляются новые чипы, разработанные специально для ИИ, такие как Habana Gaudi, Cerebras Wafer-Scale Engine и другие. Они обещают еще большую эффективность и производительность для конкретных типов ИИ-вычислений.

- Память нового поколения: Развитие HBM (High Bandwidth Memory) позволяет значительно увеличить пропускную способность памяти, что критически важно для "голодных" по данным моделей.

- Квантовые компьютеры: Хотя это еще находится на ранней стадии исследований, квантовые вычисления потенциально могут революционизировать некоторые задачи ИИ, которые сейчас не под силу даже самым мощным классическим компьютерам. Мы пока не используем их в повседневной работе, но внимательно следим за прогрессом.

Мы верим, что будущее принесет нам более доступные и энергоэффективные решения. Возможно, появятся новые архитектуры, которые будут требовать меньше вычислительной мощности для обучения, или аппаратные решения, которые будут стоить значительно дешевле, чем текущие флагманские GPU. Наше сообщество активно работает над этим, и мы являемся частью этого движения.

Роль открытого сообщества и совместных проектов

Один из самых вдохновляющих аспектов нашей работы – это сила открытого сообщества. Мы активно участвуем в проектах с открытым исходным кодом, делимся своими наработками и учимся у других. Это не только позволяет нам использовать чужие решения, но и дает возможность внести свой вклад.

Примеры того, как сообщество помогает справляться с вычислительными ограничениями:

- Предварительно обученные модели (Pre-trained Models): Мы часто используем модели, обученные другими командами на огромных датасетах, а затем дообучаем их (fine-tuning) под наши специфические задачи. Это значительно сокращает время и ресурсы, которые потребовались бы для обучения с нуля. Платформы вроде Hugging Face Model Hub являются бесценным ресурсом.

- Совместные исследовательские проекты: Объединение ресурсов с другими командами или университетами позволяет нам работать над более масштабными проектами, которые были бы не под силу одной команде.

- Образовательные ресурсы и туториалы: Бесчисленное множество онлайн-курсов, статей и вебинаров помогают нам осваивать новые методы оптимизации и эффективного использования ресурсов.

- Форумы и сообщества: Обмен опытом и поиск решений в сообществе – бесценный ресурс. Часто можно найти готовый ответ на свою проблему или получить ценный совет от более опытных коллег.

Мы убеждены, что чем больше знаний и ресурсов будет открыто и доступно, тем быстрее будет развиваться область ИИ и тем больше людей смогут внести свой вклад в этот прогресс. Это наша коллективная ответственность.

Наше видение будущего: ИИ для всех

Глядя в будущее, мы видим мир, где проблемы вычислительной мощности, хотя и не исчезнут полностью, станут менее острыми. Мы мечтаем о времени, когда гениальная идея не будет похоронена под грудой финансовых или технических ограничений. Мы верим, что это возможно благодаря постоянным инновациям, как в аппаратном, так и в программном обеспечении, а также благодаря усилиям всего сообщества.

Наше видение включает в себя:

- Более энергоэффективный ИИ: Разработка моделей и аппаратного обеспечения, которые потребляют значительно меньше энергии, минимизируя экологический след. Это будет результатом совместных усилий инженеров, ученых-материаловедов и разработчиков алгоритмов.

- Доступные вычислительные ресурсы: Появление новых бизнес-моделей для облачных сервисов, развитие программ грантов и инициатив, направленных на предоставление бесплатных или дешевых ресурсов для академических и некоммерческих проектов.

- Интеллектуальные инструменты для оптимизации: Разработка автоматизированных систем, которые смогут самостоятельно оптимизировать модели и пайплайны обучения под доступные ресурсы, делая процесс более простым и эффективным.

Мы, как команда, будем продолжать активно участвовать в этом процессе. Мы будем делиться нашими знаниями, искать новые решения и поддерживать тех, кто только начинает свой путь в мире ИИ. Потому что в конечном итоге, вычислительная мощность – это всего лишь средство. Цель – это знания, инновации и создание лучшего будущего для всех.

Проблемы вычислительной мощности для обучения — это не просто техническое препятствие, это фундаментальный вызов, который формирует всю область искусственного интеллекта. Мы преодолеваем его каждый день, используя креативность, оптимизацию и силу сообщества. И мы уверены, что благодаря этим усилиям, будущее ИИ будет ярким и доступным для каждого, кто готов внести свой вклад. Мы продолжим наши исследования и эксперименты, ведь каждый терафлопс, который мы экономим или эффективно используем, приближает нас к новым открытиям. И на этом наша статья заканчивается.

Подробнее

| проблемы масштабирования ИИ | оптимизация вычислительных ресурсов ML | стоимость обучения нейронных сетей | энергопотребление глубокого обучения | альтернативы GPU для ИИ |

| распределенные вычисления для машинного обучения | будущее аппаратного обеспечения ИИ | доступность вычислительной мощности для стартапов | облачные сервисы для ML-тренировок | эффективность алгоритмов глубокого обучения |