- Разгадываем Тайны: Как Латентное Пространство Открывает Новые Измерения Данных

- Что такое латентное пространство и почему оно "скрытое"?

- Зачем нам сжатие и абстракция?

- Как мы создаем латентное пространство?

- Погружаемся глубже: Автоэнкодеры как архитекторы латентного пространства

- Сила вариационных автоэнкодеров (VAE)

- Применение латентного пространства: от искусства до науки

- Латентное пространство в NLP: Векторные представления слов

- Навигация по латентному ландшафту

- Интерполяция и экстраполяция

- Арифметические операции

- Расцепление признаков (Disentanglement)

- Вызовы и будущие направления

- Интерпретируемость

- Предвзятость (Bias)

- Масштабируемость и эффективность

- Будущие направления

Разгадываем Тайны: Как Латентное Пространство Открывает Новые Измерения Данных

Приветствуем, дорогие читатели и коллеги-исследователи цифровых миров! Сегодня мы с вами отправимся в увлекательное путешествие по одной из самых интригующих и мощных концепций в области искусственного интеллекта и машинного обучения – латентному пространству․ Это не просто абстрактный термин из учебника; это целый мир скрытых смыслов, который позволяет нам видеть данные совершенно по-новому, находить неочевидные связи и даже творить что-то совершенно новое․ Мы, как блогеры, стремящиеся понять и объяснить сложное простыми словами, убеждены, что это знание фундаментально меняет наш подход к работе с информацией․

Представьте себе огромный сундук, набитый до краев всевозможными предметами: от детских игрушек до старинных карт, от книг до экзотических специй․ Понять, что в этом сундуке, и найти что-то конкретное, будет невероятно сложно․ Но что, если бы мы могли волшебным образом упорядочить все эти предметы по их основным характеристикам – размеру, цвету, назначению, эпохе создания? Что, если бы мы могли увидеть не просто хаотичную груду, а элегантную, компактную схему, где каждый предмет занимает свое логичное место? Вот именно этим и занимается латентное пространство – оно берет хаос наших данных и превращает его в упорядоченную, значимую структуру․ Мы будем исследовать, как это происходит, зачем это нужно и какие невероятные возможности это открывает․ Пристегните ремни, наше погружение начинается!

Что такое латентное пространство и почему оно "скрытое"?

Для начала, давайте определимся с терминологией․ Латентное пространство – это, по сути, сжатое, низкоразмерное представление более сложных, высокоразмерных данных․ Думайте об этом как о "карте" или "резюме" наших исходных данных, где каждый объект (будь то изображение, текст, звук или что-то еще) представлен не своей полной и часто избыточной формой, а набором наиболее важных, информативных признаков․ Эти признаки, или "латентные переменные", являются скрытыми ("латентными"), потому что мы не наблюдаем их напрямую в исходных данных․ Они извлекаются, или "учатся", алгоритмами машинного обучения․

Возьмем, к примеру, фотографию кота․ Исходное изображение – это миллионы пикселей, каждый из которых имеет свой цвет и яркость․ Это очень много информации․ В латентном пространстве эта же фотография может быть представлена всего несколькими десятками или сотнями чисел․ Эти числа не хранят каждый пиксель, но они улавливают ключевые характеристики: наличие ушей, форму глаз, цвет шерсти, позу․ Мы не можем напрямую "увидеть" кота, глядя на эти числа, но компьютер может использовать их, чтобы понять, что это кот, отличить его от собаки, или даже сгенерировать новую фотографию кота, основываясь на этих же скрытых признаках․ Мы видим не сам объект, а его сущность, его "ДНК" в этом абстрактном измерении․

Зачем нам сжатие и абстракция?

Возникает резонный вопрос: зачем нам вообще нужна эта дополнительная сложность? Разве не проще работать с исходными данными? Ответ кроется в так называемом "проклятии размерности"․ Когда данные имеют очень много признаков (например, каждый пиксель изображения или каждое слово в документе), они становятся чрезвычайно разреженными, и расстояние между точками в этом пространстве становится менее значимым․ Это усложняет поиск закономерностей, кластеризацию и эффективное обучение моделей․

| Аспект | Высокоразмерные данные (исходные) | Низкоразмерные данные (латентное пространство) |

|---|---|---|

| Объем информации | Чрезмерный, много шума и избыточности․ | Сжатый, сосредоточен на ключевых признаках․ |

| Эффективность обработки | Высокие вычислительные затраты, медленная обработка․ | Значительно быстрее, меньше ресурсов․ |

| Поиск закономерностей | Сложно выявить связи из-за "проклятия размерности"․ | Легче обнаруживать кластеры и скрытые структуры․ |

| Шумоустойчивость | Чувствительность к случайным вариациям и ошибкам․ | Устойчивость к шуму благодаря извлечению сущности․ |

| Генеративные возможности | Прямая генерация очень сложна и неконтролируема․ | Позволяет создавать новые, реалистичные данные․ |

Мы стремимся к латентному пространству, потому что оно предлагает нам несколько ключевых преимуществ:

- Снижение размерности: Уменьшение количества признаков делает данные более управляемыми и менее подверженными "проклятию размерности"․

- Извлечение признаков: Оно автоматически находит наиболее важные, не избыточные признаки, которые наилучшим образом описывают данные․

- Шумоподавление: При сжатии менее значимые детали и шум часто отфильтровываются, оставляя только существенную информацию․

- Визуализация: Низкоразмерное представление часто позволяет нам визуализировать сложные данные на двух или трехмерном графике, что невозможно для исходных данных с тысячами признаков․

- Генерация: Как мы увидим далее, латентное пространство является основой для создания новых, реалистичных данных – от изображений до текста и музыки․

По сути, мы учим машину не запоминать каждую деталь, а понимать саму суть, создавать внутреннюю модель мира, которая позволяет ей мыслить и действовать более эффективно․

Как мы создаем латентное пространство?

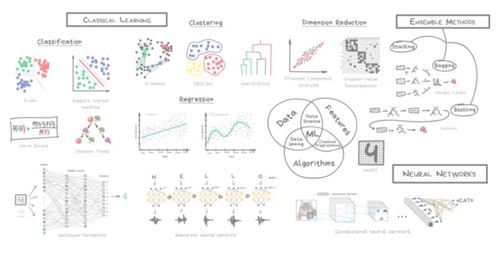

Создание латентного пространства – это процесс, который обычно включает в себя использование различных алгоритмов машинного обучения․ Эти алгоритмы обучены находить паттерны и структуры в исходных данных, чтобы представить их в более компактной форме․ Мы не "проектируем" латентное пространство вручную; вместо этого, мы обучаем модель, которая сама "учится" наилучшему способу сжатия и декодирования информации․

Вот некоторые из наиболее распространенных техник, которые мы используем для этого:

- Автоэнкодеры (Autoencoders): Это нейронные сети, специально разработанные для обучения эффективному кодированию данных․ Они пытаются воспроизвести свои входные данные на выходе, проходя через "бутылочное горлышко" – слой с меньшим количеством нейронов, который и формирует латентное пространство․

- Метод главных компонент (Principal Component Analysis, PCA): Классический статистический метод снижения размерности, который находит ортогональные оси (главные компоненты), вдоль которых данные имеют наибольшую дисперсию․ Эти компоненты и формируют латентное пространство․

- t-SNE (t-Distributed Stochastic Neighbor Embedding) и UMAP (Uniform Manifold Approximation and Projection): Эти алгоритмы в основном используются для визуализации․ Они отображают высокоразмерные данные в 2D или 3D пространстве таким образом, чтобы сохранить отношения близости между точками, позволяя нам "увидеть" кластеры и структуры․

- Генеративно-состязательные сети (Generative Adversarial Networks, GANs): Хотя GANs не создают латентное пространство напрямую для снижения размерности, их генераторная часть часто имеет скрытое входное пространство, из которого она учится генерировать новые данные․

Каждая из этих техник имеет свои сильные стороны и применяется в зависимости от конкретной задачи․ Но автоэнкодеры, пожалуй, являются наиболее интуитивным и гибким инструментом для понимания и манипулирования латентным пространством, поэтому мы уделим им особое внимание․

Погружаемся глубже: Автоэнкодеры как архитекторы латентного пространства

Когда мы говорим о латентном пространстве в контексте глубокого обучения, чаще всего мы имеем в виду автоэнкодеры․ Это удивительные нейронные сети, которые научили себя сжимать и разжимать информацию․ Представьте, что у вас есть очень сложный шифр, и вы хотите научить кого-то не просто запоминать последовательность символов, но понимать саму логику шифрования, чтобы потом можно было придумывать новые зашифрованные сообщения или расшифровывать похожие․ Автоэнкодеры делают нечто похожее с данными․

Архитектура автоэнкодера состоит из двух основных частей:

- Энкодер (Encoder): Эта часть сети принимает исходные данные (например, изображение) и постепенно сжимает их, пропуская через слои с уменьшающимся количеством нейронов, пока не достигнет самого узкого слоя – "бутылочного горлышка"․ Этот слой и является нашим латентным пространством․ Он содержит компактное, закодированное представление входных данных․

- Декодер (Decoder): Эта часть берет код из латентного пространства и пытается "развернуть" его, восстанавливая исходные данные․ Она работает в обратном направлении от энкодера, постепенно увеличивая количество нейронов до тех пор, пока не будет получена реконструкция․

Цель автоэнкодера – сделать так, чтобы выходные данные были максимально похожи на входные․ Мы обучаем его, минимизируя "ошибку реконструкции" – разницу между исходными данными и их восстановленной версией․ В процессе этого обучения, энкодер вынужден учиться извлекать самые важные признаки, а декодер – использовать эти признаки для воссоздания оригинала․ Если бы энкодер просто копировал входные данные в латентное пространство, а декодер просто считывал их, то не было бы никакого смысла․ Но из-за ограничения в размере латентного пространства (бутылочного горлышка) сеть вынуждена учиться абстрагироваться, находить сущность․

Сила вариационных автоэнкодеров (VAE)

Обычные автоэнкодеры отлично подходят для сжатия и реконструкции, но их латентное пространство может быть не очень "гладким" или "непрерывным"․ Это означает, что если мы возьмем две точки в латентном пространстве и попытаемся сгенерировать что-то из точки посередине, результат может быть бессмысленным․ Здесь на сцену выходят вариационные автоэнкодеры (VAE)․

VAE подходят к вопросу кодирования данных с вероятностной точки зрения․ Вместо того чтобы кодировать входные данные в одну фиксированную точку в латентном пространстве, энкодер VAE кодирует их в распределение вероятностей (например, нормальное распределение), описываемое средним значением и стандартным отклонением для каждой латентной переменной․ Это привносит элемент случайности в процесс кодирования и заставляет латентное пространство быть более структурированным и непрерывным․

Основные преимущества VAE:

- Генерация новых данных: Благодаря вероятностному подходу, мы можем просто сэмплировать (выбирать случайные точки) из латентного пространства и подавать их на вход декодера, чтобы генерировать совершенно новые, но реалистичные данные, которые никогда не были в обучающем наборе․

- Гладкое и непрерывное латентное пространство: Перемещаясь по латентному пространству VAE, мы можем наблюдать плавные переходы между различными характеристиками генерируемых данных․ Например, при генерации лиц, плавное движение между точками может менять улыбку, возраст или цвет волос․

- Интерполяция: Мы можем брать два разных изображения, кодировать их в латентное пространство, а затем интерполировать (плавно переходить) между их латентными представлениями, чтобы создавать промежуточные изображения, которые являются смесью исходных․

- Семантическое представление: VAE часто формируют латентное пространство, где похожие объекты находятся близко друг к другу, а различные – далеко, что делает его "семантически богатым"․

Мы видим, что VAE не просто сжимают информацию, они создают карту смысла, по которой мы можем перемещаться, исследовать и даже создавать новые территории․

Применение латентного пространства: от искусства до науки

Латентное пространство – это не просто теоретическая концепция; оно лежит в основе многих передовых технологий, которые мы используем или о которых слышим каждый день․ Мы видим его применение в самых разных областях, от создания произведений искусства до помощи в научных открытиях․

"Все следует упрощать до тех пор, пока это возможно, но не более того․"

— Альберт Эйнштейн

Эта цитата идеально отражает суть латентного пространства: оно упрощает данные до их сущности, но сохраняет всю необходимую для понимания и генерации информацию․

Давайте рассмотрим некоторые из наиболее впечатляющих применений:

- Генерация изображений и видео:

Наверное, самое зрелищное применение․ Модели, такие как Stable Diffusion, DALL-E, Midjourney, StyleGAN, используют глубокие латентные пространства для создания удивительно реалистичных изображений по текстовым описаниям или для преобразования одного стиля в другой․ Мы можем представить себе, как в этом скрытом мире хранятся "ручки" для каждого аспекта изображения – от освещения до текстуры, от позы до выражения лица․ Манипулируя этими "ручками", мы генерируем новые визуальные шедевры․

- Визуализация данных:

Когда у нас есть данные с сотнями или тысячами признаков, их невозможно напрямую отобразить на графике․ Алгоритмы вроде t-SNE или UMAP берут эти высокоразмерные данные, проецируют их в двух- или трехмерное латентное пространство, сохраняя при этом относительные расстояния между точками․ Это позволяет нам "увидеть" кластеры, выбросы и скрытые структуры в данных, которые иначе были бы невидимы․ Мы используем это для анализа генетических данных, клиентских сегментов или даже для понимания, как модель классифицирует объекты․

- Обнаружение аномалий:

В хорошо обученном латентном пространстве "нормальные" данные будут сгруппированы вместе․ Точки, которые находятся далеко от этих кластеров или в областях с низкой плотностью, являются потенциальными аномалиями․ Это может быть использовано для обнаружения мошенничества, неисправностей оборудования или необычного поведения пользователей․ Мы кодируем новые данные и смотрим, где они "приземляются" на нашей карте латентного пространства․

- Рекомендательные системы:

Латентное пространство играет ключевую роль в персонализированных рекомендациях․ Мы можем представить пользователей и товары (фильмы, книги, продукты) как точки в одном латентном пространстве․ Близость между точкой пользователя и точкой товара означает высокую вероятность того, что пользователь заинтересуется этим товаром․ Более того, мы можем выявить "латентные характеристики" товаров (например, жанр фильма, актеры, настроение) и предпочтения пользователя по этим характеристикам․

- Открытие лекарств и материалов:

В химии и материаловедении латентное пространство может использоваться для представления молекул или материалов․ Изучая это пространство, ученые могут предсказывать свойства новых, еще не синтезированных соединений или генерировать молекулы с желаемыми характеристиками․ Это значительно ускоряет процесс исследований и разработок․

- Обработка естественного языка (NLP):

Слова, предложения и целые документы могут быть представлены как векторы в латентном пространстве, известном как "векторные представления слов" или "вложения" (word embeddings); Это позволяет моделям понимать семантические отношения между словами и контекст․ Мы увидим это более подробно․

Каждое из этих применений демонстрирует, как латентное пространство переводит сложную информацию в форму, которая не только более эффективна для обработки, но и открывает двери для творчества и глубокого понимания․

Латентное пространство в NLP: Векторные представления слов

В области обработки естественного языка (NLP) латентное пространство проявило себя как особенно мощный инструмент․ До появления векторных представлений слов, компьютеры обрабатывали слова как дискретные, независимые сущности․ "Король" и "царь" были так же далеки друг от друга, как "король" и "банан"․ Это сильно ограничивало способность машин понимать смысл текста․

Векторные представления слов (Word Embeddings), такие как Word2Vec, GloVe или более современные BERT и GPT, изменили все․ Они обучают нейронные сети отображать слова в плотные векторы чисел в латентном пространстве, где семантически похожие слова находятся близко друг к другу․

| Слово | Примерный вектор (упрощенно) | Семантическая связь |

|---|---|---|

| Король | [0․8, 0․2, 0․7, 0․1, ․․․] | Вектор "мужчина" + вектор "правитель" |

| Королева | [0․7, 0․3, 0․6, 0․2, ․․․] | Вектор "женщина" + вектор "правитель" |

| Мужчина | [0․9, 0․1, 0․3, 0․0, ․․․] | Отражает гендерную характеристику |

| Женщина | [0․1, 0․9, 0․2, 0․5, ․․․] | Отражает гендерную характеристику |

| Яблоко | [0․5, 0․5, 0․1, 0․8, ․․․] | Вектор "фрукт" |

| Банан | [0․4, 0․6, 0․0, 0․9, ․․․] | Вектор "фрукт" |

Самое поразительное, что в этом латентном пространстве можно выполнять арифметические операции с векторами, которые отражают семантические отношения․ Например, если мы возьмем вектор слова "король", вычтем из него вектор "мужчина" и прибавим вектор "женщина", мы получим вектор, который будет очень близок к вектору слова "королева"․ Это демонстрирует, что латентное пространство улавливает не просто слова, а их сущностные характеристики и отношения․ Мы используем эти вложения в поисковых системах, системах машинного перевода, чат-ботах и многих других приложениях NLP․

Навигация по латентному ландшафту

После того как мы создали латентное пространство, возникает вопрос: как мы можем его исследовать и использовать? Это не просто статичная карта; это динамичный ландшафт, по которому мы можем путешествовать и который может отвечать на наши запросы․ Навигация по латентному пространству открывает новые способы взаимодействия с данными․

Мы можем представлять латентное пространство как многомерную карту, где каждая координата соответствует определенному скрытому признаку данных․ Перемещаясь по этой карте, мы можем плавно изменять характеристики генерируемых или анализируемых объектов․

Интерполяция и экстраполяция

Одной из самых захватывающих возможностей является интерполяция․ Если у нас есть две точки в латентном пространстве, соответствующие двум разным объектам (например, два лица), мы можем плавно двигаться по прямой линии между этими точками․ Декодер, получая промежуточные точки, будет генерировать последовательность изображений, которые постепенно переходят от одного лица к другому․ Это создает эффект "морфинга" и показывает непрерывность латентного пространства․ Мы видим, как черты одного лица постепенно сменяются чертами другого, проходя через реалистичные промежуточные состояния․

Экстраполяция, хотя и более рискованна, позволяет нам двигаться за пределы известных точек, потенциально генерируя совершенно новые, но логичные вариации․ Например, если мы можем "увеличить" улыбку, двигаясь в одном направлении, экстраполяция может привести к еще более широкой, гипертрофированной улыбке․

Арифметические операции

Как мы уже упоминали в контексте Word Embeddings, латентное пространство часто позволяет выполнять арифметические операции, которые имеют семантический смысл․ Это не просто сложение и вычитание чисел; это манипуляция понятиями․ Например, в латентном пространстве изображений, мы можем:

- Взять вектор, соответствующий изображению человека в очках, вычесть из него вектор "очки" и прибавить вектор "солнцезащитные очки", чтобы получить изображение того же человека в солнцезащитных очках․

- Манипулировать такими признаками, как возраст, пол, эмоциональное выражение, просто добавляя или вычитая определенные векторы, которые представляют эти концепции․

Это открывает путь к управляемой генерации и модификации данных, позволяя нам не просто создавать случайные объекты, а целенаправленно изменять их характеристики․

Расцепление признаков (Disentanglement)

Идеальное латентное пространство – это то, где каждая латентная переменная (каждая ось) соответствует независимому, интерпретируемому признаку данных․ Например, одна ось может контролировать цвет волос, другая – форму носа, третья – возраст, и т․д․․ Это называется расцеплением признаков (disentanglement)․

Достижение полного расцепления – сложная задача, но когда это удается, мы получаем невероятный контроль над процессом генерации․ Мы можем изолированно изменять один аспект данных, не влияя на другие․ Это особенно ценно в приложениях, где требуется точный контроль, например, в дизайне продукта, редактировании изображений или даже в создании реалистичных аватаров․ Мы можем тонко настраивать параметры, зная, что каждая "ручка" контролирует только один конкретный аспект․

Вызовы и будущие направления

Несмотря на все свои удивительные возможности, латентное пространство и методы его создания не лишены вызовов․ Мы, как исследователи и практики, постоянно сталкиваемся с определенными трудностями и работаем над их преодолением, открывая новые горизонты․

Интерпретируемость

Один из главных вызовов – интерпретируемость․ Что именно означает каждое измерение в латентном пространстве? Когда мы работаем с изображениями лиц, мы можем догадываться, что одна ось контролирует улыбку, а другая – возраст․ Но для более сложных данных или в пространствах очень высокой размерности интерпретация становится крайне сложной․ Мы часто имеем дело с "черным ящиком", где модель работает эффективно, но мы не до конца понимаем, почему и как․ Развитие методов, которые делают латентные признаки более понятными для человека, является активной областью исследований․

Предвзятость (Bias)

Латентное пространство, будучи продуктом обучения на данных, неизбежно отражает и усиливает любую предвзятость (bias), присутствующую в этих данных․ Если обучающий набор содержит больше изображений людей определенной расы или пола, то модель может хуже генерировать или интерпретировать изображения людей из недопредставленных групп․ Это может привести к нежелательным или даже дискриминационным результатам․ Мы осознаем, что борьба с предвзятостью в латентном пространстве – это не только техническая, но и этическая задача, требующая внимательного отношения к наборам данных и разработке справедливых алгоритмов․

Масштабируемость и эффективность

Работа с очень большими и высокоразмерными данными по-прежнему остается сложной задачей с точки зрения масштабируемости и вычислительной эффективности․ Обучение сложных генеративных моделей, таких как GANs или VAEs, требует огромных вычислительных ресурсов․ Оптимизация алгоритмов и разработка более эффективных архитектур являются ключевыми направлениями для дальнейшего прогресса․

Будущие направления

Несмотря на эти вызовы, будущее латентного пространства выглядит невероятно многообещающим․ Мы ожидаем увидеть:

- Более глубокое расцепление признаков: Модели будут лучше изолировать и контролировать отдельные аспекты данных, делая генерацию и редактирование более точными․

- Мультимодальные латентные пространства: Создание единых латентных пространств, которые могут представлять данные из разных модальностей (текст, изображение, звук) одновременно, открывая новые возможности для межмодального синтеза и понимания․

- Интерактивное исследование: Разработка инструментов, которые позволят людям интуитивно исследовать и манипулировать латентным пространством в реальном времени, без глубоких технических знаний․

- Применение в науке: Латентное пространство продолжит быть мощным инструментом для ускорения научных открытий в биологии, химии, физике и других областях, помогая ученым генерировать гипотезы и открывать новые закономерности․

Мы стоим на пороге новой эры, где латентное пространство не просто помогает нам обрабатывать данные, а позволяет нам взаимодействовать с их глубинными смыслами, создавая и открывая невиданные ранее миры․

Итак, мы с вами совершили глубокое погружение в мир латентного пространства – от его базовых определений до сложных архитектур и широчайших применений․ Мы увидели, как эта концепция, изначально возникшая из необходимости справиться с "проклятием размерности", превратилась в один из самых мощных инструментов в арсенале машинного обучения․ От генерации реалистичных изображений и видео до понимания семантики языка, от персонализированных рекомендаций до научных открытий – латентное пространство является невидимым двигателем многих инноваций․

Мы, как блогеры, искренне верим, что понимание этих скрытых измерений данных не просто открывает новые технологические возможности, но и меняет наше собственное восприятие информации и творчества․ Это дает нам возможность не только анализировать то, что есть, но и представлять то, чего еще нет, прокладывая мосты между нашим миром и миром, который мы можем создать․ Продолжайте исследовать, задавать вопросы и вдохновляться возможностями, которые открываются благодаря этим глубоким и скрытым мирам данных․

Подробнее

| Латентное пространство объяснение | Автоэнкодеры принцип работы | Применение VAE | Генерация изображений AI | Word Embeddings |

| Снижение размерности данных | Машинное обучение скрытые признаки | Нейронные сети для генерации | Визуализация высокоразмерных данных | NLP векторные представления |