- Трансформеры: Как Мы Перестали Бояться Чистого Листа и Научились Генерировать Шедевры

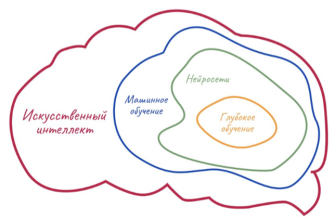

- Эволюция Текстовой Генерации: От Правил к Нейросетям

- От RNN к Трансформерам: Ключевые Отличия

- Сердце Революции: Архитектура Трансформеров

- Ключевые Компоненты Архитектуры

- Как Трансформеры "Учатся" Писать?

- Этапы Обучения

- Сферы Применения: Где Трансформеры Уже Меняют Игру

- Основные Области Применения

- Наш Опыт: Практическое Применение и Результаты

- Как Мы Интегрировали Трансформеры в Наш Блогерский Рабочий Процесс:

- Вызовы и Ограничения: Темная Сторона Блеска

- Основные Ограничения и Вызовы:

- Будущее Текстовой Генерации: Что Нас Ждет?

- Ключевые Тенденции и Перспективы:

Трансформеры: Как Мы Перестали Бояться Чистого Листа и Научились Генерировать Шедевры

В мире, где контент правит балом, а информационный поток никогда не иссякает, задача создания увлекательных и осмысленных текстов становится настоящим вызовом. Мы, как блогеры с многолетним стажем, хорошо знаем это чувство: сидишь перед мерцающим курсором, а голова пуста. Идеи витают где-то далеко, слова не складываются, а дедлайн безжалостно приближается. Но что, если мы скажем вам, что нашли способ не просто справляться с этим вызовом, но и превращать его в истинное удовольствие? Мы говорим о революции, имя которой – трансформеры, и о том, как они изменили наш подход к генерации текстов.

Забудьте о временах, когда искусственный интеллект казался чем-то из научно-фантастических фильмов, способным лишь на примитивные ответы и шаблонные фразы. Сегодня мы живем в эпоху, когда нейронные сети, основанные на архитектуре трансформеров, способны создавать тексты, которые порой неотличимы от написанных человеком. Это не просто инструмент, это наш новый соавтор, вдохновитель и порой даже критик. Приглашаем вас в увлекательное путешествие по миру, где машины учатся писать, а мы учимся использовать их потенциал на полную катушку.

Эволюция Текстовой Генерации: От Правил к Нейросетям

Чтобы по-настоящему оценить масштаб изменений, которые принесли трансформеры, давайте ненадолго оглянемся назад. Когда-то давно, в заре компьютерной эры, попытки заставить машину генерировать текст были весьма примитивными. Мы создавали строгие правила и словари, пытаясь имитировать человеческую речь. Результат был предсказуем: механические, негибкие тексты, лишенные какого-либо "души" или креативности. Представьте себе программу, которая могла бы только вставлять заранее определенные фразы в фиксированные шаблоны – это было похоже на сборку конструктора по очень жесткой инструкции.

Затем появились первые проблески надежды с появлением нейронных сетей. Рекуррентные нейронные сети (RNN) и их более продвинутые потомки, такие как сети с долгой краткосрочной памятью (LSTM), открыли дверь в мир, где машины могли "помнить" предыдущие слова и использовать их для генерации последующих. Это был огромный шаг вперед! Впервые мы увидели тексты, которые имели некоторую связность и даже могли имитировать стилистику. Однако у них были свои подводные камни. Главный из них – трудности с обработкой длинных зависимостей. Если предложение было слишком длинным, RNN могли "забыть" начало, что приводило к потере смысла и когерентности. Это было похоже на попытку запомнить длинную фразу, где к концу вы уже забываете, с чего начинали.

Именно в этот момент стало ясно, что для прорыва в области обработки естественного языка нам нужно что-то кардинально новое. Мы нуждались в архитектуре, которая могла бы эффективно работать с информацией на любом расстоянии в тексте, понимать контекст целиком, а не только по частям. И тогда, словно по мановению волшебной палочки, появился механизм внимания, а за ним и архитектура трансформеров, которая изменила всё. Мы больше не были ограничены последовательной обработкой информации; теперь машина могла "видеть" весь текст одновременно, уделяя внимание самым важным частям.

От RNN к Трансформерам: Ключевые Отличия

Для лучшего понимания этой эволюции, давайте сравним ключевые аспекты:

| Характеристика | Рекуррентные Нейронные Сети (RNN/LSTM) | Трансформеры |

|---|---|---|

| Обработка информации | Последовательная (слово за словом) | Параллельная (весь текст сразу) |

| Длинные зависимости | Трудности с сохранением контекста на больших расстояниях | Эффективная обработка, благодаря механизму внимания |

| Скорость обучения | Относительно медленная из-за последовательности | Значительно быстрее благодаря параллелизации |

| Архитектура | Циклические связи, "память" | Механизм внимания, позиционные кодировки, отсутствие рекурсии |

| Производительность в NLP | Хорошая для своего времени, но ограничена | Современный стандарт, превосходящий RNN во многих задачах |

Сердце Революции: Архитектура Трансформеров

Итак, что же такое этот "трансформер", который так сильно изменил правила игры? Представьте себе мощный механизм, который способен не просто читать слова по порядку, но и мгновенно устанавливать связи между любыми двумя словами в тексте, независимо от того, насколько далеко они друг от друга. Это ключевая идея, лежащая в основе трансформерной архитектуры. Впервые описанная в статье "Attention Is All You Need" в 2017 году, она отказалась от рекуррентных связей, которые долгое время были стандартом в обработке последовательностей.

Вместо того чтобы обрабатывать слова одно за другим, трансформер обрабатывает весь входной текст целиком. Это достигается за счет так называемого механизма самовнимания (self-attention). Если упростить, то каждое слово в предложении "смотрит" на все остальные слова в этом же предложении, чтобы понять, насколько они важны для его собственного смысла в данном контексте. Например, в предложении "Банк реки был пологим, и мы сели на банк, чтобы отдохнуть", механизм внимания помогает модели понять, что первое "банк" относится к береговой линии, а второе – к месту для сидения. Это позволяет трансформерам улавливать сложные контекстуальные зависимости, которые ранее были недоступны для машин.

Архитектура трансформеров обычно состоит из двух основных блоков: кодировщика (encoder) и декодировщика (decoder). Кодировщик отвечает за преобразование входного текста в векторное представление, насыщенное смыслом и контекстом. Декодировщик, в свою очередь, берет это представление и генерирует выходной текст, слово за словом. Каждый из этих блоков состоит из нескольких слоев, каждый из которых включает в себя механизм самовнимания и обычные полносвязные нейронные сети.

Ключевые Компоненты Архитектуры

- Механизм Самовнимания (Self-Attention): Это сердце трансформера. Он позволяет модели взвешивать важность различных слов в последовательности при обработке каждого слова. Вместо того, чтобы полагаться только на соседние слова, самовнимание позволяет модели "видеть" всю последовательность и выявлять долгосрочные зависимости.

- Многоголовое Внимание (Multi-Head Attention): Это расширение самовнимания, где механизм внимания применяется параллельно несколько раз (несколько "голов"). Каждая "голова" может фокусироваться на разных аспектах отношений между словами, что обогащает понимание контекста.

- Позиционное Кодирование (Positional Encoding): Поскольку трансформеры обрабатывают текст параллельно, они не имеют встроенного понимания порядка слов. Позиционное кодирование – это специальные векторы, которые добавляются к входным эмбеддингам слов, чтобы сообщить модели о позиции каждого слова в последовательности. Это позволяет модели сохранять информацию о порядке слов, что критически важно для смысла.

- Полносвязные Сверточные Сети (Feed-Forward Networks): После механизма внимания, информация проходит через стандартные нейронные сети, которые помогают модели дальше обрабатывать и трансформировать полученные представления.

Благодаря этим инновациям, трансформеры способны не просто генерировать текст, а создавать связные, логичные и даже творческие произведения, что ранее казалось фантастикой. Мы видим, как они понимают нюансы языка, идиомы, интонации – всё то, что делает человеческую речь такой богатой и сложной.

Как Трансформеры "Учатся" Писать?

Возникает логичный вопрос: как же эти сложные машины осваивают такую тонкую материю, как человеческий язык? Ответ кроется в колоссальных объемах данных и умных алгоритмах обучения. Трансформеры "учатся" писать, читая буквально триллионы слов из Интернета – книги, статьи, веб-страницы, диалоги. Это не просто чтение в нашем понимании; это глубокий анализ паттернов, структуры, грамматики, семантики и даже стилистики.

Процесс обучения трансформеров обычно разделяется на два основных этапа: предварительное обучение (pre-training) и дообучение/тонкая настройка (fine-tuning).

Этапы Обучения

- Предварительное Обучение: На этом этапе модель обучается на огромных, неразмеченных текстовых данных (то есть, без явных ответов или категорий). Основные задачи здесь – это:

- Маскированное Языковое Моделирование (Masked Language Modeling, MLM): Модели показывают предложения, в которых случайные слова "замаскированы" (заменены специальным токеном). Задача модели – предсказать эти скрытые слова на основе окружающего контекста. Это помогает ей понять отношения между словами и их смысл.

- Предсказание Следующего Предложения (Next Sentence Prediction, NSP): Модели показывают две части текста и просят определить, является ли вторая часть логическим продолжением первой. Это учит модель понимать связность и структуру дискурса.

- Дообучение (Fine-tuning): После предварительного обучения, когда модель уже обладает общими знаниями о языке, её можно "доучить" для выполнения конкретных задач. Например, если мы хотим, чтобы модель генерировала рекламные тексты, мы можем предоставить ей набор примеров хороших рекламных текстов. Модель адаптирует свои обширные знания под эту специфическую задачу, становясь экспертом в узкой области. Это похоже на то, как студент сначала изучает общую теорию, а затем специализируется в конкретной дисциплине.

Благодаря этим задачам, трансформер развивает глубокое понимание языка, его грамматики, синтаксиса, семантики и даже некоторых аспектов здравого смысла, которые проявляются в текстовых данных; Он учится предсказывать следующее слово или фразу с высокой точностью, основываясь на всем предыдущем контексте.

Именно эта двухэтапная стратегия делает трансформеры такими мощными и универсальными. Они сначала впитывают в себя весь объем человеческого знания, доступного в текстовой форме, а затем "шлифуют" свои навыки для выполнения конкретных, часто очень специализированных задач. Это позволяет нам получать на выходе не просто наборы слов, а осмысленные, контекстуально релевантные и часто креативные тексты.

«Язык – это карта дорог, которые мы прошли, и мостов, которые мы построили.»

— Людвиг Витгенштейн

Сферы Применения: Где Трансформеры Уже Меняют Игру

Когда мы говорим о трансформации, это не просто громкое слово. Мы видим, как трансформеры уже сейчас активно используются в самых разных областях, меняя привычные процессы и открывая новые горизонты. От повседневных задач до высокотехнологичных исследований – их влияние ощущается повсюду. Давайте рассмотрим некоторые из наиболее ярких примеров.

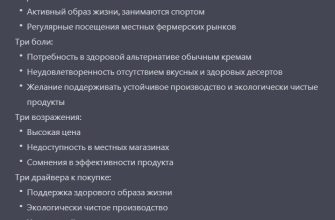

Основные Области Применения

- Создание Контента и Маркетинг: Это, пожалуй, одна из самых очевидных и широко используемых областей. Мы говорим о генерации рекламных слоганов, описаний товаров, постов для социальных сетей, черновиков статей, заголовков и даже целых блогов. Трансформеры могут быстро генерировать множество вариантов, экономя время маркетологов и копирайтеров.

- Креативное Письмо: Не ограничиваясь только деловым контентом, трансформеры проявляют себя и в творчестве. Они могут генерировать стихи, короткие рассказы, сценарии, диалоги; Конечно, они пока не заменят человеческого автора, но могут стать отличным инструментом для вдохновения и преодоления творческого застоя. Мы даже использовали их для генерации идей для наших историй!

- Чат-боты и Виртуальные Ассистенты: Благодаря трансформерам, современные чат-боты стали гораздо "умнее" и человечнее. Они могут вести связные диалоги, понимать контекст и даже улавливать эмоциональную окраску запросов пользователя, предоставляя более релевантные и полезные ответы.

- Машинный Перевод: Хотя это и не чисто генерация текста, трансформеры совершили революцию в машинном переводе. Их способность понимать контекст на большом протяжении текста позволяет создавать переводы, которые гораздо точнее и естественнее, чем у предыдущих систем.

- Суммирование Текстов: Модели-трансформеры могут эффективно сжимать длинные документы в краткие, информативные резюме, сохраняя при этом ключевой смысл. Это бесценно для анализа больших объемов информации.

- Генерация Программного Кода: Да, даже код! Трансформеры могут генерировать фрагменты кода на основе текстовых описаний, помогать в отладке или даже предлагать улучшения существующего кода.

- Образование: Создание учебных материалов, автоматическая генерация вопросов и ответов, персонализированные обучающие тексты – потенциал огромен.

Мы видим, что эти технологии не просто автоматизируют рутину, но и расширяют наши возможности, позволяя нам сосредоточиться на более сложных и творческих задачах. Они становятся незаменимыми помощниками в самых неожиданных сферах.

Наш Опыт: Практическое Применение и Результаты

Как блогеры, мы постоянно сталкиваемся с необходимостью генерировать свежий, интересный и качественный контент. Раньше это был процесс, требующий огромных временных и умственных затрат: от мозгового штурма до финальной вычитки. Сегодня, благодаря трансформерам, наш рабочий процесс преобразился до неузнаваемости. Мы не просто используем их, мы создаем синергию между человеческим интеллектом и мощью AI.

Наш опыт показывает, что трансформеры – это не замена человеку, а скорее мощный ускоритель. Мы используем их для самых разных задач, которые значительно повышают нашу продуктивность и качество контента.

Как Мы Интегрировали Трансформеры в Наш Блогерский Рабочий Процесс:

- Мозговой Штурм и Генерация Идей: Когда мы сталкиваемся с творческим кризисом, мы обращаемся к трансформерам. Задавая им общие темы или несколько ключевых слов, мы получаем десятки, а то и сотни вариантов заголовков, подзаголовков, тезисов и даже целых концепций для статей. Это позволяет нам быстро найти свежий угол зрения или развить уже имеющуюся идею.

- Создание Черновиков и Структуры: Вместо того чтобы часами сидеть над пустым документом, мы просим модель сгенерировать черновик по заданной структуре. Например, для этой статьи мы сначала попросили трансформер набросать основные разделы и ключевые пункты, которые нужно раскрыть. Это дает нам прочный скелет, который мы затем "наращиваем" собственными мыслями и опытом.

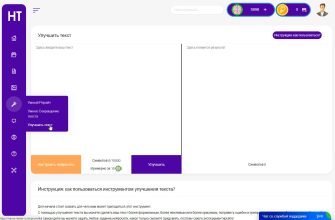

- Расширение и Перефразирование Текста: Иногда у нас есть отличная мысль, но не хватает слов, чтобы полностью её раскрыть. Мы можем подать эту мысль трансформеру, и он предложит различные способы её формулировки, добавит детали, примеры или аналогии. Точно так же мы используем его для перефразирования сложных предложений, делая текст более читабельным и доступным.

- Оптимизация для Поисковых Систем (SEO): Трансформеры помогают нам генерировать варианты мета-описаний, тегов и даже анализировать ключевые слова, чтобы улучшить видимость наших статей. Они могут предложить синонимы и связанные фразы, которые мы могли упустить.

- Генерация Вступлений и Заключений: Эти части статьи часто являются самыми сложными. Модель может предложить несколько вариантов, которые цепляют читателя с первых строк или красиво завершают повествование, оставляя сильное впечатление.

- Преодоление "Блока Писателя": Это, пожалуй, одно из самых ценных преимуществ. Когда мы чувствуем, что застряли, небольшой "толчок" от трансформера может разбить ступор и вернуть нас в поток творчества. Это как иметь под рукой бесконечный источник вдохновения.

Вот пример того, как мы используем трансформеры для сравнения эффективности. Мы заметили значительное увеличение скорости работы:

| Задача | Время до использования Трансформеров (приблизительно) | Время с использованием Трансформеров (приблизительно) | Улучшение |

|---|---|---|---|

| Мозговой штурм (10 идей) | 30-60 минут | 5-10 минут | 5-10 раз |

| Написание черновика | 2-3 часа | 30-60 минут | 2-4 раза |

| Генерация 5 вариантов заголовков | 15-30 минут | 2-5 минут | 3-15 раз |

| Перефразирование абзаца | 10-15 минут | 1-2 минуты | 5-15 раз |

| Создание мета-описания для SEO | 20-40 минут | 3-7 минут | 5-7 раз |

Важно подчеркнуть: мы всегда редактируем, дорабатываем и персонализируем сгенерированный текст. Трансформеры дают нам основу, а мы добавляем к ней свой уникальный голос, опыт и человеческое прикосновение. Это не полная автоматизация, а скорее умная автоматизация, которая позволяет нам сосредоточиться на качестве и креативности, а не на рутине. Мы стали быстрее, продуктивнее и, что самое главное, получаем больше удовольствия от процесса создания контента.

Вызовы и Ограничения: Темная Сторона Блеска

Несмотря на все неоспоримые преимущества и захватывающие возможности, было бы нечестно умолчать о тех вызовах и ограничениях, с которыми мы сталкиваемся, работая с трансформерами. Как и любая мощная технология, они не лишены своих недостатков и требуют осознанного подхода. Мы убеждены, что понимание этих "темных сторон" не только позволяет нам использовать их более эффективно, но и формирует ответственное отношение к будущему AI.

Основные Ограничения и Вызовы:

- Галлюцинации и Фактические Неточности: Пожалуй, это одно из самых серьезных ограничений. Трансформеры, особенно при запросах на специфические факты или данные, могут "галлюцинировать" – то есть генерировать информацию, которая звучит убедительно, но является полностью вымышленной или неверной. Модели не "знают" фактов в человеческом смысле, они лишь предсказывают наиболее вероятную последовательность слов на основе того, что видели в данных. Поэтому критически важно всегда проверять сгенерированный контент на достоверность. Мы никогда не публикуем текст без тщательной проверки фактов.

- Предвзятость (Bias) в Обучающих Данных: Модели обучаются на огромных массивах текстовых данных, собранных из Интернета. А Интернет, как мы знаем, отражает все человеческие предрассудки и стереотипы. В результате, трансформеры могут воспроизводить и даже усиливать эти предвзятости, генерируя тексты, которые являются дискриминационными, стереотипными или несправедливыми. Это поднимает серьезные этические вопросы, и мы должны быть крайне внимательны к выходным данным, чтобы не распространять вредоносный контент.

- Отсутствие Истинного Понимания и Здравого Смысла: Хотя трансформеры великолепно имитируют человеческую речь, они не обладают истинным пониманием мира, здравым смыслом или сознанием. Они оперируют статистическими зависимостями между словами, а не глубоким осмыслением. Это приводит к тому, что порой сгенерированный текст может быть логически непоследовательным или нелепым, особенно при работе с абстрактными понятиями или сложными рассуждениями.

- Этические Вопросы и Злоупотребления: Возможность генерировать высококачественный текст порождает ряд этических дилемм. Это и потенциал для массового создания фейковых новостей, дезинформации, спама, и вопросы авторства, плагиата. Нам необходимо развивать не только технологию, но и этические рамки её использования.

- Высокие Вычислительные Затраты: Обучение и даже использование очень больших моделей-трансформеров требует значительных вычислительных ресурсов (мощные GPU, большое количество памяти), что делает их не всегда доступными для всех. Это ограничивает их применение в некоторых условиях.

-

Повторяемость и Отсутствие Оригинальности: Иногда, особенно при недостаточной настройке или слишком общем запросе, трансформеры могут генерировать повторяющийся или шаблонный текст, лишенный оригинальности. Наша задача – направлять их так, чтобы они раскрывали свой креативный потенциал, а не просто перемалывали информацию.

Мы видим в этих ограничениях не повод для отказа от технологии, а скорее призыв к более вдумчивому и ответственному использованию. Трансформеры – это мощный инструмент, и, как любой инструмент, он может быть использован как во благо, так и во вред. Наша роль, как пользователей и блогеров, заключается в том, чтобы направлять его силу в правильное русло, всегда сохраняя критическое мышление и человеческую этику.

Будущее Текстовой Генерации: Что Нас Ждет?

Заглядывая в будущее, мы понимаем, что трансформеры – это лишь начало большого пути. То, что мы видим сегодня, уже впечатляет, но завтрашний день обещает еще более головокружительные перспективы. Мы стоим на пороге новой эры, где взаимодействие человека и машины в создании контента станет еще более глубоким и бесшовным.

Ключевые Тенденции и Перспективы:

- Более Сложные и Нюансированные Модели: Мы увидим развитие моделей, которые смогут не только генерировать текст, но и лучше понимать эмоциональный контекст, сарказм, иронию и другие тонкие аспекты человеческой коммуникации. Они будут адаптироваться к стилю автора еще более точно, становясь настоящими "литературными хамелеонами".

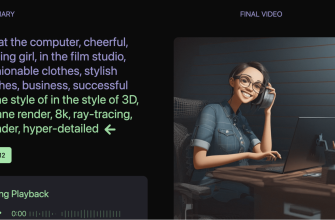

- Мультимодальная Генерация: Будущее не ограничивается только текстом. Уже сейчас мы видим модели, способные генерировать изображения по текстовому описанию. Вскоре мы можем ожидать появления систем, которые смогут создавать комплексный контент: текст, изображения, видео и даже аудио, основываясь на одном запросе. Представьте себе статью, которая сама генерирует иллюстрации и подкаст-версию!

- Персонализация и Адаптивность: AI будет еще лучше адаптироваться к индивидуальным потребностям и предпочтениям пользователя. Модели смогут генерировать тексты, которые идеально соответствуют вашему личному стилю, вашим знаниям и вашей аудитории. Это откроет новые возможности для персонализированного обучения, маркетинга и развлечений.

- Улучшенное Понимание и Верификация Фактов: Исследователи активно работают над тем, чтобы снизить проблему "галлюцинаций" и повысить фактическую точность генерируемого контента. Возможно, будущие трансформеры будут иметь встроенные механизмы для проверки информации по авторитетным источникам.

- Этические Рамки и Регулирование: По мере развития технологии, вопросы этики и регулирования будут становиться все более острыми. Мы ожидаем активной разработки стандартов и рекомендаций по ответственному использованию генеративного AI, чтобы минимизировать риски и максимизировать пользу.

- Симбиотическое Сотрудничество Человека и AI: Вместо того чтобы опасаться замены, мы видим будущее, где AI и человек работают рука об руку. Трансформеры будут выступать в роли мощных интеллектуальных помощников, освобождая нас от рутины и позволяя сосредоточиться на творчестве, стратегии и глубоком смысле. Мы, люди, будем задавать направление, а AI будет помогать нам достигать целей с беспрецедентной скоростью и эффективностью.

Это захватывающее время для всех, кто работает с текстом. Мы верим, что трансформеры не просто изменяют наш рабочий процесс, но и заставляют нас переосмыслить само понятие творчества, интеллекта и коммуникации. Они открывают дверь в мир, где наши идеи могут воплощаться быстрее и ярче, чем когда-либо прежде.

Мы прошли долгий путь от первых неуклюжих попыток заставить машины говорить до сегодняшнего дня, когда трансформеры генерируют тексты, порой неотличимые от человеческих. Этот путь не был простым, но он привел нас к точке, где мы, блогеры, можем с уверенностью сказать: эра чистых листов и творческих кризисов осталась в прошлом. Мы научились использовать мощь искусственного интеллекта, чтобы не просто писать больше, но и писать лучше, глубже, интереснее.

Трансформеры стали для нас не просто инструментом, а настоящим партнером, открывающим новые горизонты в создании контента. Они помогают нам генерировать идеи, преодолевать барьеры, расширять кругозор и, в конечном итоге, доносить наши мысли до читателей с большей ясностью и воздействием. Да, у них есть свои ограничения и вызовы, но осознанное и ответственное использование позволяет нам минимизировать риски и максимально использовать их потенциал.

Мы верим, что будущее принадлежит тем, кто готов учиться, адаптироваться и экспериментировать с новыми технологиями. Использование трансформеров для генерации текстов – это не просто модная тенденция, это неизбежная эволюция в мире цифрового контента. Присоединяйтесь к нам в этом увлекательном путешествии, и вместе мы сможем создавать тексты, которые будут вдохновлять, информировать и развлекать. Точка.

Подробнее

| GPT модели для текста | Нейросети для генерации | AI копирайтинг | Автоматическая генерация контента | NLP технологии |

| Архитектура трансформеров | Применение GPT | Будущее генерации текста | Этика AI текста | Трансформеры и писательство |