- За гранью возможностей: Как вычислительная мощность становится ахиллесовой пятой ИИ

- Восхождение гигантов: Почему наши модели так прожорливы?

- Экспоненциальный рост и закон Мура: Разрыв в ожиданиях

- Теневые стороны медали: Конкретные проблемы

- Стоимость: Дорогая цена за интеллект

- Экологический след: Цена для планеты

- Доступность и демократизация: Кто будет формировать будущее ИИ?

- Бутылочные горлышки аппаратного обеспечения и данных

- Пути вперёд: Решения и стратегии

- Инновации в аппаратном обеспечении: Новое поколение чипов

- Программная оптимизация: Умные алгоритмы и фреймворки

- Распределенные вычисления и облачные платформы

- Зеленый ИИ и устойчивое развитие

За гранью возможностей: Как вычислительная мощность становится ахиллесовой пятой ИИ

В последние годы мы стали свидетелями поистине ошеломляющего прогресса в области искусственного интеллекта․ От революционных прорывов в обработке естественного языка до систем‚ способных обыгрывать чемпионов мира в сложнейших играх‚ кажется‚ что горизонты возможностей ИИ расширяются с каждым днём․ Мы‚ как блогеры‚ живущие и дышащие технологиями‚ с восторгом наблюдаем за этими изменениями‚ делясь с вами каждым новым открытием․ Однако за блеском этих достижений скрывается одна из самых острых и фундаментальных проблем‚ которая угрожает замедлить‚ а возможно‚ и перенаправить весь ход развития ИИ: постоянно растущая и ненасытная потребность в вычислительной мощности․

Мы помним времена‚ когда относительно скромные аппаратные ресурсы и тщательно подобранные алгоритмы могли творить чудеса‚ открывая новые возможности для машинного обучения․ Сегодня же‚ чтобы сделать следующий шаг‚ создать более умные‚ более сложные и более универсальные модели‚ мы сталкиваемся с экспоненциальным ростом требований к "железу"․ Это не просто техническая проблема; это экономический‚ экологический и даже этический вызов‚ который мы обязаны осмыслить и решить‚ если хотим‚ чтобы будущее‚ обещанное искусственным интеллектом‚ стало доступным для всех‚ а не только для избранных гигантов индустрии․

Восхождение гигантов: Почему наши модели так прожорливы?

Чтобы понять глубину проблемы‚ давайте оглянемся назад и посмотрим‚ как мы пришли к текущей ситуации․ На заре развития глубокого обучения‚ когда нейронные сети только начинали демонстрировать свой потенциал‚ размер моделей и объем данных‚ на которых они обучались‚ были относительно невелики․ Мы экспериментировали с архитектурами‚ оттачивали алгоритмы и радовались каждому проценту улучшения точности на стандартных датасетах․ Это было время‚ когда один талантливый исследователь или небольшая команда могли в одиночку совершить прорыв‚ используя доступное оборудование․

Однако с появлением более сложных задач‚ таких как распознавание изображений с высокой точностью или генерация связного текста‚ мы быстро осознали‚ что для достижения по-настоящему впечатляющих результатов требуется нечто большее․ Мы начали масштабировать: увеличивать количество слоев в нейронных сетях‚ расширять размер каждого слоя‚ и‚ конечно же‚ кормить эти сети всё большими объемами данных․ Этот подход‚ получивший название "масштабирование"‚ оказался невероятно эффективным․ Чем больше параметров у модели‚ тем больше она может "узнать" из данных‚ и тем сложнее закономерности она способна обнаружить․

Пиком этого тренда стали так называемые "фундаментальные модели" (foundation models) или большие языковые модели (LLMs)‚ такие как GPT-3‚ BERT‚ AlphaFold и их многочисленные преемники․ Эти модели содержат сотни миллиардов‚ а иногда и триллионы параметров‚ и обучаются на петабайтах данных‚ собранных из интернета и других источников․ Мы наблюдаем‚ как они демонстрируют удивительные способности к рассуждению‚ генерации текста‚ программированию и даже творчеству․ Но цена за эти способности колоссальна․ Каждый новый прорыв в этой области сопряжен с требованием ещё большей вычислительной мощности‚ что ставит нас перед лицом серьёзных ограничений․

Экспоненциальный рост и закон Мура: Разрыв в ожиданиях

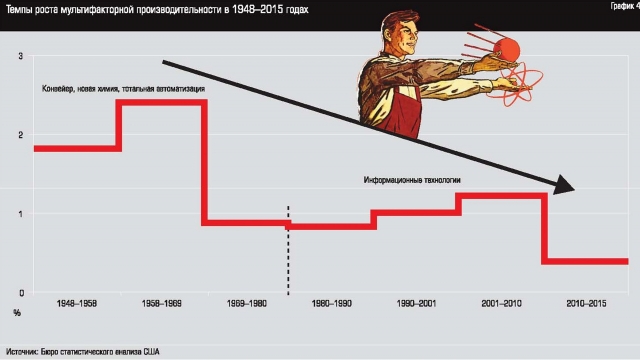

Исторически развитие компьютерной техники подчинялось закону Мура‚ который предсказывал удвоение количества транзисторов на интегральной схеме примерно каждые два года․ Долгое время этот закон служил надежным ориентиром‚ позволяя нам ожидать постоянного прироста производительности и снижения стоимости вычислений․ Однако в последние годы мы видим‚ что темпы роста замедляются․ Физические ограничения кремния‚ тепловыделение и сложности миниатюризации делают дальнейшее следование закону Мура всё более трудным и дорогостоящим․

В то же время‚ потребность в вычислительной мощности для обучения ИИ-моделей растёт гораздо быстрее․ Некоторые исследования показывают‚ что требования к вычислениям для передовых моделей удваиваются каждые несколько месяцев‚ а не лет․ Это создает огромный разрыв: аппаратное обеспечение не может развиваться достаточно быстро‚ чтобы удовлетворить ненасытный аппетит наших алгоритмов․ Мы как будто пытаемся наполнить бассейн‚ который расширяется быстрее‚ чем мы успеваем заливать в него воду․

"Мы всегда переоцениваем изменения‚ которые произойдут в следующие два года‚ и недооцениваем изменения‚ которые произойдут в следующие десять лет․ Не позволяйте себе бездействовать․"

— Билл Гейтс

Эта цитата Билла Гейтса как нельзя лучше отражает наше положение․ Мы‚ возможно‚ недооцениваем долгосрочные последствия текущих вычислительных ограничений‚ если не начнем активно искать решения уже сейчас․ Проблема не исчезнет сама собой; она будет только усугубляться по мере того‚ как мы стремимся к созданию всё более интеллектуальных систем․

Теневые стороны медали: Конкретные проблемы

Когда мы говорим о проблемах вычислительной мощности‚ речь идёт не только о скорости․ Мы сталкиваемся с целым комплексом вызовов‚ которые затрагивают различные аспекты развития и внедрения ИИ․

Стоимость: Дорогая цена за интеллект

Первая и‚ пожалуй‚ наиболее очевидная проблема – это колоссальная стоимость․ Обучение больших моделей требует не только специализированных чипов (таких как GPU NVIDIA A100 или H100‚ TPU Google)‚ но и целых кластеров этих чипов‚ работающих параллельно в течение недель или даже месяцев․ Стоимость одного такого чипа может исчисляться десятками тысяч долларов‚ а для создания полноценного кластера требуются миллионы․

Даже если мы не покупаем оборудование напрямую‚ а арендуем вычислительные ресурсы в облаке (AWS‚ Google Cloud‚ Azure)‚ затраты всё равно остаются астрономическими․ Мы наблюдаем‚ как стоимость одного лишь "эксперимента" с большой моделью может превысить годовой бюджет небольшой исследовательской лаборатории или стартапа․ Это создает огромный барьер для входа‚ концентрируя передовые исследования и разработки в руках лишь нескольких технологических гигантов‚ способных позволить себе такие инвестиции․

Примерные затраты на обучение некоторых известных моделей (могут варьироваться в зависимости от оптимизации и выбора оборудования):

| Модель | Примерное количество параметров | Примерная стоимость обучения | Время обучения |

|---|---|---|---|

| GPT-3 | 175 миллиардов | ~4․6 миллиона долларов | Месяцы |

| Megatron-LM | 8․3 миллиарда | ~100-200 тысяч долларов | Недели |

| AlphaGo Zero | Десятки миллионов | ~35 миллионов долларов (Google TPU) | Недели |

| BERT Large | 340 миллионов | ~1․7-7 тысяч долларов | Дни |

Примечание: Эти цифры являются оценочными и могут значительно варьироваться․

Экологический след: Цена для планеты

Помимо финансовой стоимости‚ существует и экологическая․ Работающие на полную мощность кластеры GPU потребляют огромное количество электроэнергии‚ генерируя значительные объемы тепла‚ которое‚ в свою очередь‚ требует дополнительной энергии для охлаждения․ Мы‚ как ответственные граждане мира‚ не можем игнорировать этот аспект․ Углеродный след от обучения больших ИИ-моделей сопоставим с выбросами от нескольких автомобилей за весь их жизненный цикл‚ а в некоторых случаях даже больше․

Это ставит перед нами серьезный вопрос: можем ли мы продолжать развивать ИИ таким энергозатратным способом‚ когда мир борется с изменением климата? Мы обязаны искать пути к "зеленому" ИИ‚ разрабатывать более энергоэффективные алгоритмы и аппаратное обеспечение‚ а также использовать возобновляемые источники энергии для питания дата-центров․

Доступность и демократизация: Кто будет формировать будущее ИИ?

Высокая стоимость и огромные вычислительные требования создают проблему доступности․ Если только несколько компаний могут позволить себе обучение передовых моделей‚ это означает‚ что только они и будут определять направление развития ИИ․ Это ограничивает разнообразие идей‚ подходов и голосов в исследованиях․ Мы верим‚ что будущее ИИ должно быть инклюзивным‚ формируемым широким кругом исследователей‚ стартапов и сообществ по всему миру․

Когда доступ к передовым вычислительным ресурсам ограничен‚ это напрямую влияет на:

- Разнообразие исследований: Меньше независимых исследований и экспериментов;

- Инновации: Замедление темпов инноваций за пределами крупных корпораций․

- Этический контроль: Меньше возможностей для независимой проверки и аудита моделей․

- Географическое неравенство: Концентрация ИИ-мощностей в нескольких регионах мира․

Мы должны стремиться к созданию более демократичной экосистемы ИИ‚ где любой талантливый исследователь‚ независимо от его финансового положения‚ может внести свой вклад․

Бутылочные горлышки аппаратного обеспечения и данных

Проблема не сводится только к наличию GPU․ Мы сталкиваемся с рядом других аппаратных ограничений:

- Память: Большие модели требуют колоссального объема оперативной памяти․ Передача данных между памятью и вычислительными ядрами становится бутылочным горлышком․

- Межсоединения: Эффективная связь между тысячами GPU в кластере критически важна․ Технологии‚ такие как NVLink или InfiniBand‚ пытаются решить эту проблему‚ но это дорого и сложно․

- Скорость дисковой подсистемы: Загрузка петабайтов данных с диска на кластер также является серьезной задачей‚ требующей высокопроизводительных систем хранения данных․

- Охлаждение: Выделяемое тепло требует сложных и дорогостоящих систем охлаждения‚ которые сами по себе потребляют энергию и занимают пространство․

Эти аспекты часто остаются за кадром‚ когда мы говорим о "вычислительной мощности"‚ но они не менее важны для эффективного масштабирования обучения ИИ․

Пути вперёд: Решения и стратегии

Несмотря на кажущуюся непреодолимость проблем‚ мы не стоим на месте; Сообщество исследователей и инженеров активно работает над многосторонними решениями‚ которые включают в себя как аппаратные‚ так и программные инновации․

Инновации в аппаратном обеспечении: Новое поколение чипов

Зависимость от универсальных GPU‚ изначально разработанных для графики‚ постепенно уступает место появлению специализированных чипов‚ оптимизированных именно для задач машинного обучения․ Мы видим несколько ключевых направлений:

- ASIC (Application-Specific Integrated Circuits): Это полностью настраиваемые чипы‚ разработанные для выполнения конкретных операций ИИ с максимальной эффективностью․ Примеры включают Google TPU‚ которые показали выдающуюся производительность для определенных типов нейронных сетей․

- FPGA (Field-Programmable Gate Arrays): Эти чипы предлагают баланс между гибкостью и производительностью․ Их можно перепрограммировать для различных задач‚ что делает их привлекательными для исследователей‚ экспериментирующих с новыми архитектурами․

- Нейроморфные чипы: Вдохновленные работой человеческого мозга‚ эти чипы стремятся имитировать биологические нейронные сети‚ предлагая потенциально колоссальные улучшения в энергоэффективности для определенных задач․ Проекты‚ такие как IBM TrueNorth и Intel Loihi‚ активно исследуют это направление․

- Квантовые компьютеры: Хотя пока что это скорее научная фантастика для массового ИИ‚ квантовые вычисления обещают революционные прорывы в решении некоторых типов задач оптимизации‚ которые лежат в основе машинного обучения․ Мы внимательно следим за их развитием․

Мы видим‚ как крупные компании‚ такие как Amazon (с Graviton и Trainium/Inferentia)‚ Microsoft (с Project Brainwave) и другие‚ разрабатывают собственные чипы‚ чтобы уменьшить зависимость от внешних поставщиков и оптимизировать свои инфраструктуры под конкретные рабочие нагрузки ИИ․ Это здоровый признак диверсификации и конкуренции‚ которая в конечном итоге должна привести к более эффективным решениям․

Программная оптимизация: Умные алгоритмы и фреймворки

Не менее важную роль играют инновации на программном уровне․ Даже самое мощное "железо" будет неэффективным без грамотно написанного и оптимизированного кода․ Мы‚ разработчики‚ постоянно ищем способы сделать наши модели более "бережливыми":

- Эффективные архитектуры: Разработка новых архитектур нейронных сетей‚ которые достигают аналогичной или лучшей производительности при меньшем количестве параметров или вычислений․ Примеры включают MobileNet‚ EfficientNet и различные упрощенные варианты трансформеров․

- Квантование моделей: Уменьшение точности чисел‚ используемых для представления весов и активаций модели (например‚ с 32-битных чисел с плавающей запятой до 16-битных или даже 8-битных целых чисел)․ Это значительно сокращает объем памяти и ускоряет вычисления с минимальной потерей точности․

- Прунинг (обрезка) моделей: Удаление наименее важных связей или нейронов в сети‚ что делает модель "тоньше" и быстрее‚ не теряя при этом значительной части своей производительности․

- Дистилляция знаний: Обучение меньшей "студенческой" модели имитировать поведение более крупной "учительской" модели‚ что позволяет получить компактную и быструю версию‚ сохраняющую большую часть функциональности․

- Разреженность (Sparsity): Использование разреженных матриц и операций‚ где большинство элементов равны нулю․ Это позволяет пропускать ненужные вычисления‚ значительно экономя ресурсы․

- Оптимизация фреймворков: Постоянное улучшение библиотек глубокого обучения‚ таких как PyTorch и TensorFlow‚ для более эффективного использования доступного оборудования‚ включая автоматическое смешанное обучение (mixed-precision training) и распределенные стратегии․

Эти методы позволяют нам "выжимать" максимум из существующих ресурсов и делать большие модели более доступными для широкого круга задач‚ особенно на периферийных устройствах․

Распределенные вычисления и облачные платформы

Для решения задач крупномасштабного обучения мы активно используем распределенные вычисления․ Это означает разделение задачи обучения на множество мелких частей и их выполнение на нескольких машинах или чипах одновременно․ Мы используем различные стратегии:

- Параллелизм данных (Data Parallelism): Каждая машина или чип получает копию модели и обучает её на своей части данных․ Градиенты усредняются и синхронизируются․

- Параллелизм моделей (Model Parallelism): Сама модель делится на части‚ и каждая часть выполняется на отдельном устройстве․ Это необходимо для моделей‚ которые слишком велики‚ чтобы поместиться в память одного чипа․

- Конвейерный параллелизм (Pipeline Parallelism): Слои модели распределяются по разным устройствам‚ и данные "протекают" через них‚ как по конвейеру․

Облачные провайдеры (AWS‚ Google Cloud‚ Azure) играют ключевую роль‚ предоставляя доступ к масштабируемым кластерам GPU и TPU․ Они снимают с нас бремя управления физическим оборудованием‚ позволяя сосредоточиться на исследованиях․ Однако‚ как мы уже упоминали‚ это сопряжено с высокой стоимостью и потенциальной зависимостью от конкретного провайдера․ Мы стремимся к тому‚ чтобы эти платформы становились более доступными и конкурентоспособными․

Зеленый ИИ и устойчивое развитие

Концепция "Зеленого ИИ" приобретает все большее значение․ Мы не можем игнорировать экологический след наших моделей․ Это направление включает в себя:

- Энергоэффективные алгоритмы: Разработка алгоритмов‚ которые требуют меньше вычислений для достижения аналогичной производительности․

- Оптимизация дата-центров: Использование возобновляемых источников энергии‚ более эффективных систем охлаждения и умного управления нагрузкой․

- Повторное использование моделей: Вместо обучения с нуля‚ мы можем использовать предобученные модели и дообучать их для конкретных задач (transfer learning)‚ что значительно снижает вычислительные затраты․

- Оценка и отчетность: Разработка метрик для измерения углеродного следа ИИ-моделей и поощрение прозрачной отчетности․

Мы верим‚ что устойчивое развитие ИИ является не просто опцией‚ а необходимостью для долгосрочного и этичного прогресса в этой области․

Проблема вычислительной мощности для обучения ИИ — это комплексный вызов‚ который требует многогранных решений․ Мы‚ как сообщество‚ стоим на распутье․ С одной стороны‚ мы видим невероятный потенциал искусственного интеллекта для решения сложнейших мировых проблем‚ от медицины до изменения климата․ С другой стороны‚ мы сталкиваемся с физическими‚ экономическими и экологическими ограничениями‚ которые угрожают замедлить наш прогресс и сделать передовые технологии доступными лишь для немногих․

Однако‚ мы оптимистичны․ История технологий показывает‚ что каждый раз‚ когда мы сталкиваемся с кажущимися непреодолимыми барьерами‚ человеческая изобретательность находит новые пути․ Будь то создание новых аппаратных архитектур‚ разработка более умных и эффективных алгоритмов‚ или переосмысление того‚ как мы подходим к обучению моделей‚ мы продолжаем двигаться вперед․ Мы наблюдаем за тем‚ как облачные сервисы становятся умнее‚ предоставляя более гибкие и специализированные ресурсы․ Мы видим‚ как исследователи неустанно ищут "золотую середину" между производительностью и эффективностью․

Для нас‚ как для блогеров‚ пишущих на личном опыте‚ эта проблема является постоянным напоминанием о том‚ что прогресс не дается легко․ Он требует постоянных усилий‚ инноваций и сотрудничества․ Мы призываем всех – исследователей‚ инженеров‚ политиков и обычных пользователей – осознать масштаб этой проблемы и активно участвовать в поиске решений․ Только так мы сможем обеспечить‚ чтобы следующая волна ИИ была не только мощной и интеллектуальной‚ но и доступной‚ устойчивой и этичной для всего человечества․

На этом статья заканчивается․

Подробнее: LSI запросы к статье

Для лучшей индексации и охвата аудитории‚ мы предлагаем следующие LSI запросы‚ которые отражают смежные темы и вопросы‚ интересные читателям нашей статьи:

| Масштабирование нейронных сетей | Стоимость обучения ИИ моделей | Энергоэффективность машинного обучения | Специализированное оборудование для ИИ | Доступность вычислительных ресурсов |

| Будущее аппаратного обеспечения ИИ | Оптимизация алгоритмов глубокого обучения | Экологический след ИИ | Распределенные вычисления в ML | Проблемы облачных платформ для ИИ |