- За кулисами генерации: Как мы выбираем лучшее среди архитектур искусственного интеллекта

- Что такое "качество генерации" и почему оно так важно для нас?

- Ключевые аспекты, которые мы учитываем при оценке качества

- Эволюция архитектур: От простых сетей к трансформерам, изменившим мир

- Ранние попытки: RNN и LSTM – первые шаги в последовательной генерации

- Революция Трансформеров: GPT, BERT и их потомки – новый горизонт возможностей

- Декодерные архитектуры (GPT-подобные): Мастера генерации

- Экосистема моделей: Open-source против проприетарных решений

- Наш практический опыт: Сравнительный анализ на реальных задачах

- Сравнение по задачам: Где какая архитектура проявляет себя лучше

- Генерация креативного контента (маркетинг, истории, посты для блога)

- Резюмирование и извлечение информации

- Написание кода и технической документации

- Факторы, влияющие на качество генерации (кроме архитектуры)

- Роль данных для обучения: Фундамент качества

- Промпт-инжиниринг: Искусство общения с ИИ

- Параметры генерации: Тонкая настройка креативности

- Человеческая валидация и пост-редактирование: Последний штрих

- Вызовы и перспективы: Куда движется мир генеративных моделей?

За кулисами генерации: Как мы выбираем лучшее среди архитектур искусственного интеллекта

Привет, дорогие читатели и коллеги по цеху! В последние годы мы все стали свидетелями невероятного прорыва в мире искусственного интеллекта, особенно в области генеративных моделей. Кажется, еще вчера мы удивлялись простеньким чат-ботам, а сегодня уже не представляем свою работу без помощников, способных писать статьи, создавать изображения, генерировать код и даже сочинять музыку. Но за всей этой магией стоит сложная и постоянно развивающаяся наука, и, как опытные блогеры, мы всегда стремимся не просто использовать эти инструменты, но и понимать, как они работают, чтобы выбирать самые эффективные для наших задач.

Наш блог – это не просто площадка для обмена мнениями, это целая лаборатория, где мы экспериментируем, тестируем и глубоко погружаемся в нюансы технологий. И одной из самых захватывающих тем для нас стало сравнение качества генерации различных архитектур. Ведь когда перед нами стоит задача создать что-то по-настоящему выдающееся, нам нужно знать, какой инструмент справится с ней лучше всего. Это не просто вопрос "что работает", это вопрос "что работает идеально" для конкретной цели, с учетом всех тонкостей и подводных камней.

Мы приглашаем вас в увлекательное путешествие по миру генеративных моделей, где мы поделимся своим личным опытом, наблюдениями и выводами. Мы расскажем, как мы оцениваем качество, какие архитектуры пробовали и почему сделали тот или иной выбор. Приготовьтесь к погружению в детали, ведь именно там скрывается ключ к пониманию того, как извлечь максимум пользы из этих удивительных технологий.

Что такое "качество генерации" и почему оно так важно для нас?

Прежде чем мы начнем сравнивать, нам нужно договориться о терминах. Что же мы подразумеваем под "качеством генерации", когда речь идет об искусственном интеллекте? На первый взгляд, это кажется довольно субъективным понятием. То, что одному покажется шедевром, другому может показаться посредственностью. Однако, когда мы работаем с ИИ на постоянной основе, нам необходим более системный подход, чтобы наши оценки были не только интуитивными, но и обоснованными.

Для нас, как для создателей контента, качество генерации – это многогранное понятие, охватывающее множество аспектов. Это не просто отсутствие ошибок, но и способность модели улавливать тончайшие нюансы, передавать нужный тон, адаптироваться к контексту и даже проявлять своего рода "креативность". Мы постоянно ищем ту золотую середину, которая позволяет нам экономить время, не жертвуя при этом оригинальностью и глубиной материала.

Ключевые аспекты, которые мы учитываем при оценке качества

В нашей "лаборатории" мы разработали свой собственный набор критериев, которые помогают нам объективно подходить к оценке результатов работы генеративных моделей. Мы обнаружили, что без этих ориентиров легко потеряться в потоке сгенерированного текста и не понять, что именно делает один результат лучше другого. Вот основные из них:

-

Когерентность и последовательность:

Сгенерированный текст должен быть логичным и связным. Мы проверяем, сохраняется ли тема, не появляются ли противоречия, и насколько плавно перетекают идеи из одного предложения в другое, из одного абзаца в другой. -

Беглость и грамматическая корректность:

Текст должен звучать естественно, без неестественных конструкций, грамматических, пунктуационных или орфографических ошибок. Для нас это базовый, но чрезвычайно важный критерий, ведь мы стремимся к идеальной русскоязычной речи. -

Релевантность и точность:

Сгенерированный контент должен точно соответствовать нашему запросу (промпту) и быть фактически верным, если речь идет об информационном тексте. Модель должна "понимать", о чем мы ее просим, и не отклоняться от темы. -

Креативность и оригинальность:

Это особенно важно для нашего блога. Мы не хотим получать шаблонные тексты. Мы ищем модели, способные генерировать свежие идеи, необычные формулировки и оригинальные подходы к изложению материала. -

Контекстуальное понимание:

Способность модели удерживать контекст на протяжении длинного текста или диалога. Если мы просим продолжить мысль, она должна "помнить" предыдущие предложения и абзацы, а не начинать с чистого листа. -

Отсутствие предвзятости и безопасность:

Мы всегда внимательно проверяем, чтобы сгенерированный контент не содержал предвзятых суждений, стереотипов или потенциально вредной информации. Это наш этический принцип. -

Эффективность и скорость генерации:

Хотя это и не напрямую о "качестве" самого текста, но скорость, с которой модель выдает результат, и ресурсоемкость процесса также влияют на наш выбор в реальных рабочих условиях.

Сочетание этих критериев позволяет нам не только оценить текущее качество, но и понять потенциал той или иной архитектуры для будущих задач. Это наш компас в океанах генеративного ИИ.

Эволюция архитектур: От простых сетей к трансформерам, изменившим мир

Чтобы по-нанастоящему оценить текущее качество генерации, нам необходимо оглянуться назад и понять, какой путь проделали нейронные сети. Мы помним времена, когда даже простейшая генерация текста казалась чудом, и видим, как далеко мы продвинулись. Эта эволюция – ключ к пониманию того, почему одни архитектуры превосходят другие в определенных аспектах.

Ранние попытки: RNN и LSTM – первые шаги в последовательной генерации

Наши первые эксперименты с генерацией текста начались задолго до нынешнего бума. Мы помним, как увлекались рекуррентными нейронными сетями (RNN) и их более продвинутыми версиями – сетями с долгой краткосрочной памятью (LSTM). Эти архитектуры были настоящими пионерами в обработке последовательных данных, таких как текст. Их способность "помнить" предыдущие слова в предложении позволила генерировать более связные последовательности, чем их предшественники.

Однако, как и у любой развивающейся технологии, у RNN и LSTM были свои ограничения, которые мы ощущали на собственном опыте. Основная проблема заключалась в их неспособности эффективно обрабатывать длинные зависимости. Чем длиннее был текст, тем сложнее модели было "помнить" информацию, сказанную в самом начале. Это приводило к тому, что сгенерированные абзацы часто теряли когерентность, а логика рассыпалась. Кроме того, последовательная природа их вычислений делала обучение медленным и затрудняла масштабирование до больших объемов данных. Мы видели, как они спотыкались на сложных текстах, требующих глубокого контекстуального понимания, и это подталкивало нас к поиску более совершенных решений.

Революция Трансформеров: GPT, BERT и их потомки – новый горизонт возможностей

Настоящая переломная точка наступила с появлением архитектуры Трансформеров. Мы помним, как в 2017 году вышла статья "Attention Is All You Need", и это было не просто научное открытие, это был настоящий взрыв, изменивший все. Трансформеры отказались от рекуррентности в пользу механизма внимания (attention mechanism), который позволил модели одновременно "видеть" все части входной последовательности, независимо от их положения. Это решило проблему длинных зависимостей и открыло дорогу для создания гораздо более мощных и объемных моделей.

На базе Трансформеров появились такие гиганты, как GPT (Generative Pre-trained Transformer) и BERT (Bidirectional Encoder Representations from Transformers), которые кардинально изменили ландшафт обработки естественного языка. Модели GPT, будучи декодерными архитектурами, превосходно справлялись с генерацией текста, создавая удивительно связные, грамматически корректные и даже творческие произведения. BERT, как кодерная архитектура, стал незаменимым для понимания текста, выделения сущностей и классификации. Для нас это означало, что теперь мы могли не просто генерировать текст, но и делать это с гораздо более высоким качеством, требуя меньшего количества доработок.

Декодерные архитектуры (GPT-подобные): Мастера генерации

Когда мы говорим о генерации текста, в первую очередь на ум приходят декодерные архитектуры, такие как различные версии GPT. Их сила заключается в способности предсказывать следующее слово на основе всех предыдущих слов в последовательности. Это позволяет им создавать текст, который не просто выглядит как человеческий, но и обладает логической структурой и смысловой глубиной. Мы использовали эти модели для написания черновиков статей, создания рекламных текстов, генерации идей для заголовков и даже для помощи в написании художественных рассказов. Их способность к "творчеству" и адаптации к различным стилям поражает.

Экосистема моделей: Open-source против проприетарных решений

Наш опыт включает работу как с проприетарными моделями (такими как ChatGPT от OpenAI), так и с постоянно растущим миром открытых моделей (например, Llama, Mistral, Falcon и многие другие). Каждый подход имеет свои преимущества и недостатки. Проприетарные модели часто предлагают невероятное качество "из коробки" и огромные вычислительные ресурсы, но при этом они менее гибки и имеют ограничения в использовании. Открытые модели, напротив, дают нам полный контроль, возможность тонкой настройки под наши специфические задачи и, конечно же, свободу экспериментов. Мы часто начинаем с тестирования нескольких open-source решений, чтобы найти наиболее подходящее и, при необходимости, дообучить его на наших данных, достигая уникального качества, недоступного в стандартных проприетарных продуктах.

Наш практический опыт: Сравнительный анализ на реальных задачах

Теория – это одно, а практика – совсем другое. Мы убедились в этом на собственном опыте, когда начали применять различные архитектуры к нашим повседневным задачам. Наша цель всегда была не просто заставить ИИ что-то генерировать, а получить результат, который по качеству максимально приближен к тому, что мог бы создать опытный человек. Для этого мы разработали строгие протоколы тестирования и внимательно фиксировали все детали.

Мы подходили к тестированию комплексно: брали несколько моделей с разными архитектурами (или разными размерами одной и той же архитектуры), задавали им одинаковые промпты и сравнивали выходные данные по нашим критериям. Иногда мы использовали внешние инструменты для оценки (например, метрики вроде BLEU или ROUGE для резюмирования), но чаще всего полагались на глубокий человеческий анализ, ведь именно человек является конечным потребителем нашего контента.

Сравнение по задачам: Где какая архитектура проявляет себя лучше

Мы обнаружили, что не существует универсальной "лучшей" архитектуры. Каждая проявляет свои сильные стороны в зависимости от конкретной задачи. Вот несколько примеров из нашей практики:

Генерация креативного контента (маркетинг, истории, посты для блога)

Для задач, требующих высокой степени креативности, оригинальности и способности к метафорам, мы наблюдали значительное превосходство больших декодерных Трансформеров. Например, когда нам нужно было сгенерировать несколько вариантов рекламного слогана для нового продукта или придумать необычный сюжет для короткой истории, разница была очевидна. Модели, основанные на архитектурах, подобных GPT-3.5 или Llama-2 (70B), демонстрировали гораздо большую изобретательность и языковую гибкость, чем их меньшие или устаревшие аналоги.

Пример 1: Сравнение модели X (старая LSTM) и Y (современный Трансформер) для генерации рекламного слогана

| Критерий | Модель X (LSTM-based) | Модель Y (Transformer-based, 70B) |

|---|---|---|

| Оригинальность | "Наш продукт лучший для вас!" (Шаблонно, банально) | "Откройте мир безграничных возможностей: преобразите свой день с [Название Продукта]." (Свежо, интригующе) |

| Эмоциональный отклик | Нейтрально, информативно. | Вызывает интерес, чувство предвкушения. |

| Лингвистическая сложность | Простые предложения, ограниченный словарный запас. | Богатый словарный запас, сложные синтаксические конструкции. |

| Контекстуальное соответствие | Иногда теряет связь с общим описанием продукта. | Идеально вписывается в общую маркетинговую стратегию. |

Как видно из таблицы, разница была колоссальной. Там, где старые модели выдавали общие фразы, Трансформеры предлагали глубокие, продающие тексты, которые требовали минимальной доработки.

Резюмирование и извлечение информации

Для задач, связанных с компрессией больших объемов текста и извлечением ключевых фактов, мы также отдали предпочтение Трансформерам, но уже с акцентом на их способность обрабатывать длинные контексты. Модели, такие как T5 или специализированные версии GPT, обученные на резюмировании, показывают себя превосходно. Они могут не только точно передать суть, но и сделать это в сжатой, легко читаемой форме, сохраняя при этом все важные детали.

Пример 2: Сравнение модели A (меньший Трансформер) и B (большой Трансформер с длинным контекстом) для резюмирования научной статьи

- Модель A (меньший Трансформер): Выдала краткое резюме, но упустила несколько ключевых методологических деталей, важных для понимания исследования. Текст был связным, но неполным.

- Модель B (большой Трансформер с длинным контекстом): Создала исчерпывающее резюме, точно передав основную идею, методы, результаты и выводы, не упустив ни одной важной детали. Объем резюме был чуть больше, но информативность несравнимо выше.

Здесь мы увидели, что размер контекстного окна и общая "глубина" понимания модели играют решающую роль. Чем больше информации модель может одновременно "видеть" и обрабатывать, тем более точным и полным будет ее резюме.

Написание кода и технической документации

В этой области мы особенно ценим точность, логичность и соответствие синтаксису. Мы тестировали специализированные модели, такие как Code Llama, а также общие Трансформеры, обученные на большом объеме кода. Мы обнаружили, что для генерации кода важны не только архитектура, но и специфические данные, на которых она была дообучена. Модели, прошедшие обучение на огромных репозиториях кода, способны не только генерировать фрагменты, но и объяснять их, находить ошибки и предлагать оптимизации.

Мы часто используем ИИ для генерации boilerplate-кода, написания функций на основе описания или даже для помощи в отладке. Качество здесь напрямую зависит от способности модели "понимать" логику программирования и синтаксис языка. И снова, более крупные и специализированные Трансформеры демонстрируют превосходство, генерируя рабочий, чистый и эффективный код.

"Единственный способ делать великую работу – это любить то, что ты делаешь. Если ты еще не нашел этого, продолжай искать. Не останавливайся. Как и со всеми сердечными делами, ты узнаешь, когда найдешь это."

Эта цитата Стива Джобса очень точно отражает наш подход к работе с ИИ. Мы не просто используем инструменты, мы ищем те, которые по-настоящему "любят" свою работу, то есть, выполняют ее с максимальным качеством и отдачей. И когда мы находим такую архитектуру, такое решение, мы видим, как наша работа преображается.

Факторы, влияющие на качество генерации (кроме архитектуры)

Наш опыт показал, что одна только архитектура, какой бы передовой она ни была, не гарантирует идеального результата. Есть целый ряд других, не менее важных факторов, которые в совокупности определяют конечное качество генерации. Игнорировать их – значит упускать огромные возможности для улучшения работы с ИИ.

Роль данных для обучения: Фундамент качества

Мы всегда говорим, что "мусор на входе – мусор на выходе". И это правило абсолютно справедливо для генеративных моделей. Качество и объем данных, на которых обучалась модель, играют колоссальную роль. Если модель обучалась на низкокачественном, предвзятом или нерелевантном корпусе текстов, то и ее генерации будут страдать от тех же недостатков. Мы видели, как модели, обученные на специфических, чистых и хорошо структурированных данных (например, на юридических документах или медицинских статьях), демонстрировали невероятную точность и релевантность в своих областях, в то время как общие модели могли "плавать" в терминологии.

Именно поэтому мы так ценим возможность дообучения открытых моделей на наших собственных данных. Это позволяет нам "вдохнуть" в модель специфику нашего стиля, наших тем и нашей терминологии, делая ее незаменимым инструментом для создания по-настоящему уникального и высококачественного контента.

Промпт-инжиниринг: Искусство общения с ИИ

Даже самая мощная архитектура будет бесполезна, если мы не умеем правильно с ней общаться. Промпт-инжиниринг – это не просто набор команд, это целое искусство формулирования запросов таким образом, чтобы модель максимально точно поняла нашу задачу и выдала желаемый результат. Мы потратили бесчисленные часы на эксперименты с промптами, и можем с уверенностью сказать: хорошо составленный промпт может изменить все.

Вот несколько наших ключевых наблюдений:

- Будьте конкретны: Чем точнее вы опишете задачу, тем лучше будет результат. Избегайте двусмысленности.

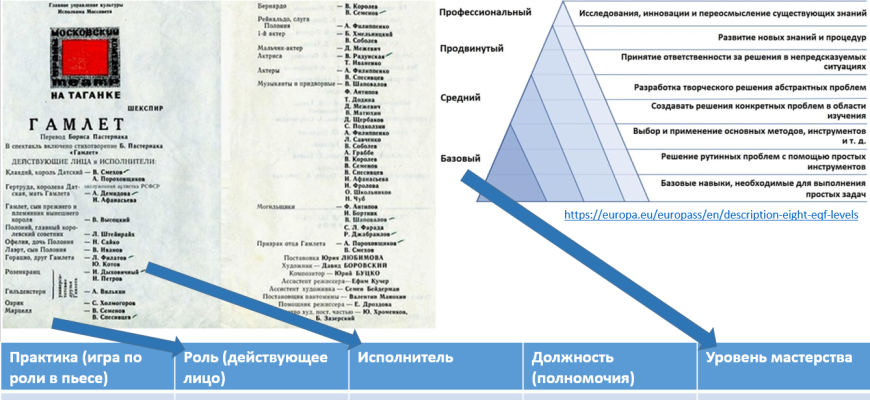

- Задавайте роль: Просите модель представить себя в определенной роли (например, "Ты опытный маркетолог…", "Ты академический писатель…"). Это помогает ей адаптировать стиль и тон.

- Предоставляйте примеры (few-shot learning): Если у вас есть примеры желаемого вывода, покажите их модели. Это значительно улучшает качество.

- Используйте негативные промпты: Указывайте, чего не нужно делать (например, "Избегай клише…", "Не используй слишком сложные предложения…").

Овладение промпт-инжинирингом – это, по сути, овладение новой формой коммуникации, которая позволяет нам раскрыть весь потенциал генеративных архитектур.

Параметры генерации: Тонкая настройка креативности

При работе с генеративными моделями мы также активно используем различные параметры генерации, которые позволяют нам тонко настраивать характер выходного текста. Самые распространенные из них:

-

Температура (Temperature):

Этот параметр контролирует "случайность" или "креативность" генерации. Низкая температура (близко к 0) делает текст более предсказуемым и консервативным, основываясь на наиболее вероятных словах. Высокая температура (например, 0.8-1.0) увеличивает разнообразие и оригинальность, но может привести к менее связным или даже бессмысленным результатам. Мы часто экспериментируем с температурой, чтобы найти идеальный баланс между креативностью и когерентностью. -

Top-p (Nucleus Sampling):

Вместо того чтобы выбирать из всех возможных слов, Top-p отбирает слова, сумма вероятностей которых достигает определенного порога (p). Это позволяет отсечь слова с очень низкой вероятностью, сохраняя при этом разнообразие. Мы находим этот параметр очень полезным для поддержания качества при одновременном поощрении креативности. -

Top-k:

Ограничивает выбор следующего слова только k наиболее вероятными вариантами. Похож на Top-p, но более жестко контролирует разнообразие.

Варьируя эти параметры, мы можем адаптировать поведение модели под конкретную задачу: для технической документации мы выберем низкую температуру, чтобы обеспечить точность, а для написания креативной истории – более высокую, чтобы стимулировать воображение.

Человеческая валидация и пост-редактирование: Последний штрих

И, наконец, самый важный фактор – это человек. Какой бы совершенной ни была архитектура и как бы грамотно мы ни составили промпт, окончательное слово всегда остается за нами. Мы не рассматриваем ИИ как замену человеку, а скорее как мощный инструмент, который многократно увеличивает наши возможности. Генерация текста – это лишь первый этап. Дальше следует тщательная человеческая валидация, редактирование, доработка и придание тексту того самого "человеческого" оттенка, который делает его по-настоящему живым и привлекательным.

Мы используем ИИ для ускорения работы, автоматизации рутинных задач и вдохновения, но финальное качество всегда достигается благодаря нашему опыту, критическому мышлению и творческому подходу. Это симбиоз, где сильные стороны машины дополняют сильные стороны человека.

Вызовы и перспективы: Куда движется мир генеративных моделей?

Наш путь в мире генеративного ИИ – это постоянное движение вперед. Мы видим, как технологии развиваются с головокружительной скоростью, и каждый день приносит новые открытия. Однако вместе с невероятными возможностями появляются и серьезные вызовы, о которых мы, как ответственные пользователи и блогеры, не можем молчать.

Одним из самых острых вопросов является этика использования ИИ. Мы постоянно сталкиваемся с проблемами предвзятости в данных, что может приводить к дискриминационным или несправедливым результатам генерации. Мы осознаем свою ответственность за то, чтобы наш контент был не только качественным, но и этичным, безопасным и не вводящим в заблуждение. Вопросы авторского права, дезинформации и глубоких фейков становятся все более актуальными, и нам, как сообществу, предстоит найти эффективные решения.

Еще одна перспектива, которая нас по-настоящему захватывает, – это мультимодальные модели. Уже сейчас мы видим, как ИИ начинает не только генерировать текст, но и создавать изображения, видео, аудио, и даже трехмерные модели на основе текстовых описаний. Это открывает совершенно новые горизонты для создателей контента. Представьте: вы описываете идею для статьи, и ИИ не только пишет текст, но и подбирает иллюстрации, создает инфографику и даже генерирует фоновую музыку для вашего видео. Это будущее уже не за горами, и мы активно следим за этими разработками, чтобы быть на переднем крае инноваций.

Мы также видим, как постепенно исчезает граница между "пониманием" и "генерацией". Новые архитектуры становятся все более способными к сложному рассуждению, решению задач и даже обучению "на лету" (in-context learning). Это приближает нас к тому, что когда-то казалось фантастикой – к созданию "истинного" общего искусственного интеллекта (AGI). Хотя до этого еще далеко, каждый новый прорыв в качестве генерации – это еще один шаг к этой амбициозной цели.

Итак, после всех наших экспериментов, сравнений и глубоких погружений в мир генеративных архитектур, какой вывод мы можем сделать? Главное, что мы усвоили: не существует одной универсальной "лучшей" архитектуры. Каждая из них обладает своими уникальными сильными сторонами и оптимально подходит для определенных задач. Наш подход заключается в том, чтобы понимать эти нюансы и выбирать инструмент, максимально соответствующий нашим текущим потребностям.

Мы пришли к убеждению, что будущее за гибкостью и адаптацией. Это означает не только выбор правильной архитектуры, но и умение эффективно использовать промпт-инжиниринг, тонко настраивать параметры генерации и, самое главное, всегда применять человеческое суждение и творческий подход для финальной доработки. Искусственный интеллект – это наш партнер, а не наш заменитель.

Мы продолжим наши эксперименты, будем следить за новыми архитектурами и делиться нашим опытом с вами. Ведь именно в постоянном поиске, обучении и адаптации кроется секрет успеха в быстро меняющемся мире технологий. Надеемся, что наш опыт поможет и вам сделать осознанный выбор в вашем путешествии по миру генеративного ИИ. До новых встреч на страницах нашего блога!

Подробнее: LSI Запросы

| Оценка качества текста ИИ | Сравнение LLM архитектур | Промпт-инжиниринг для генерации | GPT vs Llama качество | Как выбрать генеративную модель |

| Преимущества Transformer моделей | Параметры генерации нейросетей | Этика в генеративном ИИ | Мультимодальные генеративные модели | Будущее генерации контента ИИ |