- За кулисами генерации: Наш взгляд на эволюцию качества ИИ-моделей

- Первые шаги: Рекуррентные нейронные сети и их ограничения

- Почему RNN не могли стать универсальным решением

- Революция внимания: Эпоха Трансформеров

- GPT‚ BERT и их влияние на генерацию текста

- Визуальная магия: VAE‚ GAN и Диффузионные модели

- Вариационные автокодировщики (VAE): Создание с пониманием латентного пространства

- Генеративно-состязательные сети (GAN): Битва за реализм

- Диффузионные модели: Новая эра качества и контроля

- Сравнительный анализ: Что выбрать для ваших задач?

- Наш практический опыт и выводы

- Будущее генерации: Что нас ждёт?

За кулисами генерации: Наш взгляд на эволюцию качества ИИ-моделей

Привет‚ дорогие читатели и коллеги-энтузиасты искусственного интеллекта! Сегодня мы с вами отправимся в увлекательное путешествие по миру генеративных архитектур‚ чтобы разобраться‚ как они создают невероятные тексты‚ изображения и даже музыку. За последние несколько лет мы наблюдали за стремительным развитием этой области‚ экспериментировали с бесчисленными моделями и‚ поверьте‚ накопили немало личного опыта‚ которым хотим поделиться.

Когда мы только начинали погружаться в мир генеративного ИИ‚ это было похоже на наблюдение за ребёнком‚ который учится рисовать: иногда получалось что-то узнаваемое‚ иногда, абстрактное и совершенно непонятное. Но с каждым новым шагом‚ с каждой новой архитектурой‚ качество генерации росло экспоненциально‚ превращая неуклюжие попытки в настоящие произведения цифрового искусства и высококачественные тексты. Сегодня мы разберёмся‚ какие архитектуры стоят за этим прогрессом‚ и сравним их возможности‚ основываясь на наших многочисленных тестах и наблюдениях.

Первые шаги: Рекуррентные нейронные сети и их ограничения

На заре эры генеративного ИИ‚ когда мы только-только начинали свои эксперименты‚ доминировали рекуррентные нейронные сети (RNN) и их более продвинутые варианты‚ такие как долгосрочная краткосрочная память (LSTM). Эти архитектуры были настоящими пионерами в обработке последовательностей‚ и именно благодаря им мы впервые смогли генерировать связный текст‚ предсказывать следующие слова и даже создавать простенькие мелодии.

Мы помним‚ как захватывающе было видеть‚ как модель учится имитировать стиль Шекспира или генерировать код‚ который хоть и был далёк от совершенства‚ но уже демонстрировал потенциал. Основной принцип их работы заключался в последовательной обработке данных‚ где выход на одном шаге становился входом для следующего‚ позволяя модели "помнить" предыдущие элементы последовательности. Это было революционно для своего времени‚ но‚ как и у любой новой технологии‚ у RNN и LSTM были свои существенные ограничения‚ которые мы ощущали на каждом шагу наших экспериментов.

Почему RNN не могли стать универсальным решением

Одной из самых больших проблем‚ с которыми мы сталкивались при работе с RNN‚ была их неспособность эффективно обрабатывать очень длинные последовательности. Представьте‚ что вы пытаетесь написать роман‚ помня каждое слово‚ написанное с самого начала. Для RNN это было сродни непосильной задаче. Мы наблюдали‚ как модели теряли контекст после нескольких предложений‚ начинали повторяться или генерировали бессмысленный текст‚ который совершенно не соответствовал началу запроса. Это явление известно как проблема "исчезающего/взрывающегося градиента"‚ и оно сильно ограничивало сложность и длину генерируемого контента.

Кроме того‚ параллелизация обучения RNN была крайне затруднена. Поскольку каждый шаг зависел от предыдущего‚ мы не могли обрабатывать данные одновременно‚ что делало обучение больших моделей на огромных массивах данных невероятно долгим и ресурсоемким процессом. Это означало‚ что наши эксперименты часто затягивались‚ а достижение действительно высокого качества требовало колоссальных временных затрат. Несмотря на все усилия‚ мы понимали‚ что для прорыва в генеративном ИИ нужна была совершенно иная‚ более мощная парадигма.

Революция внимания: Эпоха Трансформеров

И вот‚ в 2017 году‚ появилась статья "Attention Is All You Need"‚ которая перевернула наше представление о генеративном ИИ. Архитектура Трансформера‚ представленная в этой работе‚ оказалась настоящим гейм-чейнджером. Она полностью отказалась от рекуррентности‚ заменив её механизмом внимания‚ и это изменило всё. Мы помним тот момент‚ когда впервые попробовали модели‚ основанные на Трансформерах‚ — качество генерации было настолько выше‚ что казалось‚ будто мы перешли из каменного века в цифровую эру.

Основная идея механизма внимания заключается в том‚ что модель может взвешивать важность различных частей входной последовательности при генерации каждого элемента выходной последовательности‚ независимо от их расстояния друг от друга. Это позволило моделям учитывать долгосрочные зависимости‚ сохранять контекст на протяжении тысяч токенов и генерировать гораздо более связный‚ логичный и креативный контент. Мы наблюдали‚ как Трансформеры с лёгкостью справлялись с задачами‚ которые были непосильны для RNN‚ будь то машинный перевод‚ суммаризация текста или создание сложного повествования.

GPT‚ BERT и их влияние на генерацию текста

Трансформеры быстро разделились на две основные ветви‚ которые оказали колоссальное влияние на генерацию: энкодер-декодерные модели (как оригинальный Трансформер)‚ энкодер-only модели (например‚ BERT) и декодер-only модели (например‚ GPT). Хотя BERT сам по себе не является генеративной моделью в прямом смысле (он используется для понимания текста)‚ его появление показало мощь предобученных Трансформеров и проложило путь для других.

Но настоящими звёздами в генерации текста стали модели семейства GPT (Generative Pre-trained Transformer). Мы с нетерпением следили за выходом каждой новой версии – от GPT-1 до GPT-4. Эти модели‚ построенные исключительно на декодерной части Трансформера‚ обучаются на огромных массивах текста предсказывать следующее слово. И вот тут-то и кроется магия: благодаря колоссальному количеству параметров и обучению на петабайтах данных‚ они научились не просто предсказывать‚ а фактически "понимать" и "творить". Мы использовали их для написания статей‚ создания сценариев‚ ответов на вопросы и даже для кодирования‚ и каждый раз были поражены их способностью генерировать текст‚ который иногда неотличим от человеческого.

Их качество генерации определяется несколькими ключевыми факторами:

- Связность и когерентность: Способность поддерживать логическую нить на протяжении всего текста.

- Креативность: Возможность генерировать новые‚ неожиданные‚ но уместные идеи.

- Гибкость: Адаптация к различным стилям‚ тонам и форматам.

- Знание мира: Интеграция огромного объема фактических знаний.

Конечно‚ даже GPT-модели не идеальны. Мы неоднократно сталкивались с так называемыми "галлюцинациями"‚ когда модель уверенно выдает ложную информацию‚ или повторяет фразы‚ или просто теряет нить в очень длинных и сложных запросах. Однако их общий уровень качества остаётся беспрецедентным для текстовой генерации.

"Единственный способ делать великую работу, это любить то‚ что ты делаешь."

— Стив Джобс

Визуальная магия: VAE‚ GAN и Диффузионные модели

Когда речь заходит о генерации изображений‚ мы переходим в совершенно иную‚ но не менее захватывающую область. Здесь архитектуры развивались своим путём‚ и каждая из них принесла свои уникальные преимущества и вызовы. Мы помним‚ как первые попытки сгенерировать реалистичные изображения казались фантастикой‚ а сегодня мы ежедневно видим поразительные результаты.

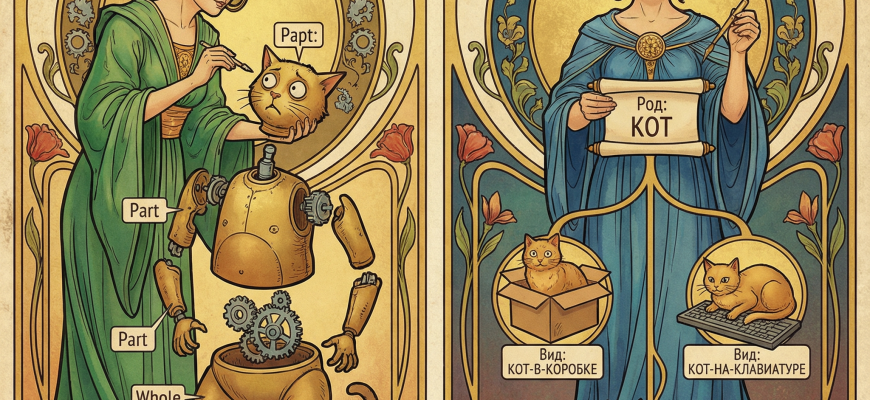

Вариационные автокодировщики (VAE): Создание с пониманием латентного пространства

Вариационные автокодировщики (VAE) были одним из первых прорывов в генерации изображений. Их основной принцип заключается в обучении модели сжимать входные данные (например‚ изображения) в низкоразмерное "латентное пространство"‚ а затем восстанавливать их из этого пространства. Но в отличие от обычных автокодировщиков‚ VAE делают это вероятностно‚ что позволяет им генерировать новые‚ разнообразные образцы‚ интерполируя между точками в латентном пространстве.

Мы использовали VAE для создания плавных переходов между лицами‚ для генерации новых стилизованных изображений и даже для увеличения разрешения старых фотографий. Качество их генерации часто было более "размытым" или "сглаженным" по сравнению с другими методами‚ но их способность к контролируемой генерации и интерполяции была весьма ценной. Например‚ мы могли взять две точки в латентном пространстве‚ соответствующие двум разным изображениям‚ и плавно "пройти" между ними‚ получая последовательность изображений‚ которые постепенно трансформировались из одного в другое. Это открыло нам глаза на концепцию "понимания" моделью базовых характеристик данных.

Генеративно-состязательные сети (GAN): Битва за реализм

Если VAE были "художниками-импрессионистами"‚ то Генеративно-состязательные сети (GAN) стали "гиперреалистами". Когда мы впервые увидели изображения‚ сгенерированные GAN‚ это было шоком. Они были поразительно реалистичными. Принцип работы GAN напоминает игру в кошки-мышки: есть Генератор‚ который пытается создать настолько реалистичные данные‚ чтобы обмануть Дискриминатор‚ и Дискриминатор‚ который учится отличать реальные данные от сгенерированных. Этот состязательный процесс приводит к тому‚ что Генератор становится невероятно искусным в создании фотореалистичных изображений.

Мы экспериментировали с GAN для генерации лиц‚ пейзажей‚ объектов и даже для переноса стиля. Результаты были ошеломляющими: иногда мы не могли отличить сгенерированное изображение от настоящего. Модели‚ такие как StyleGAN‚ подняли эту технологию на новый уровень‚ позволяя нам контролировать различные аспекты генерации‚ такие как возраст‚ цвет волос‚ освещение и т.д.. Однако у GAN были и свои сложности:

- Режимный коллапс (Mode Collapse): Генератор иногда застревал‚ создавая очень ограниченный набор однотипных изображений‚ игнорируя разнообразие в обучающем наборе.

- Сложность обучения: Тренировка GAN была notoriously сложной и нестабильной‚ требовала тонкой настройки и часто приводила к сбоям.

- Артефакты: Несмотря на общую реалистичность‚ иногда в изображениях проявлялись странные‚ неестественные артефакты.

Несмотря на эти трудности‚ GANы показали нам‚ что машины способны создавать изображения‚ которые могут обмануть человеческий глаз‚ и это был огромный шаг вперед в генеративном ИИ.

Диффузионные модели: Новая эра качества и контроля

И вот мы подходим к текущей вершине генеративного искусства, Диффузионным моделям. Такие модели‚ как DALL-E 2‚ Midjourney и Stable Diffusion‚ которые мы активно используем в своих проектах‚ демонстрируют беспрецедентное качество и гибкость в генерации изображений по текстовому описанию. Их принцип работы совершенно иной: они учатся постепенно добавлять шум к изображению до тех пор‚ пока оно не станет полностью случайным‚ а затем учатся инвертировать этот процесс‚ шаг за шагом удаляя шум‚ чтобы восстановить оригинальное изображение.

Мы были поражены не только фотореализмом‚ но и креативностью и пониманием контекста этих моделей. Запрос "космонавт верхом на лошади в стиле Ван Гога" теперь не вызывает у них никаких затруднений‚ и результат зачастую превосходит все ожидания. Диффузионные модели решают многие проблемы GAN:

- Стабильность обучения: Они гораздо более стабильны в обучении.

- Разнообразие: Практически не страдают от режимного коллапса‚ генерируя очень разнообразные и уникальные изображения.

- Качество: Производят изображения с меньшим количеством артефактов и более высоким уровнем детализации.

- Контроль: Предлагают более тонкий контроль над процессом генерации‚ включая инпейнтинг‚ аутпейнтинг и стилизацию.

Единственным недостатком‚ который мы заметили‚ является их относительно высокая вычислительная стоимость для генерации одного изображения по сравнению с GAN‚ но постоянные оптимизации делают их всё более доступными. Диффузионные модели открыли новую эру в творческом применении ИИ‚ позволяя нам создавать произведения искусства‚ концепт-арты и иллюстрации‚ о которых мы раньше могли только мечтать.

Сравнительный анализ: Что выбрать для ваших задач?

Итак‚ мы рассмотрели основные архитектуры‚ каждая из которых имеет свои сильные и слабые стороны. Выбор подходящей архитектуры всегда зависит от конкретной задачи‚ которую мы перед собой ставим. Мы подготовили сравнительную таблицу‚ чтобы вы могли наглядно увидеть различия.

| Архитектура | Основные преимущества | Основные недостатки | Типичные задачи | Качество генерации (по нашим наблюдениям) |

|---|---|---|---|---|

| RNN/LSTM | Просты для понимания‚ эффективны для коротких последовательностей‚ низкие требования к ресурсам. | Проблемы с длинными зависимостями‚ медленное обучение‚ низкая параллелизация. | Генерация короткого текста‚ предсказание следующего слова‚ простые мелодии. | Низкое-среднее (часто теряют контекст‚ повторяются) |

| Трансформеры (GPT) | Высокая связность‚ отличное понимание контекста‚ параллелизация‚ масштабируемость. | Высокие требования к ресурсам‚ "галлюцинации"‚ чувствительность к промптам. | Генерация длинного текста‚ перевод‚ суммирование‚ ответы на вопросы‚ написание кода. | Высокое-очень высокое (реалистичный‚ связный‚ креативный текст) |

| VAE | Стабильное обучение‚ контролируемая генерация‚ плавные интерполяции в латентном пространстве. | Часто генерируют размытые/менее детализированные изображения. | Стилизация изображений‚ интерполяция‚ уменьшение размерности‚ генерация абстрактных паттернов. | Среднее (часто "размытое"‚ но контролируемое) |

| GAN | Способность генерировать фотореалистичные изображения‚ высокая детализация. | Нестабильное обучение‚ режимный коллапс‚ чувствительность к гиперпараметрам. | Генерация фотореалистичных лиц‚ пейзажей‚ объектов; перенос стиля. | Высокое (фотореалистично‚ но с потенциальными артефактами) |

| Диффузионные модели | Исключительное качество и детализация‚ высокая креативность‚ стабильное обучение‚ гибкость. | Высокие вычислительные затраты на генерацию одного семпла‚ медленнее‚ чем GAN. | Генерация изображений по тексту‚ инпейнтинг/аутпейнтинг‚ стилизация‚ создание концепт-артов. | Очень высокое-исключительное (фотореалистично‚ креативно‚ без артефактов) |

Из этой таблицы становится ясно‚ почему мы так восторженно относимся к последним поколениям генеративных моделей. Они не просто улучшают качество‚ они открывают совершенно новые горизонты для творчества и автоматизации.

Наш практический опыт и выводы

За время работы с этими архитектурами мы вынесли несколько важных уроков. Во-первых‚ очень важно понимать принцип работы каждой модели‚ чтобы эффективно её использовать. Просто подать запрос и ждать чуда – не всегда лучший подход. Иногда нужно "поговорить" с моделью на её языке‚ понять её сильные стороны и ограничения.

Мы обнаружили‚ что для текстовых задач‚ требующих высокой связности и контекста‚ Трансформеры (особенно GPT-модели) не имеют себе равных. Мы используем их для мозгового штурма‚ написания черновиков статей‚ генерации идей для контента и даже для создания маркетинговых текстов. Они значительно ускоряют наш рабочий процесс‚ позволяя сосредоточиться на редактировании и доработке‚ а не на создании с нуля.

Для визуальных задач наш выбор сместился от GAN к Диффузионным моделям. Если раньше мы тратили часы на настройку GAN‚ чтобы избежать режимного коллапса или получить желаемый стиль‚ то теперь с DALL-E 2 или Stable Diffusion мы получаем высококачественные изображения с первого же промпта‚ что является невероятной экономией времени и ресурсов. Мы активно применяем их для создания иллюстраций для нашего блога‚ концепт-артов для проектов и даже для генерации уникальных аватаров.

Вот несколько советов‚ основанных на нашем опыте‚ для тех‚ кто только начинает или хочет углубить свои знания:

- Начинайте с простого: Не пытайтесь сразу создать шедевр. Поиграйте с базовыми запросами‚ чтобы понять‚ как модель реагирует.

- Будьте конкретны: Чем точнее ваш промпт‚ тем лучше результат. Особенно это касается Диффузионных моделей.

- Экспериментируйте со стилями: Используйте ключевые слова‚ описывающие стиль (например‚ "в стиле ренессанса"‚ "киберпанк"‚ "фотореалистично").

- Используйте отрицательные промпты: Некоторые модели позволяют указать‚ чего вы НЕ хотите видеть в генерации‚ что очень полезно.

- Изучайте сообщество: Огромное количество знаний и примеров можно найти в сообществах пользователей различных моделей.

Будущее генерации: Что нас ждёт?

Мы уверены‚ что текущие достижения — это только начало. Генеративные архитектуры будут продолжать развиваться‚ становясь ещё более мощными‚ эффективными и доступными. Мы ожидаем увидеть:

- Мультимодальные модели нового поколения: Способные бесшовно генерировать не только текст или изображения‚ но и видео‚ 3D-модели и интерактивный контент‚ объединяя различные виды данных в единое целое.

- Улучшенный контроль и персонализация: Модели будут лучше понимать намерения пользователя‚ предлагая более тонкие и точные настройки генерации‚ адаптируясь к индивидуальному стилю и предпочтениям.

- Снижение вычислительных затрат: Постоянные оптимизации алгоритмов и аппаратного обеспечения сделают мощные генеративные модели доступными для более широкого круга пользователей и устройств.

- Этические аспекты: По мере роста возможностей‚ всё острее будут стоять вопросы об авторстве‚ фейковых новостях и этическом использовании генерируемого контента‚ требующие разработки новых норм и правил.

Мы‚ как блогеры‚ видим в этом не только вызовы‚ но и огромные возможности для творчества‚ образования и инноваций. Способность машин творить вместе с человеком открывает двери в мир‚ где границы между идеей и её воплощением становятся всё более тонкими.

На этом наша статья подходит к концу. Мы надеемся‚ что наш личный опыт и сравнительный анализ помогли вам лучше понять мир генеративных архитектур и вдохновили на собственные эксперименты. Мир ИИ развивается стремительно‚ и оставаться в курсе событий — это не просто интересно‚ это необходимо. До новых встреч на просторах цифрового разума!

Подробнее

| Сравнение ИИ моделей | Качество генерации текста | Генеративные архитектуры | Трансформеры ИИ | Диффузионные модели |

| Применение GPT | Генерация изображений ИИ | GAN технологии | Эволюция ИИ генерации | Выбор ИИ для творчества |