- Затерянные в лабиринте генерации: Как мы ищем выход к воспроизводимости результатов

- Что такое воспроизводимость в контексте генерации и почему она так важна?

- Основные причины неуловимости результатов генерации

- Вездесущая роль случайности: от семян до потоков

- Несоответствие вычислительной среды: не только "работает на моей машине"

- Зависимости от данных: невидимая рука, формирующая генерацию

- Сложность моделей и алгоритмов: не все пути ведут в Рим

- Трудности оценки: субъективность в мире чисел

- Наш путь к воспроизводимости: личный опыт и уроки

- Практические стратегии для достижения воспроизводимости

- Строгий контроль версий всего: код, данные, окружение

- Тотальное управление случайностью: никаких сюрпризов

- Изоляция окружения: контейнеры и виртуальные машины

- Системы логирования и отслеживания экспериментов

- Стандартизация и документирование

- Инструменты и технологии, которые нам помогают

- Инструменты для отслеживания экспериментов

- Инструменты для контейнеризации

- Инструменты для версионирования данных

- Будущее воспроизводимой генерации: к стандарту индустрии

Затерянные в лабиринте генерации: Как мы ищем выход к воспроизводимости результатов

Приветствуем вас, дорогие читатели, в нашем блоге! Сегодня мы хотим поговорить о теме, которая, без преувеличения, не дает нам спать по ночам, когда мы погружаемся в мир искусственного интеллекта и машинного обучения. Это проблема воспроизводимости результатов генерации. Мы все, кто хоть раз пытался повторить чужой эксперимент или даже свой собственный спустя некоторое время, сталкивались с этим вызовом. Казалось бы, мы имеем дело с кодом, с детерминированными алгоритмами, но почему же так часто одно и то же действие приводит к разным, иногда кардинально отличающимся результатам?

Мы помним, как в начале нашего пути в сфере AI, каждый новый результат был источником восторга. Но затем приходило осознание: если мы не можем его воспроизвести, ценность этого результата значительно снижается. Ведь наука и инженерия строятся на возможности подтвердить выводы, повторить эксперименты и проверить гипотезы. В контексте генеративных моделей, будь то текст, изображения, аудио или что-то иное, эта проблема приобретает особую остроту. Мы генерируем не просто числа, а сложные, часто субъективно оцениваемые сущности, и малейшее отклонение может полностью изменить восприятие.

В этой статье мы хотим поделиться нашим опытом, наблюдениями и, самое главное, стратегиями, которые мы выработали, чтобы хоть как-то совладать с этой непредсказуемой стихией. Мы пройдемся по основным причинам, почему результаты генерации могут быть такими неуловимыми, и предложим практические подходы, которые, мы надеемся, помогут и вам на вашем пути. Приготовьтесь к глубокому погружению в мир байтов, алгоритмов и, конечно же, наших собственных проб и ошибок.

Что такое воспроизводимость в контексте генерации и почему она так важна?

Прежде чем углубляться в дебри проблем, давайте четко определим, что же мы подразумеваем под воспроизводимостью. В общих чертах, воспроизводимость – это способность получить те же результаты, используя тот же код, те же данные и те же вычислительные ресурсы. В идеальном мире, если мы запустим наш генератор изображений с одними и теми же входными параметрами, мы должны получить идентичное изображение каждый раз. Если мы тренируем генеративную языковую модель и достигаем определенной метрики качества, мы должны иметь возможность повторить этот процесс и получить схожие или идентичные метрики, а также способность генерировать текст схожего качества и стиля.

Однако, как мы уже намекали, этот "идеальный мир" зачастую остается лишь мечтой. В контексте генеративных моделей, это становится еще сложнее. Ведь иногда мы говорим не только о точном совпадении байтов выходного файла, но и о качественной воспроизводимости – способности получить результат, который по своим характеристикам (стиль, связность, креативность) находится в том же диапазоне, что и изначально полученный. Мы не всегда ищем пиксель-в-пиксель идентичность, но ожидаем предсказуемого поведения и качества.

Почему же это так важно? Воспроизводимость – это краеугольный камень научного метода. Без нее мы не можем строить знания, проверять гипотезы, сравнивать модели или даже доверять собственным выводам. Если мы не можем воспроизвести результат, мы не можем быть уверены, что он не был случайностью, ошибкой или артефактом конкретной вычислительной среды. Для нас, блогеров и практиков, это означает, что мы не можем с уверенностью рекомендовать какую-либо технику или модель, если мы сами не можем гарантировать ее стабильную работу. Это подрывает доверие и замедляет прогресс всей области.

Мы часто видим, как в статьях и репозиториях гордо демонстрируются потрясающие результаты генерации. Мы, вдохновленные, пытаемся повторить их, но сталкиваемся с тем, что наш собственный генератор выдает нечто совершенно иное. Это не только разочаровывает, но и отнимает огромное количество времени и ресурсов, которые можно было бы потратить на более продуктивные задачи. Поэтому для нас борьба за воспроизводимость – это не просто академический интерес, а практическая необходимость для эффективной работы и создания надежных систем.

Основные причины неуловимости результатов генерации

После того как мы определились с важностью воспроизводимости, давайте разберемся, почему же она так часто ускользает от нас. Мы выявили несколько ключевых факторов, которые вносят наибольший вклад в эту проблему. Часто это не одна причина, а их сложная комбинация, создающая настоящий клубок трудностей.

Наш опыт показывает, что эти факторы могут быть как чисто техническими, так и методологическими, и каждый из них требует особого внимания и подхода. Мы часто начинаем с наиболее очевидных гипотез, но затем обнаруживаем, что истинная причина скрывается гораздо глубже, в самых неожиданных местах нашей вычислительной инфраструктуры или даже в тонкостях используемых нами алгоритмов.

Вездесущая роль случайности: от семян до потоков

Одной из самых частых и коварных причин является случайность. Мы привыкли думать, что компьютеры детерминированы, но на самом деле многие алгоритмы машинного обучения, особенно те, что используются в генерации, опираются на псевдослучайные числа. Если мы не контролируем эти "случайности", результаты будут меняться от запуска к запуску.

Мы говорим о таких вещах, как:

- Инициализация весов нейронных сетей: Практически все современные генеративные модели, такие как GANs, VAEs или трансформеры, начинают обучение с случайной инициализации весов. Если эта инициализация отличается, даже на крошечную долю, путь обучения модели может измениться до неузнаваемости, приводя к совершенно разным генерациям.

- Случайные "семена" (seeds): Для того чтобы сделать псевдослучайные последовательности воспроизводимыми, мы используем семена. Однако мы часто забываем устанавливать их для всех источников случайности: для Python, NumPy, PyTorch, TensorFlow, CUDA и других библиотек. Мы обнаружили, что даже если установить одно общее семя, какая-то библиотека может использовать свой собственный генератор случайных чисел, который останется неконтролируемым.

- Перемешивание данных (shuffling): Во время обучения мы обычно перемешиваем данные в батчах. Если алгоритм перемешивания не детерминирован или использует системное время для инициализации, порядок данных в каждом батче будет разным, что повлияет на градиенты и, в конечном итоге, на обученную модель.

- Многопоточность и параллельные вычисления: Когда мы используем несколько потоков или GPU, порядок выполнения операций может быть не детерминирован. Это означает, что операции с плавающей точкой, которые математически коммутативны, могут быть выполнены в разном порядке, приводя к крошечным, но накапливающимся различиям в численных результатах. Эти различия могут быть настолько малы, что остаются незамеченными, но в глубоких сетях они могут усиливаться и приводить к существенным расхождениям в генерации.

Несоответствие вычислительной среды: не только "работает на моей машине"

Фраза "работает на моей машине" стала своего рода мемом в IT-сообществе, и она как нельзя лучше описывает проблему невоспроизводимости из-за различий в вычислительной среде. Мы часто недооцениваем, насколько сильно окружающая нас инфраструктура влияет на результаты.

Мы говорим о:

- Версии программного обеспечения: Разные версии библиотек (PyTorch, TensorFlow, Keras), Python, CUDA, cuDNN, драйверов GPU, операционной системы – все это может привести к изменениям в поведении алгоритмов. Обновление одной библиотеки может незаметно изменить способ, которым выполняется какая-либо операция, и это изменение может быть достаточно для того, чтобы повлиять на генерацию.

- Аппаратное обеспечение: Разные GPU (даже одной и той же модели, но с разным firmware или микрокодом), CPU и их архитектуры могут обрабатывать вычисления с плавающей точкой немного по-разному. Некоторые операции могут быть оптимизированы для конкретного оборудования, и эти оптимизации могут вносить небольшие, но важные различия.

- Системные настройки и переменные окружения: Иногда даже параметры ОС, такие как настройки локали, временных зон или специальные переменные окружения, могут влиять на поведение некоторых библиотек или на способы обработки данных. Мы видели случаи, когда результаты менялись просто из-за разницы в системных библиотеках, установленных на сервере и локальной машине.

Зависимости от данных: невидимая рука, формирующая генерацию

Данные – это кровь машинного обучения. И, как и кровь, они должны быть чистыми и консистентными. Мы часто фокусируемся на коде модели, забывая, что данные и их обработка играют не менее важную роль в формировании результатов генерации.

Наши основные наблюдения здесь:

- Версии данных: Данные могут меняться со временем. Мы можем добавлять новые образцы, исправлять ошибки, удалять дубликаты. Если мы не ведем строгий контроль версий данных, то даже небольшие изменения в обучающем наборе могут кардинально изменить поведение генеративной модели. Модель, обученная на одной версии датасета, может демонстрировать совершенно иные способности, чем та, что обучена на обновленной версии.

- Предобработка данных: Это один из самых коварных аспектов. Различные подходы к нормализации, токенизации, аугментации изображений или текста, а также порядку их применения, могут приводить к совершенно разным входным данным для модели. Мы сталкивались с тем, что даже небольшое изменение в порядке применения фильтров для изображений или в параметрах токенизатора для текста полностью меняло качество генерации.

- Внешние источники данных: Иногда наши модели зависят от внешних API или баз данных, которые могут меняться без нашего ведома. Если мы используем внешние ресурсы для получения данных или их обогащения, отсутствие фиксации этих версий может привести к непредсказуемым результатам;

Сложность моделей и алгоритмов: не все пути ведут в Рим

Современные генеративные модели становятся все более сложными, а их архитектуры и алгоритмы обучения – все более изощренными. Эта сложность сама по себе может стать источником невоспроизводимости.

Мы обратили внимание на:

- Недетерминированные алгоритмы: Некоторые алгоритмы, особенно связанные с кластеризацией, поиском ближайших соседей или даже некоторыми оптимизаторами, могут быть по своей природе недетерминированными, если не принять специальные меры. Это означает, что даже с одинаковыми входными данными и семенами, они могут давать немного разные результаты.

- Распределенное обучение: При обучении моделей на нескольких GPU или распределенных кластерах, синхронизация градиентов и весов может быть не детерминированной. Порядок, в котором градиенты собираются и применяются, может варьироваться, что приводит к незначительным, но накапливающимся различиям в итоговой модели.

- Зависимость от порядка обучения: Некоторые генеративные модели очень чувствительны к порядку, в котором им представлены обучающие примеры. Если этот порядок не фиксируется, то модель может "научиться" разным вещам или пойти по разным путям в пространстве параметров.

Трудности оценки: субъективность в мире чисел

Наконец, даже если нам кажется, что мы воспроизвели генерацию, возникает вопрос: как мы это измеряем? Оценка качества генеративных моделей сама по себе может быть источником невоспроизводимости, особенно когда речь идет о субъективных метриках.

Мы столкнулись с:

- Субъективные метрики: Если мы оцениваем качество с помощью человеческой оценки (например, "насколько реалистично изображение?", "насколько связен текст?"), то результаты могут сильно зависеть от конкретных оценщиков, их настроения, опыта и даже культурного контекста. Это не воспроизводимость в строгом смысле, но это добавляет неопределенности в процесс валидации.

- Нестандартные или неточные автоматические метрики: Многие автоматические метрики для генеративных моделей (FID, Inception Score для изображений; BLEU, ROUGE для текста) могут быть чувствительны к деталям их реализации, используемым предобученным моделям (например, Inception-v3 для FID) и даже к случайным факторам при их вычислении. Мы видели, как небольшие различия в реализации метрики приводили к разным числовым значениям, даже если сама генерация была идентичной.

- Выбор тестовых данных: Если мы не используем фиксированный, стандартизированный набор тестовых данных для оценки, то сравнение разных генераций становится невозможным. Случайный выбор подмножества для тестирования может дать ложное представление о качестве или воспроизводимости.

"Сама по себе наука не имеет ценности, если ее результаты не могут быть проверены и подтверждены другими. Воспроизводимость – это золотой стандарт, который отличает истинное знание от случайных наблюдений."

Наш путь к воспроизводимости: личный опыт и уроки

Теперь, когда мы осветили основные причины, давайте поговорим о том, как мы справляемся с этими вызовами на практике. Наш путь к воспроизводимости не был легким, он был полон разочарований, бессонных ночей и моментов, когда казалось, что мы зашли в тупик. Но каждый такой момент становился ценным уроком, который помогал нам выработать более надежные стратегии.

Мы помним один случай, когда мы работали над генеративной моделью для создания музыкальных фрагментов. Мы добились, как нам казалось, потрясающих результатов. Мелодии были гармоничными, ритмичными, и мы были готовы представить их миру. Но когда мы попытались воспроизвести эти же результаты на другом сервере, чтобы продемонстрировать их коллегам, мы получили совершенно иное звучание – хаотичное и немелодичное. Это был холодный душ, который заставил нас пересмотреть весь наш подход к разработке и документированию.

После нескольких дней отладки и сравнения сред, мы обнаружили, что проблема крылась в комбинации старой версии PyTorch на первом сервере и более новой на втором, а также в том, что мы не фиксировали семена для некоторых внутренних операций PyTorch. Казалось бы, мелочи, но они полностью изменили поведение модели. С тех пор мы стали настоящими параноиками в вопросах контроля версий и фиксации всех возможных источников случайности.

Практические стратегии для достижения воспроизводимости

Основываясь на нашем опыте, мы разработали и внедрили ряд стратегий, которые значительно улучшили воспроизводимость наших генеративных моделей. Это не панацея, но это набор лучших практик, которые мы теперь используем по умолчанию в каждом проекте.

Строгий контроль версий всего: код, данные, окружение

Это, пожалуй, самый фундаментальный шаг. Мы используем Git не только для кода, но и для всего, что может меняться.

- Версионирование кода: Это само собой разумеющееся. Мы используем ветки, коммиты и теги, чтобы точно знать, какая версия кода использовалась для получения конкретного результата.

- Версионирование данных (DVC, Git LFS): Для больших наборов данных, которые не помещаются в обычный Git репозиторий, мы используем такие инструменты, как DVC (Data Version Control) или Git LFS (Large File Storage). Они позволяют нам отслеживать изменения в данных и связывать конкретную версию данных с конкретной версией кода. Это критически важно, поскольку, как мы упоминали, даже небольшие изменения в данных могут полностью изменить генерацию.

- Версионирование зависимостей и окружения: Мы всегда фиксируем версии всех библиотек и пакетов. Для Python мы используем

requirements.txtилиPipfile.lock. Но идем дальше: мы также записываем версии CUDA, cuDNN, драйверов GPU и даже операционной системы.

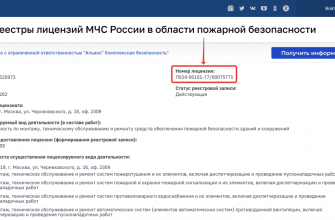

Пример таблицы для версионирования зависимостей:

| Компонент | Версия | Примечание |

|---|---|---|

| Python | 3.9.7 | Использовался Anaconda |

| PyTorch | 1.10.0+cu113 | Сборка с CUDA 11.3 |

| TensorFlow | 2.7.0 | CPU-only, для утилитарных скриптов |

| CUDA Toolkit | 11.3 | |

| cuDNN | 8.2.0 | |

| Операционная система | Ubuntu 20.04 LTS | |

| NVIDIA Driver | 470.82.00 |

Тотальное управление случайностью: никаких сюрпризов

Для борьбы с вездесущей случайностью мы выработали привычку устанавливать семена везде, где это возможно.

- Глобальные семена: Мы устанавливаем семя для Python, NumPy, PyTorch/TensorFlow, а также для системных генераторов, если это применимо. Важно помнить, что PyTorch, например, требует установки семян для CPU и GPU отдельно.

- Детерминированные алгоритмы: В PyTorch мы используем

torch.backends.cudnn.deterministic = Trueиtorch.backends.cudnn.benchmark = False. Это может немного замедлить обучение, но гарантирует детерминированность операций cuDNN. - Фиксация порядка данных: При создании загрузчиков данных (dataloaders) мы отключаем случайное перемешивание (

shuffle=False) для валидационных и тестовых наборов, а для обучающего набора мы можем использовать детерминированный генератор случайных чисел для перемешивания, если это необходимо.

Пример кода для установки семян (Python/PyTorch):

import random

import numpy as np

import torch

def set_seed(seed):

random.seed(seed)

np.random.seed(seed)

torch.manual_seed(seed)

if torch.cuda.is_available:

torch.cuda.manual_seed(seed)

torch.cuda.manual_seed_all(seed) # для нескольких GPU

torch.backends.cudnn.deterministic = True

torch.backends.cudnn.benchmark = False # может замедлить, но гарантирует детерминизм

Вызов функции в начале скрипта

set_seed(42)

Изоляция окружения: контейнеры и виртуальные машины

Чтобы избежать проблемы "работает на моей машине", мы активно используем технологии изоляции окружения.

- Docker: Это наш основной инструмент. Мы создаем Docker-образы, которые содержат все необходимые зависимости, точные версии библиотек, CUDA, cuDNN и даже драйверов. Это гарантирует, что независимо от того, где запускается наш код – на локальной машине, на облачном сервере или на кластере – окружение будет идентичным. Мы всегда включаем в Dockerfile команды для установки всех системных зависимостей, а также Python-пакетов из

requirements.txt. - Conda: Для более легкой изоляции, особенно на локальных машинах, мы используем Conda-окружения. Они позволяют нам создавать изолированные Python-среды с фиксированными версиями пакетов. Файл

environment.ymlфиксирует все зависимости, и мы можем легко воссоздать то же окружение.

Использование контейнеров значительно упрощает процесс воспроизведения экспериментов, так как мы делимся не только кодом, но и всем необходимым для его запуска.

Системы логирования и отслеживания экспериментов

Мы не можем воспроизвести то, о чем не помним или не записали. Поэтому мы активно используем инструменты для логирования и отслеживания всех аспектов наших экспериментов.

- MLflow, Weights & Biases (W&B), Comet ML: Эти платформы позволяют нам автоматически логировать параметры модели, метрики обучения, артефакты (включая сгенерированные образцы!), версии кода и среды. Это создает подробный журнал каждого эксперимента. Если мы хотим воспроизвести конкретный результат, мы просто находим соответствующий запуск в системе отслеживания, берем его параметры и используем их.

- Подробное логирование в коде: Помимо специализированных инструментов, мы также пишем подробные логи в наших скриптах. Мы записываем все ключевые параметры, хеши данных, версии библиотек, используемые GPU и даже температуру GPU во время обучения. Это может показаться избыточным, но в критических ситуациях эти детали спасали нас.

Стандартизация и документирование

Человеческий фактор играет огромную роль. Если мы не документируем наши шаги, даже при наличии всех технических средств, воспроизводимость будет затруднена.

- Четкие README: Каждый наш репозиторий имеет подробный файл

README.md, который объясняет, как запустить код, какие зависимости нужны, как подготовить данные и как воспроизвести ключевые результаты. Мы включаем в него точные команды для установки окружения и запуска скриптов. - Документация кода: Мы пишем чистый, хорошо прокомментированный код. Это помогает нам самим, а также другим членам команды понимать логику и избежать ошибок, которые могут привести к невоспроизводимости.

- Стандартизация процессов: Мы стараемся придерживаться единых стандартов для именования файлов, структурирования проектов, написания тестов и проведения экспериментов. Это уменьшает вероятность ошибок и делает процесс более предсказуемым.

Инструменты и технологии, которые нам помогают

Наш опыт показал, что без правильных инструментов достичь воспроизводимости крайне сложно. Мы активно используем следующие категории инструментов:

Инструменты для отслеживания экспериментов

Эти платформы стали незаменимыми в нашем рабочем процессе:

- MLflow: Отличный инструмент с открытым исходным кодом, который позволяет отслеживать параметры, метрики, версии кода и артефакты. Он интегрируется с различными ML-фреймворками и может быть развернут локально или в облаке. Мы используем его для централизованного хранения всех наших экспериментов, что позволяет легко сравнивать разные запуски и находить наиболее удачные конфигурации.

- Weights & Biases (W&B): Это мощная коммерческая платформа, которая предлагает более продвинутые функции визуализации, отчетности и совместной работы. Мы используем W&B для проектов, где требуется глубокий анализ и совместная работа с коллегами. Его возможности по визуализации гиперпараметров и сравнения моделей значительно упрощают принятие решений.

- Comet ML: Еще один коммерческий конкурент W&B, предлагающий схожий функционал. Выбор между ними часто сводится к личным предпочтениям и специфике проекта.

Инструменты для контейнеризации

Обеспечение идентичной среды – залог успеха:

- Docker: Как мы уже упоминали, Docker – это наше "все" для обеспечения идентичности среды. Он позволяет нам упаковать все зависимости, код и даже данные (если они не слишком велики) в единый, переносимый образ. Это значит, что если наш код работает в Docker-контейнере на одном сервере, он будет работать точно так же на любом другом сервере, где установлен Docker.

- Singularity: Альтернатива Docker, особенно популярная в высокопроизводительных вычислениях (HPC) и научных кругах, где вопросы безопасности и интеграции с существующими системами имеют первостепенное значение. Singularity позволяет пользователям запускать контейнеры без привилегий root, что делает его более безопасным для общих вычислительных ресурсов.

Инструменты для версионирования данных

Без контроля над данными, воспроизводимость невозможна:

- DVC (Data Version Control): DVC позволяет версионировать большие файлы данных, метаданные и модели, используя при этом существующие Git-репозитории для отслеживания. Он не хранит сами данные в Git, а лишь ссылки на них, а сами данные хранятся в удаленных хранилищах (S3, GCS, Azure Blob Storage, SSH, HDFS и т.д.). Это позволяет нам легко переключаться между версиями данных, как если бы это был код.

- Git LFS (Large File Storage): Расширение для Git, которое позволяет обрабатывать большие файлы. Вместо того чтобы хранить большие файлы непосредственно в репозитории Git, Git LFS сохраняет их в специальном хранилище и оставляет в репозитории только указатели на эти файлы. Это полезно для бинарных файлов, таких как обученные модели или небольшие наборы данных.

Эти инструменты, используемые в комбинации, формируют мощную экосистему для обеспечения воспроизводимости наших генеративных моделей. Они требуют определенного времени на освоение и внедрение, но, по нашему опыту, инвестиции в них окупаются сторицей, экономя огромное количество времени и нервов в долгосрочной перспективе.

Будущее воспроизводимой генерации: к стандарту индустрии

Проблема воспроизводимости не нова, но в свете стремительного развития генеративных моделей и их все более широкого применения она становится особенно актуальной. Мы видим, как сообщество активно работает над выработкой стандартов и лучших практик, чтобы сделать воспроизводимость нормой, а не исключением.

Что мы ожидаем в будущем?

- Автоматизация и интеграция: Мы верим, что в будущем все больше инструментов будут интегрироваться друг с другом, создавая бесшовные пайплайны для воспроизводимости. Возможно, появятся единые платформы, которые будут автоматически версионировать код, данные, окружение и логировать все аспекты эксперимента без необходимости ручной настройки.

- "Рецепты" воспроизводимости: Мы надеемся, что публикации и репозитории будут сопровождаться не только кодом и данными, но и "рецептами" воспроизводимости – подробными инструкциями, Docker-образами или Conda-окружениями, которые гарантируют повторение результатов.

- Образование и культура: Самое главное – это изменение культуры. Мы должны воспитывать новое поколение исследователей и разработчиков, для которых воспроизводимость является такой же неотъемлемой частью работы, как и написание тестов или документирование кода;

- Стандартизация метрик и бенчмарков: Для генеративных моделей особенно важны стандартизированные метрики и наборы данных для оценки. Это позволит более объективно сравнивать разные модели и их способности к генерации.

Наш опыт показывает, что достижение полной воспроизводимости – это сложная, многогранная задача. Это требует не только технических знаний, но и дисциплины, внимания к деталям и готовности инвестировать время в настройку правильных процессов. Однако, мы убеждены, что это инвестиция, которая окупается многократно, позволяя нам строить более надежные, прозрачные и проверяемые системы генерации. Это позволяет нам не только быстрее двигаться вперед, но и делиться нашими результатами с уверенностью, зная, что любой желающий сможет повторить наш успех. Мы строим не просто модели, мы строим доверие.

На этом статья заканчивается точка..

Подробнее

| Воспроизводимость в ML | Генеративные модели проблемы | Контроль версий данных | Docker для ML | Управление случайностью AI |

| MLflow для экспериментов | DVC версионирование | Настройка seed PyTorch | Воспроизводимые результаты нейросетей | Проблемы AI генерации |